La IA se aplica en diferentes cambios, desde la agricultura hasta los rayos X, gracias a su asombrosa capacidad de inferir rápidamente elecciones inteligentes basadas en montones de datos.

A medida que crecen los conjuntos de datos y las redes neuronales que los analizan, los usuarios recurren cada vez más a las GPU de NVIDIA para acelerar la inferencia de IA.

Para ver la inferencia en acción, simplemente analiza los detalles técnicos de los productos ampliamente utilizados por parte de compañías reconocidas.

GE Research, por ejemplo, implementa modelos de IA acelerados con GPU en las industrias de aviación, atención médica, energía y transporte. Automatizan la inspección de fábricas, habilitan trenes inteligentes, monitorean centrales eléctricas e interpretan imágenes médicas.

GE ejecuta estos modelos de IA en servidores de data centers en sistemas NVIDIA DGX con GPU V100 Tensor Core y en redes de procesamiento en el edge con módulos Jetson AGX Xavier. El hardware ejecuta el motor de inferencia NVIDIA TensorRT y sus bibliotecas de aceleración CUDA/cuDNN para deep learning, así como el kit de herramientas NVIDIA JetPack para módulos Jetson.

Las Aplicaciones de Video y de Contratos Aprovechan la Inferencia

En el mercado de consumo, dos de las aplicaciones de video móvil más populares del mundo ejecutan la inferencia de IA en las GPU de NVIDIA.

TikTok y Douyin, su precursor en China, alcanzaron en conjunto 1000 millones de descargas a nivel mundial en febrero de 2019. El desarrollador y host de las aplicaciones, ByteDance, carga la asombrosa cantidad de 50 millones de videos nuevos por día para 400 millones de usuarios activos diarios.

ByteDance ejecuta TensorRT en miles de servidores con GPU NVIDIA T4 y P4 para que los usuarios puedan buscar y obtener recomendaciones sobre videos geniales para ver. La compañía estima que ha ahorrado millones de dólares usando los productos NVIDIA mientras reduce la mitad de la latencia de sus servicios online.

En los negocios, Deloitte utiliza la inferencia de inteligencia artificial en su software dTrax para ayudar a las empresas a gestionar contratos complejos. Por ejemplo, dTrax puede encontrar y actualizar pasajes clave en largos acuerdos cuando las regulaciones cambian o cuando las compañías planean una gran adquisición.

En la actualidad, varias empresas de todo el mundo usan dTrax. El software, que se ejecuta en sistemas NVIDIA DGX-1 en data centers e instancias AWS P3 en cloud, ganó un premio de negocios inteligentes del Financial Times en 2019.

La Inferencia se Ejecuta Entre 2 y 10 Veces Más Rápido en GPU

Los trabajos de inferencia en modelos de tamaño promedio se ejecutan dos veces más rápido en GPU que en CPU y, en modelos grandes como RoBERTa, se ejecutan 10 veces más rápido, según las pruebas realizadas por Square, una compañía de servicios financieros.

Es por eso que las GPU de NVIDIA son clave para su objetivo de difundir el uso de su Square Assistant desde un programador virtual a un motor de IA conversacional que impulsa todos los productos de la compañía.

BMW Group acaba de anunciar que está desarrollando cinco nuevos tipos de robots utilizando la plataforma robótica NVIDIA Isaac para mejorar la logística en sus plantas de fabricación de automóviles. Uno de los nuevos bots, impulsado por NVIDIA Jetson AGX Xavier, ofrece hasta 32 billones de operaciones por segundo de rendimiento para tareas de visión por computadora, como percepción, estimación de posturas y planificación de rutas.

La inferencia de IA también está ocurriendo dentro de los automóviles. A finales de abril, la empresa china Xpeng presentó su sedán deportivo P7, totalmente eléctrico, que utiliza NVIDIA DRIVE AGX Xavier para ofrecer funciones de conducción automatizadas de nivel 3, mediante la inferencia de datos de un conjunto de sensores.

Expertos médicos de todo el mundo dieron docenas de charlas en GTC 2020 sobre el uso de IA en radiología, genómica, microscopía y otros campos de la salud. En una charla, Geraldine McGinty, presidenta del Colegio Estadounidense de Radiología, calificó a la IA como una «oportunidad única en la generación» para mejorar la calidad de la atención y reducir los costos.

En el sector agrícola, una creciente cosecha de startups está utilizando la IA para aumentar la eficiencia. Por ejemplo, Rabbit Tractors, un miembro del programa NVIDIA Inception, utiliza módulos Jetson Nano en robots multifunción para inferir a partir de datos de cámara y lidares a lo largo de una fila de siembre que necesitan para sembrar, rociar o cosechar.

La lista de empresas con casos de uso para inferencia acelerada por GPU continúa. Incluye la detección de fraude en American Express, la inspección industrial para P & G y los motores de búsqueda para los gigantes web.

La Inferencia Ofrece un Rendimiento Hasta 7 Veces con las A100

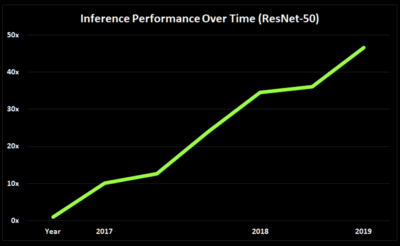

El potencial de inferencia en las GPU avanza sin obstáculos.

La arquitectura NVIDIA Ampere ofrece inferencia hasta una velocidad 7 veces superior gracias a la función de múltiples instancias de GPU. La compatibilidad de las GPU A100 con un nuevo enfoque de la baja densidad en redes neuronales profundas promete todavía más mejoras. Es una de las varias características nuevas de la arquitectura que se analizan en detalle en una descripción técnica de las GPU A100.

Hay muchos recursos para descubrir adónde podría llegar la inferencia y cómo empezar a aprovecharla.

Un webinar describe con más detalle el potencial de inferencia en la A100. Se pueden encontrar tutoriales, más historias de clientes y un documento técnico sobre el servidor de inferencia NVIDIA Triton para implementar modelos de IA a escala en una página dedicada a la plataforma de inferencia de NVIDIA.

Los usuarios pueden encontrar un entorno de ejecución de inferencia, herramientas de optimización y ejemplos de código en la página de NVIDIA TensorRT. Los modelos y contenedores previamente entrenados que empaquetan el código necesario para comenzar se encuentran en el catálogo de software de NGC.