La gente está de acuerdo: la computación acelerada es computación de bajo consumo.

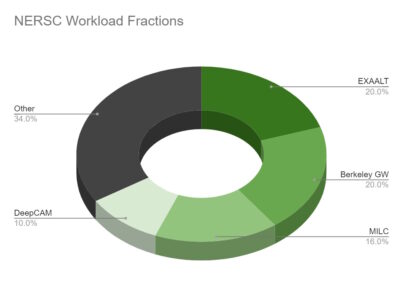

El Centro Nacional de Computación Científica de Investigación Energética ( NERSC ), la principal instalación del Departamento de Energía de EE. UU. para la ciencia abierta, midió los resultados en cuatro de sus aplicaciones clave de IA y computación de alto rendimiento.

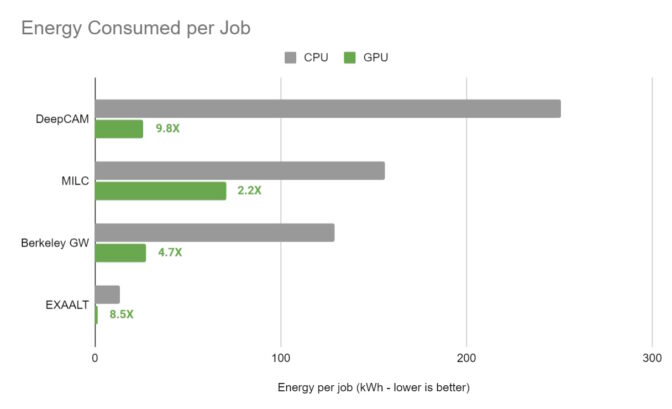

Registraron la velocidad de ejecución de las aplicaciones y la cantidad de energía que consumían en nodos solo de CPU y acelerados por GPU en Perlmutter , una de las supercomputadoras más grandes del mundo que utiliza GPU de NVIDIA.

Los resultados fueron claros. Acelerado con GPU NVIDIA A100 Tensor Core , la eficiencia energética aumentó 5 veces en promedio. Una aplicación para el pronóstico del tiempo registró ganancias de 9.8x.

Las GPU ahorran megavatios

En un servidor con cuatro GPU A100, NERSC consiguió hasta 12 veces más velocidades que un servidor x86 de dos sockets.

Eso significa que, al mismo nivel de rendimiento, el sistema acelerado por GPU consumiría 588 megavatios-hora menos de energía por mes que un sistema solo con CPU. Ejecutando la misma carga de trabajo en una instancia de nube NVIDIA A100 de cuatro vías durante un mes, los investigadores podrían ahorrar más de $ 4 millones en comparación con una instancia solo de CPU.

Medición de aplicaciones del mundo real

Los resultados son significativos porque se basan en mediciones de aplicaciones del mundo real, no en puntos de referencia sintéticos.

Las ganancias significan que los más de 8000 científicos que usan Perlmutter pueden abordar desafíos más grandes, abriendo la puerta a más avances.

Entre los muchos casos de uso de las más de 7100 GPU A100 en Perlmutter, los científicos están investigando las interacciones subatómicas para encontrar nuevas fuentes de energía verde.

Avance de la ciencia en todas las escalas

Las aplicaciones probadas por NERSC abarcan dinámica molecular, ciencia de materiales y pronóstico del tiempo.

Por ejemplo, MILC simula las fuerzas fundamentales que mantienen unidas las partículas en un átomo. Se utiliza para avanzar en la computación cuántica, estudiar la materia oscura y buscar los orígenes del universo.

BerkeleyGW ayuda a simular y predecir las propiedades ópticas de materiales y nanoestructuras, un paso clave hacia el desarrollo de baterías y dispositivos electrónicos más eficientes.

EXAALT, que obtuvo una ganancia de eficiencia de 8,5 veces en las GPU A100, resuelve un desafío fundamental en la dinámica molecular. Permite a los investigadores simular el equivalente a videos cortos de movimientos atómicos en lugar de las secuencias de instantáneas que brindan otras herramientas.

La cuarta aplicación de las pruebas, DeepCAM, se utiliza para detectar huracanes y ríos atmosféricos en los datos climáticos. Obtuvo una ganancia de 9.8x en eficiencia energética cuando se aceleró con GPU A100.

Ahorros con computación acelerada

Los resultados de NERSC se hacen eco de cálculos anteriores de los ahorros potenciales con la computación acelerada. Por ejemplo, en un análisis separado que realizó NVIDIA, las GPU ofrecieron una eficiencia energética 42 veces mayor en la inferencia de IA que las CPU.

Eso significa que cambiar todos los servidores solo de CPU que ejecutan IA en todo el mundo a sistemas acelerados por GPU podría ahorrar la friolera de 10 billones de vatios-hora de energía al año. Eso es como ahorrar la energía que consumen 1,4 millones de hogares en un año.

Acelerando la empresa

No es necesario ser científico para obtener mejoras en la eficiencia energética con la computación acelerada.

Las empresas farmacéuticas están utilizando la simulación acelerada por GPU y la IA para acelerar el proceso de descubrimiento de fármacos . Los fabricantes de automóviles como BMW Group lo están utilizando para modelar fábricas enteras .

Se encuentran entre las crecientes filas de empresas a la vanguardia de lo que el fundador y CEO de NVIDIA, Jensen Huang, llama una revolución industrial de HPC , impulsada por la computación acelerada y la IA.