DeepSeek-R1 es un modelo abierto con capacidades de razonamiento de última generación. En lugar de ofrecer respuestas directas, los modelos de razonamiento como DeepSeek-R1 realizan múltiples pases de inferencia sobre una consulta, llevando a cabo métodos de cadena de pensamiento, consenso y búsqueda para generar la mejor respuesta.

La realización de esta secuencia de pases de inferencia, utilizando la razón para llegar a la mejor respuesta, se conoce como escalado en tiempo de prueba. DeepSeek-R1 es un ejemplo perfecto de esta ley de escalado, ya que demuestra por qué la computación acelerada es fundamental para las demandas de la inferencia de IA basada en agentes.

A medida que se permite a los modelos «pensar» iterativamente en el problema, crean más tokens de salida y ciclos de generación más largos, por lo que la calidad del modelo continúa escalando. El cálculo en tiempo de prueba significativo es fundamental para permitir tanto la inferencia en tiempo real como las respuestas de mayor calidad de modelos de razonamiento como DeepSeek-R1, lo que requiere implementaciones de inferencia más grandes.

R1 ofrece una precisión líder para tareas que exigen inferencia lógica, razonamiento, matemáticas, codificación y comprensión del lenguaje, al mismo tiempo que ofrece una alta eficiencia de inferencia.

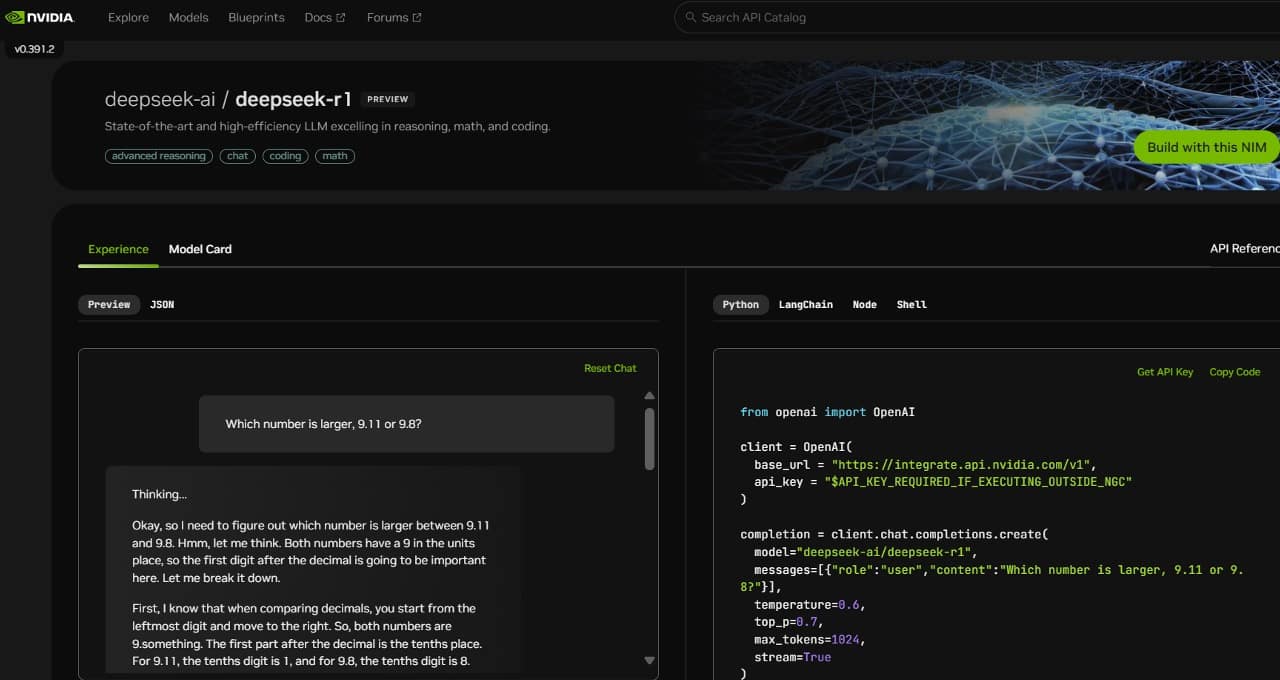

Para ayudar a los desarrolladores a experimentar de forma segura con estas capacidades y crear sus propios agentes especializados, el modelo DeepSeek-R1 de 671 mil millones de parámetros ya está disponible como una vista previa de microservicios NVIDIA NIM en build.nvidia.com. El microservicio NIM de DeepSeek-R1 puede entregar hasta 3.872 tokens por segundo en un solo sistema NVIDIA HGX H200.

Los desarrolladores pueden probar y experimentar con la interfaz de programación de aplicaciones (API), que se espera que esté disponible pronto como un microservicio NIM descargable, parte de la plataforma de software NVIDIA AI Enterprise.

El microservicio NIM de DeepSeek-R1 simplifica las implementaciones con soporte para API estándar de la industria. Las empresas pueden maximizar la seguridad y la privacidad de los datos ejecutando el microservicio NIM en su infraestructura de computación acelerada preferida. Con NVIDIA AI Foundry con el software NVIDIA NeMo, las empresas también podrán crear microservicios DeepSeek-R1 NIM personalizados para agentes de IA especializados.

DeepSeek-R1: Un Ejemplo Perfecto de Escalado en Tiempo de Prueba

DeepSeek-R1 es un modelo de gran mezcla de expertos (MoE). Incorpora la impresionante cantidad de 671 mil millones de parámetros, 10 veces más que muchos otros LLM populares de código abierto, lo que admite una gran longitud de contexto de entrada de 128,000 tokens. El modelo también utiliza un número extremo de expertos por capa. Cada capa de R1 tiene 256 expertos, y cada token se enruta a ocho expertos separados en paralelo para su evaluación.

La entrega de respuestas en tiempo real para R1 requiere muchas GPU con alto rendimiento de cómputo, conectadas con comunicación de alto ancho de banda y baja latencia para enrutar tokens de solicitud a todos los expertos para la inferencia. En combinación con las optimizaciones de software disponibles en el microservicio NVIDIA NAM, un solo servidor con ocho GPU H200 conectadas mediante NVLink y NVLink Switch puede ejecutar el modelo DeepSeek-R1 completo de 671 mil millones de parámetros a una velocidad de hasta 3.872 tokens por segundo. Este rendimiento es posible gracias al uso del motor de transformer FP8 de la arquitectura NVIDIA Hopper en cada capa, y los 900GB/s de ancho de banda NVLink para la comunicación experta del MoE.

Obtener todas las operaciones de coma flotante por segundo (FLOPS) de rendimiento de una GPU es fundamental para la inferencia en tiempo real. La arquitectura NVIDIA Blackwell de próxima generación dará un gran impulso al escalado en tiempo de prueba en modelos de razonamiento como DeepSeek-R1 con Tensor Cores de quinta generación que pueden ofrecer hasta 20 petaflops de rendimiento de cómputo máximo FP4 y un dominio NVLink de 72 GPU optimizado específicamente para la inferencia.

Comience Ahora con el Microservicio NIM de DeepSeek-R1

Los desarrolladores pueden experimentar el microservicio NIM DeepSeek-R1, ahora disponible en build.nvidia.com. Mira cómo funciona:

Con NVIDIA NIM, las empresas pueden implementar DeepSeek-R1 con facilidad y asegurarse de obtener la alta eficiencia necesaria para los sistemas de agentes de IA.

Consulte el aviso sobre la información del producto de software.