Las GPUs GeForce RTX 5090 y 5080 de NVIDIA, basadas en la innovadora arquitectura NVIDIA Blackwell, ofrecen velocidades de fotogramas hasta 8 veces más rápidas con la tecnología NVIDIA DLSS 4, menor latencia con NVIDIA Reflex 2 y fidelidad gráfica mejorada con los sombreadores neuronales NVIDIA RTX.

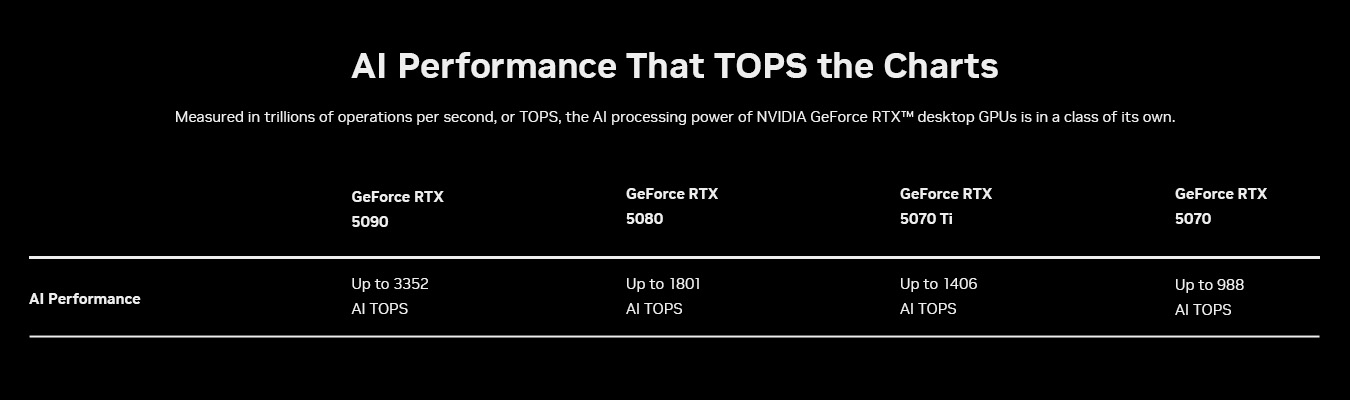

Estas GPUs se crearon para acelerar las cargas de trabajo de IA generativa más recientes, ofreciendo hasta 3352 billones de operaciones de IA por segundo (TOPS), activando experiencias increíbles para entusiastas de la IA, jugadores, creadores y desarrolladores.

Para ayudar a los desarrolladores y entusiastas de la IA a aprovechar estas capacidades, NVIDIA presentó en la feria CESl el mes pasado NVIDIA NIM y AI Blueprints para RTX. Los NVIDIA NIM microservices son modelos de IA generativa previamente empaquetados que permiten a los desarrolladores y entusiastas obtener fácilmente IA generativa, iterar rápidamente y aprovechar la potencia de RTX para acelerar la IA en PC con Windows. Los «NVIDIA AI Blueprints» son proyectos de referencia que muestran a los desarrolladores cómo utilizar los NIM microservices para crear la próxima generación de experiencias de IA.

NIM y IA Blueprints están optimizados para GPUs GeForce RTX Serie 50. Estas tecnologías funcionan juntas a la perfección para ayudar a desarrolladores y entusiastas a construir, generar y ofrecer experiencias de IA de vanguardia en PC con IA.

NVIDIA NIM Acelera la IA generativa en PCs

Aunque el desarrollo de modelos de IA avanza rápidamente, llevar estas innovaciones a las PCs sigue siendo un desafío para muchas personas. Los modelos publicados en plataformas como Hugging Face deben ser seleccionados, adaptados y cuantificados para que funcionen en PC. También deben integrarse en nuevas interfaces de programación de aplicaciones (API) de IA para garantizar la compatibilidad con las herramientas existentes, y convertirse en backends de inferencia optimizados para obtener el máximo rendimiento.

Los NIM microservices de NVIDIA para PC y estaciones de trabajo con IA RTX pueden facilitar la complejidad de este proceso al proporcionar acceso a modelos de IA desarrollados por NVIDIA e impulsados por la comunidad. Estos microservicios son fáciles de descargar y conectar a través de API estándar de la industria y abarcan las modalidades clave esenciales para PCs con IA. También son compatibles con una amplia gama de herramientas de IA y ofrecen opciones de implementación flexibles, ya sea en PCs, en centros de datos o en la nube.

NIM microservices incluyen todo lo necesario para ejecutar modelos optimizados en PCs con RTX GPU, incluyendo motores preconstruidos para GPU específicas, el kit de desarrollo de software (SDK) NVIDIA TensorRT, la biblioteca de código abierto NVIDIA TensorRT-LLM para inferencia acelerada utilizando Núcleos Tensor y más.

Microsoft y NVIDIA trabajaron juntos para activar NIM microservices y AI Blueprints para RTX en Windows Subsystem for Linux (WSL2). Con WSL2, los mismos contenedores de IA que se ejecutan en las GPUs de los centros de datos ahora pueden ejecutarse de manera eficiente en PC RTX, lo que facilita a los desarrolladores la creación, prueba e implementación de modelos de IA en todas las plataformas.

Con su incorporación, los NIM y los Blueprints de IA aprovechan las innovaciones clave de la arquitectura Blackwell en la que se basa la GeForce RTX Serie 50, incluidos los Núcleos Tensor de quinta generación y la compatibilidad con la precisión FP4.

Los Núcleos Tensores Impulsan la IA de Nueva Generación en Rendimiento

Los cálculos de la IA son increíblemente exigentes y requieren una gran cantidad de potencia de procesamiento. Ya sea para generar imágenes y videos o para comprender el lenguaje y tomar decisiones en tiempo real, los modelos de IA dependen de cientos de billones de operaciones matemáticas que se completan cada segundo. Para mantener el ritmo, las computadoras necesitan hardware especializado construido específicamente para la IA. Las GPUs para desktop NVIDIA GeForce RTX ofrecen hasta 3,352 TOPS de IA para una velocidad y eficiencia inigualables en flujos de trabajo impulsados por IA.

En 2018, las GPUs GeForce RTX de NVIDIA cambiaron las reglas del juego al introducir los Núcleos Tensor, procesadores de IA dedicados diseñados para manejar estas cargas de trabajo intensivas. A diferencia de los núcleos informáticos tradicionales, los Núcleos Tensor están diseñados para acelerar la IA mediante cálculos más rápidos y eficientes. Este avance ayudó a popularizar los juegos, las herramientas creativas y las aplicaciones de producción basados en IA.

La arquitectura Blackwell lleva la aceleración de la IA al siguiente nivel. Los Núcleos Tensor de 5.ª generación de las GPU Blackwell ofrecen hasta 3,352 TOPS de IA para manejar tareas de IA aún más exigentes y ejecutar simultáneamente múltiples modelos de IA. Esto se traduce en experiencias más rápidas impulsadas por la IA, desde la renderización en tiempo real hasta los asistentes inteligentes, que allanan el camino para una mayor innovación en los juegos, la creación de contenidos y mucho más.

FP4 — Modelos Más Pequeños, Mayor Rendimiento

Otra forma de optimizar el rendimento de la IA es mediante la cuantificación, una técnica que reduce el tamaño de los modelos, activando los modelos para que se ejecuten más rápido mientras se reducen los requisitos de memoria.

Ingrese FP4, un formato de cuantificación avanzado que permite que los modelos de IA se ejecuten más rápido y más ágil sin comprometer la calidad de salida. En comparación con FP16, reduce el tamaño del modelo hasta en un 60 % y más del doble de rendimiento, con una degradación mínima.

Por ejemplo, el modelo FLUX.1 [dev] de Black Forest Labs en FP16 requiere más de 23 GB de VRAM, lo que significa que sólo puede ser compatible con la GeForce RTX 4090 y las GPUs profesionales. Con FP4, FLUX.1 [dev] requiere menos de 10 GB, por lo que puede ejecutarse localmente en más GPUs GeForce RTX.

En una GeForce RTX 4090 con FP16, el modelo FLUX.1 [dev] puede generar imágenes en 15 segundos con solo 30 pasos. Con una GeForce RTX 5090 con FP4, las imágenes se pueden generar en poco más de cinco segundos.

FP4 es compatible de forma nativa con la arquitectura Blackwell, lo que facilita más que nunca la implementación de IA de alto rendimiento en PCs locales. También está integrado en NIM microservices, optimizando eficazmente modelos que antes eran difíciles de cuantificar. Al activar un procesamiento de IA más eficiente, FP4 ayuda a ofrecer experiencias de IA más rápidas e inteligentes para la creación de contenidos.

IA Blueprints Potencia los Flujos de Trabajo de IA Avanzada en RTX PCs

NVIDIA AI Blueprints, basado en NIM microservices, proporciona implementaciones de referencia optimizadas y previamente empacadas que facilitan el desarrollo de proyectos avanzados impulsados por IA, ya sea para seres humanos digitales, generadores de podcasts o asistentes de aplicaciones.

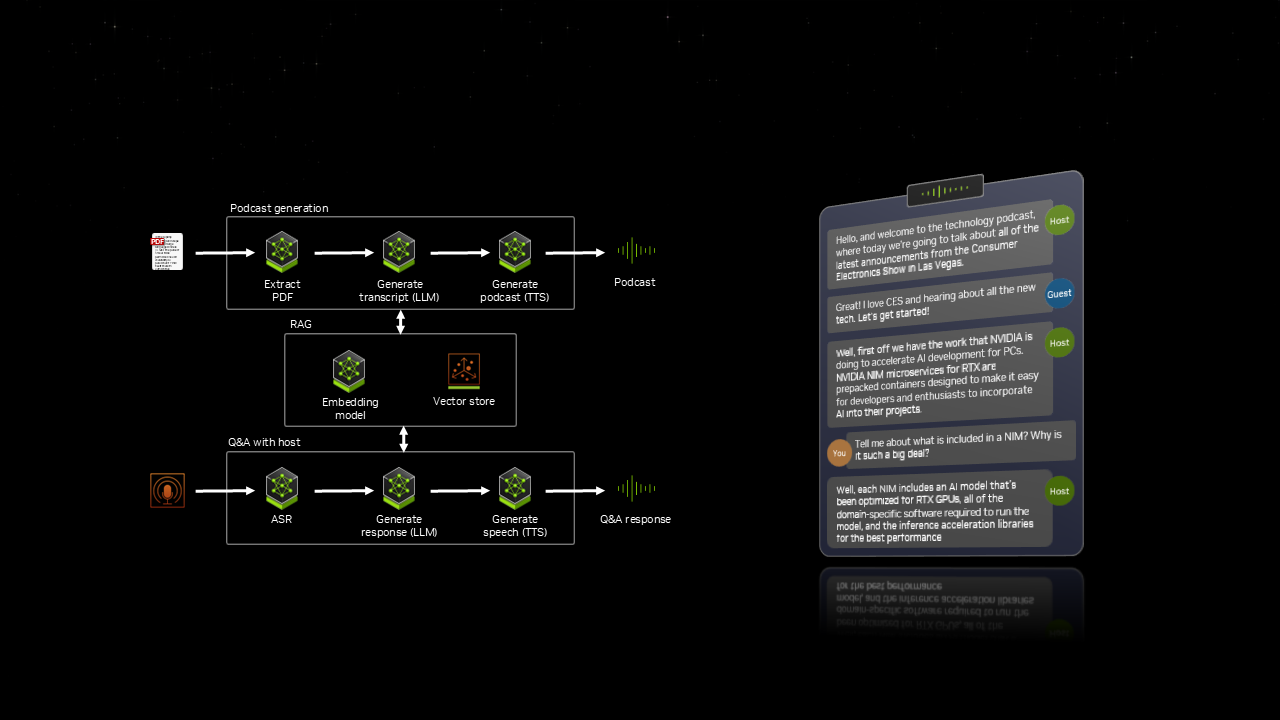

En el CES, NVIDIA presentó PDF to Podcast, un modelo que permite a los usuarios convertir un PDF en un divertido podcast e incluso crear después una sesión de preguntas y respuestas con el presentador del podcast de IA. Este flujo de trabajo integra siete modelos de IA diferentes, todos ellos trabajando en sincronía para ofrecer una experiencia dinámica e interactiva. El plan para convertir PDF en podcasts aprovecha varios modelos de IA para convertir perfectamente los PDF en podcasts atractivos, con una función interactiva de preguntas y respuestas presentada por un presentador de podcasts con IA.

Con IA Blueprints, los usuarios pueden pasar rápidamente de experimentar a desarrollar IA en PCs y estaciones de trabajo RTX.

NIM y IA Blueprints Próximamente en PCs y Estaciones de Trabajo RTX

IA Generativa está ampliando los límites de lo posible en juegos, creación de contenidos y más. Con NIM microservices y AI Blueprints, los últimos avances en IA ya no se limitan a la nube, ahora están optimizados para PC RTX. Con las GPUs RTX, los desarrolladores y entusiastas pueden experimentar, construir e implementar IA localmente, directamente desde sus PC y estaciones de trabajo.

NIM microservices y AI Blueprints estarán disponibles próximamente, con soporte de hardware inicial para las GPUs profesionales GeForce RTX Serie 50, GeForce RTX 4090 y 4080, y NVIDIA RTX 6000 y 5000. En el futuro se admitirán GPUs adicionales.5