La IA generativa está transformando el software de PC en experiencias innovadoras: desde humanos digitales hasta asistentes de escritura, agentes inteligentes y herramientas creativas.

Las PC NVIDIA RTX AI están impulsando esta transformación con tecnología que simplifica el comienzo de la experimentación con IA generativa y permite desbloquear un mayor rendimiento en Windows 11.

NVIDIA TensorRT se ha reinventado para las PC con IA RTX y combina el rendimiento líder de TensorRT con la creación de motores en el dispositivo justo a tiempo y un tamaño de paquete 8 veces más pequeño para una implementación de IA fluida en más de 100 millones de PC con IA RTX.

Anunciado en Microsoft Build, TensorRT para RTX es compatible de forma nativa con Windows ML , una nueva pila de inferencia que ofrece a los desarrolladores de aplicaciones una amplia compatibilidad de hardware y un rendimiento de última generación.

Para los desarrolladores que buscan funciones de IA listas para integrar, los kits de desarrollo de software (SDK) de NVIDIA ofrecen una amplia gama de opciones, desde NVIDIA DLSS hasta mejoras multimedia como NVIDIA RTX Video. Este mes, las principales aplicaciones de software de Autodesk, Bilibili, Chaos, LM Studio y Topaz Labs lanzan actualizaciones para desbloquear las funciones y la aceleración de la IA de RTX.

Los entusiastas y desarrolladores de IA pueden comenzar fácilmente con ella usando NVIDIA NIM : modelos de IA preconfigurados y optimizados que pueden ejecutarse en aplicaciones populares como AnythingLLM, Microsoft VS Code y ComfyUI. El modelo de generación de imágenes FLUX.1-schnell, disponible esta semana, estará disponible como microservicio NIM, y el popular microservicio NIM FLUX.1-dev se ha actualizado para ser compatible con más GPU RTX.

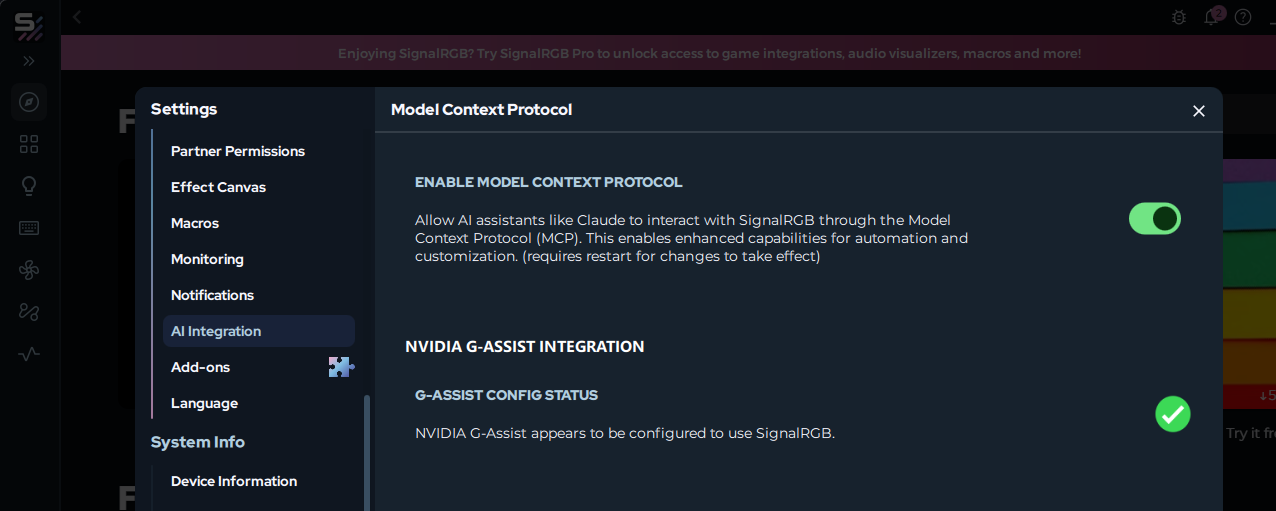

Quienes buscan una forma sencilla y sin código de adentrarse en el desarrollo de IA pueden aprovechar Project G-Assist (el asistente de IA para PC RTX en la app de NVIDIA) para crear complementos que controlen aplicaciones y periféricos de PC mediante IA de lenguaje natural. Ya están disponibles nuevos complementos de la comunidad, como la búsqueda web de Google Gemini, Spotify, Twitch, IFTTT y SignalRGB.

Inferencia de IA acelerada con TensorRT para RTX

La pila de software de PC con inteligencia artificial actual requiere que los desarrolladores sacrifiquen el rendimiento o inviertan en optimizaciones personalizadas para hardware específico.

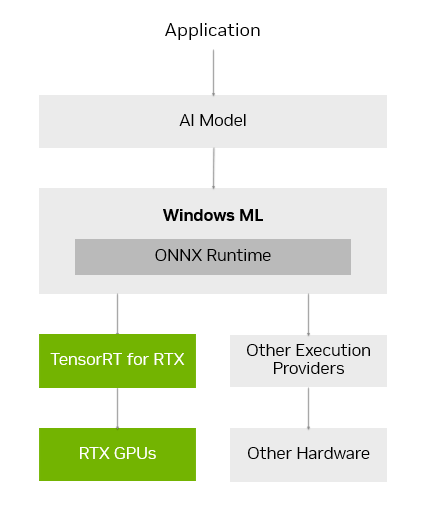

Windows ML se diseñó para resolver estos desafíos. Windows ML funciona con ONNX Runtime y se conecta a la perfección con una capa de ejecución de IA optimizada, proporcionada y mantenida por cada fabricante de hardware.

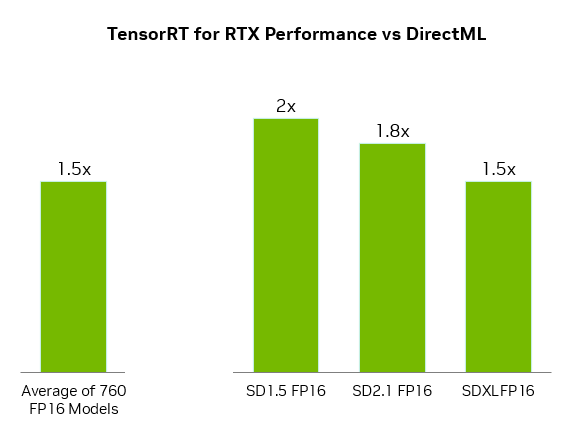

Para las GPU GeForce RTX, Windows ML utiliza automáticamente la biblioteca de inferencia TensorRT para RTX para un alto rendimiento y una implementación rápida. En comparación con DirectML, TensorRT ofrece un rendimiento un 50 % más rápido para cargas de trabajo de IA en PC.

Windows ML también ofrece ventajas para la calidad de vida de los desarrolladores. Puede seleccionar automáticamente el hardware adecuado (GPU, CPU o NPU) para ejecutar cada función de IA y descargar el proveedor de ejecución para ese hardware, eliminando la necesidad de empaquetar esos archivos en la aplicación. Esto permite que las últimas optimizaciones de rendimiento de TensorRT se entreguen a los usuarios en cuanto estén listos.

TensorRT, una biblioteca diseñada originalmente para centros de datos, se ha rediseñado para PC con IA RTX. En lugar de pregenerar motores TensorRT y empaquetarlos con la aplicación, TensorRT para RTX utiliza la creación de motores en tiempo real en el dispositivo para optimizar la ejecución del modelo de IA para la GPU RTX específica del usuario en cuestión de segundos. Además, el empaquetado de la biblioteca se ha optimizado, reduciendo significativamente su tamaño de archivo en ocho veces.

TensorRT para RTX está disponible para los desarrolladores a través de la vista previa de Windows ML hoy y estará disponible como un SDK independiente en NVIDIA Developer en junio.

Los desarrolladores pueden obtener más información en el blog de lanzamiento de TensorRT para RTX o en el blog de Windows ML de Microsoft .

Ampliación del ecosistema de IA en PC con Windows 11

Los desarrolladores que buscan añadir funciones de IA o mejorar el rendimiento de sus aplicaciones pueden aprovechar una amplia gama de SDK de NVIDIA. Entre ellos se incluyen NVIDIA CUDA y TensorRT para la aceleración de la GPU; NVIDIA DLSS y Optix para gráficos 3D; NVIDIA RTX Video y Maxine para multimedia; y NVIDIA Riva y ACE para IA generativa.

Las principales aplicaciones están lanzando actualizaciones este mes para habilitar funciones únicas utilizando estos SDK de NVIDIA, que incluyen:

- LM Studio, que lanzó una actualización de su aplicación para actualizar a la última versión de CUDA, aumentando el rendimiento en más del 30%.

- Topaz Labs, que está lanzando un modelo de video de IA generativo para mejorar la calidad del video, acelerado por CUDA.

- Chaos Enscape y Autodesk VRED, que están agregando DLSS 4 para un rendimiento más rápido y una mejor calidad de imagen.

- Bilibili, que integra funciones de NVIDIA Broadcast como Fondo virtual para mejorar la calidad de las transmisiones en vivo.

NVIDIA espera seguir trabajando con Microsoft y los principales desarrolladores de aplicaciones de IA para ayudarlos a acelerar sus funciones de IA en máquinas con RTX a través de la integración de Windows ML y TensorRT.

IA local simplificada con microservicios NIM y planos de IA

Comenzar a desarrollar IA en PC puede ser abrumador. Los desarrolladores y entusiastas de la IA deben seleccionar entre más de 1,2 millones de modelos de IA en Hugging Face, cuantificarlos en un formato que funcione correctamente en PC, encontrar e instalar todas las dependencias necesarias para ejecutarlos, y mucho más.

NVIDIA NIM facilita los primeros pasos al proporcionar una lista seleccionada de modelos de IA, preempaquetados con todos los archivos necesarios para ejecutarlos y optimizados para alcanzar el máximo rendimiento en GPU RTX. Además, al estar en contenedores, el mismo microservicio NIM puede ejecutarse sin problemas en PC o en la nube.

Los microservicios NVIDIA NIM están disponibles para descargar a través de build.nvidia.com o mediante las principales aplicaciones de IA como Anything LLM, ComfyUI y AI Toolkit para Visual Studio Code.

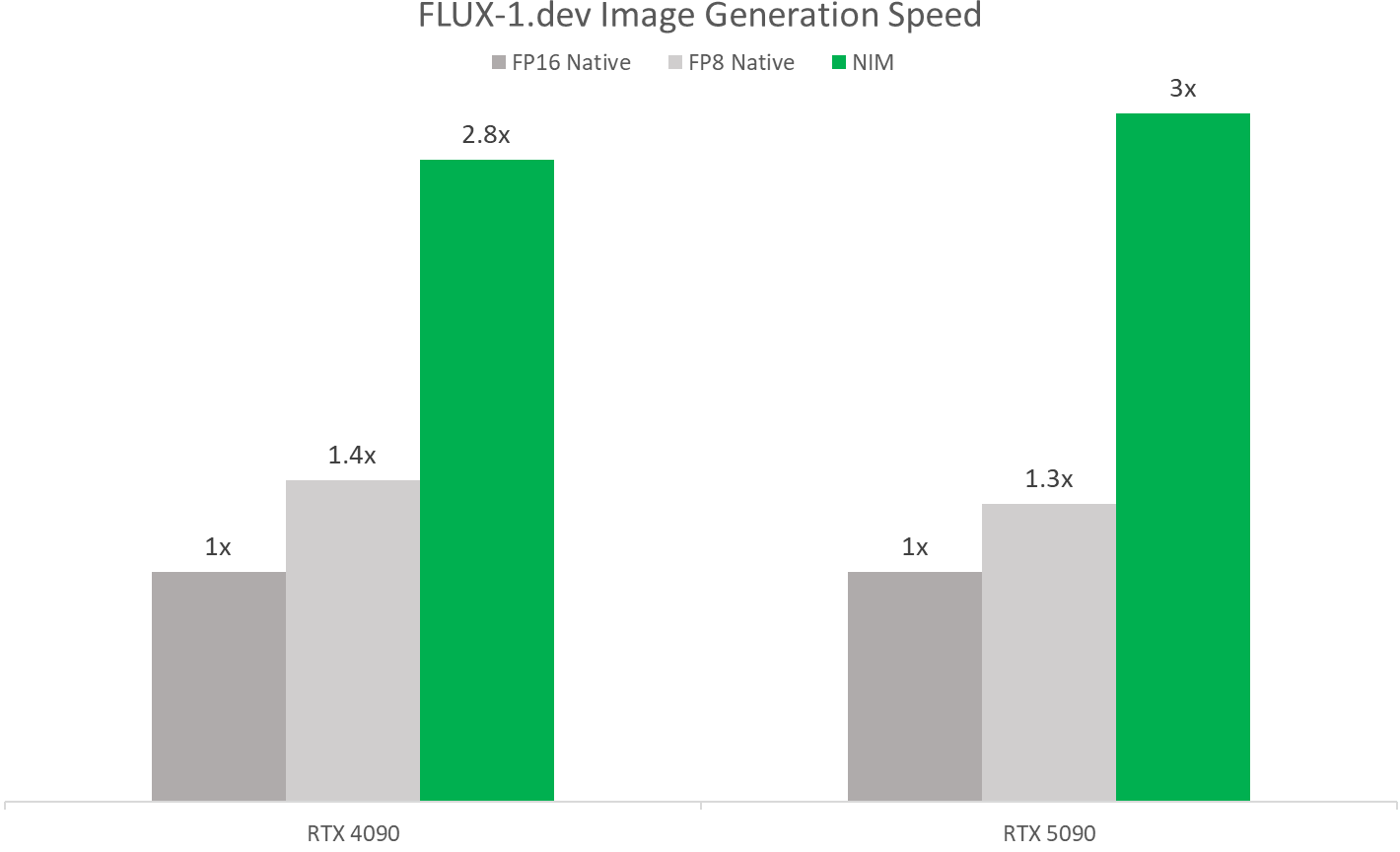

Durante COMPUTEX, NVIDIA lanzará el microservicio NIM FLUX.1-schnell, un modelo de generación de imágenes de Black Forest Labs para la generación rápida de imágenes, y actualizará el microservicio NIM FLUX.1-dev para agregar compatibilidad con una amplia gama de GPU GeForce RTX serie 50 y 40.

Estos microservicios NIM permiten un rendimiento más rápido con TensorRT y modelos cuantizados. En las GPU NVIDIA Blackwell, funcionan a más del doble de velocidad que de forma nativa, gracias a las optimizaciones de FP4 y RTX.

Los desarrolladores de IA también pueden impulsar su trabajo con NVIDIA AI Blueprints: flujos de trabajo y proyectos de muestra que utilizan microservicios NIM.

El mes pasado, NVIDIA lanzó NVIDIA AI Blueprint para IA generativa guiada en 3D , una potente forma de controlar la composición y los ángulos de cámara de las imágenes generadas utilizando una escena 3D como referencia. Los desarrolladores pueden modificar el plan de código abierto según sus necesidades o ampliarlo con funcionalidades adicionales.

Nuevos complementos y proyectos de muestra de Project G-Assist ya disponibles

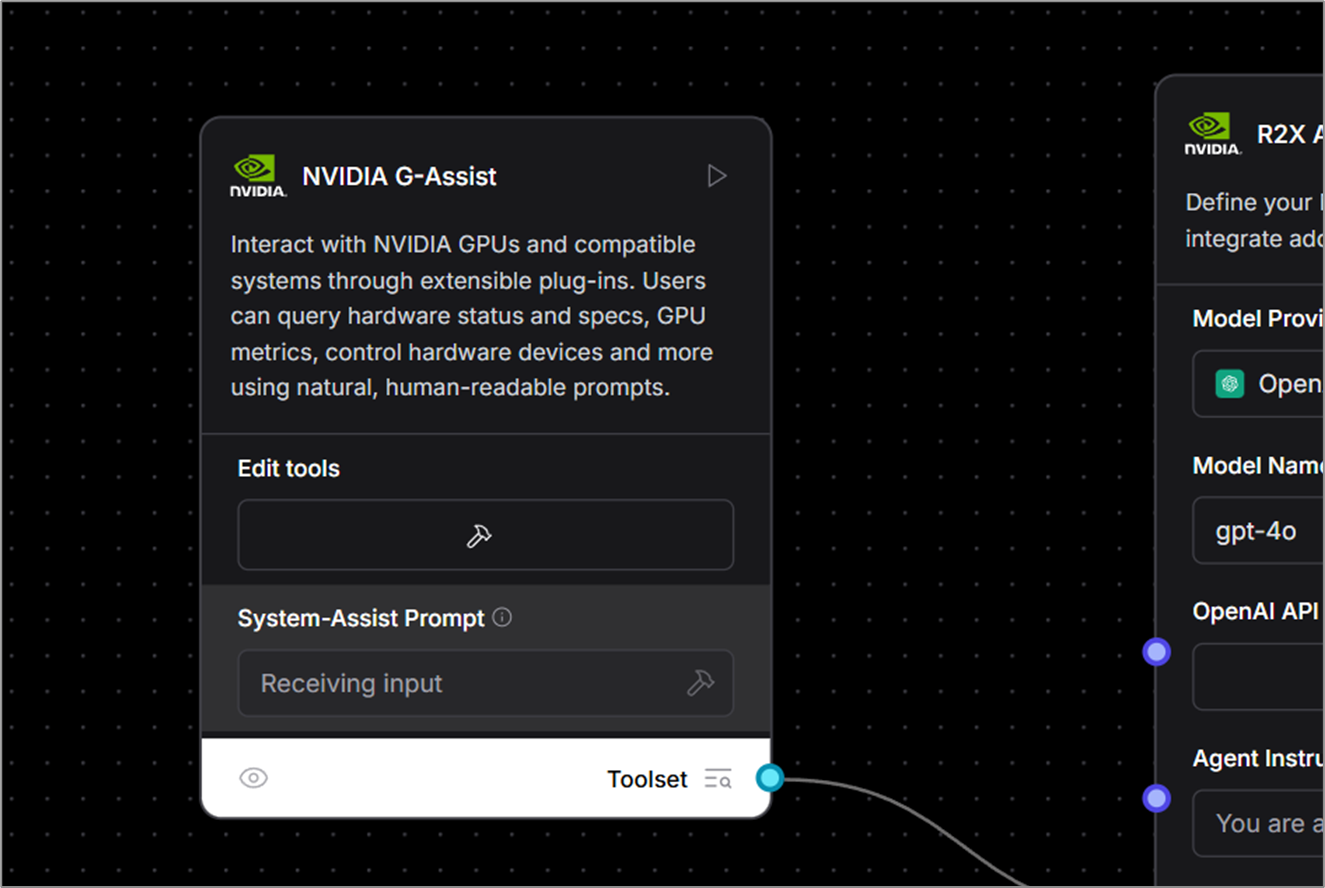

NVIDIA lanzó recientemente el Proyecto G-Assist , un asistente de IA experimental integrado en la app de NVIDIA. G-Assist permite a los usuarios controlar su sistema GeForce RTX mediante comandos de voz y texto sencillos, ofreciendo una interfaz más cómoda que los controles manuales distribuidos en numerosos paneles de control tradicionales.

Los desarrolladores también pueden usar Project G-Assist para crear fácilmente complementos, casos de uso del asistente de prueba y publicarlos a través de Discord y GitHub de NVIDIA .

El Constructor de Plugins del Proyecto G-Assist , una aplicación basada en ChatGPT que permite el desarrollo sin código o con poco código mediante comandos de lenguaje natural, facilita la creación de plugins. Estos complementos ligeros, impulsados por la comunidad, utilizan definiciones JSON sencillas y lógica Python.

Ya están disponibles en GitHub nuevos ejemplos de complementos de código abierto que muestran diversas maneras en que la IA integrada en el dispositivo puede optimizar los flujos de trabajo en PC y juegos. Entre ellos se incluyen:

- Gemini : el complemento Gemini existente que utiliza el modelo de lenguaje grande y gratuito basado en la nube de Google se ha actualizado para incluir capacidades de búsqueda web en tiempo real.

- IFTTT : un complemento que permite a los usuarios crear automatizaciones en cientos de puntos finales compatibles para activar rutinas de IoT, como ajustar las luces de la habitación o las cortinas inteligentes, o enviar las últimas noticias sobre juegos a un dispositivo móvil.

- Discord : un complemento que permite a los usuarios compartir fácilmente momentos destacados del juego o mensajes directamente en los servidores de Discord sin interrumpir el juego.

Explora el repositorio de GitHub para obtener más ejemplos, incluido el control de música con manos libres a través de Spotify, controles de estado de transmisión en vivo con Twitch y más.

Las empresas están adoptando la IA como la nueva interfaz para PC. Por ejemplo, SignalRGB está desarrollando un complemento G-Assist que permite un control unificado de la iluminación entre múltiples fabricantes. Los usuarios pronto podrán instalar este complemento directamente desde la app de SignalRGB.

A partir de esta semana, la comunidad de IA también podrá usar G-Assist como un componente personalizado en Langflow, lo que permitirá a los usuarios integrar capacidades de llamada de funciones en flujos de trabajo de código bajo o sin código, aplicaciones de IA y flujos de agentes.

Los entusiastas interesados en desarrollar y experimentar con los complementos del Proyecto G-Assist están invitados a unirse al canal Discord de desarrolladores de NVIDIA para colaborar, compartir creaciones y obtener apoyo.

Cada semana, la serie de blogs RTX AI Garage presenta innovaciones y contenido de IA impulsados por la comunidad para aquellos que buscan aprender más sobre los microservicios NIM y los planos de IA, así como también sobre la creación de agentes de IA , flujos de trabajo creativos, humanos digitales, aplicaciones de productividad y más en PC y estaciones de trabajo de IA.

Conéctese a NVIDIA AI PC en Facebook , Instagram , TikTok y X , y manténgase informado suscribiéndose al boletín de RTX AI PC .

Siga a NVIDIA Workstation en LinkedIn y X .

Consulte el aviso sobre la información del producto de software.