La computación moderna de alto rendimiento (HPC) permite algo más que cálculos rápidos: está impulsando sistemas de IA que están desbloqueando avances científicos.

La HPC ha pasado por muchas iteraciones, cada una provocada por una reutilización creativa de las tecnologías. Por ejemplo, las primeras supercomputadoras usaban componentes listos para usar. Más tarde, los investigadores construyeron potentes clústeres a partir de computadoras personales e incluso adaptaron tarjetas gráficas de games para el trabajo científico.

Los sistemas HPC actuales, muchos de ellos impulsados por la computación acelerada de NVIDIA, están diseñados para la velocidad. La última lista TOP500 de las supercomputadoras más potentes del mundo, presentada en ISC 2025, lo subraya, con NVIDIA impulsando el 77% de los sistemas de la lista.

Al mismo tiempo, las características innovadoras como los Tensor Cores proporcionan cálculos más rápidos para operaciones comunes como la multiplicación de matrices, y el mayor uso de técnicas como la precisión mixta (una técnica que combina múltiples formatos de precisión de coma flotante) están impulsando el rendimiento y la eficiencia energética, impulsando saltos en campos como la ciencia del clima y la medicina.

NVIDIA Impulsa a los Líderes del TOP500

NVIDIA continúa liderando el camino en supercomputación, impulsando 381 sistemas, de la última lista TOP500. Esto incluye una nueva entrada al top 10, la supercomputadora JUPITER del Jülich Supercomputing Centre, que debutó en el #4.

Ochenta y tres de los 100 principales sistemas del TOP500 utilizan ahora la computación acelerada, en comparación con sólo 17 que sólo utilizan CPU.

Además, los dos primeros sistemas de la última lista Green500 de las supercomputadoras FP64 más eficientes energéticamente del mundo funcionan con superchips NVIDIA GH200 Grace Hopper, y nueve de las 10 principales son aceleradas por NVIDIA.

Tensor Cores para la Ciencia

El rendimiento de la IA no solo proviene del aumento del volumen de operaciones de coma flotante. Cada vez más, se basa en la fusión de hardware con software, por ejemplo, mediante el uso de Tensor Cores.

Los Tensor Cores son componentes avanzados dentro de las GPU NVIDIA creados para acelerar las operaciones de matriz, los cálculos centrales detrás de la IA y el deep learning. Al manejar cálculos complejos de manera más eficiente, aceleran procesos como el entrenamiento de modelos y la inferencia.

Los Tensor Cores permiten cálculos más rápidos para operaciones de matrices comunes, especialmente a medida que las organizaciones pasan a precisiones más bajas como FP8 para el entrenamiento de modelos, casi duplicando el rendimiento con cada paso hacia abajo en la precisión mientras se mantiene la exactitud. Actualmente, solo ciertas operaciones dentro de las cargas de trabajo de simulación pueden aprovechar los Tensor Cores. Estas operaciones suelen ser una pequeña fracción del tiempo de ejecución total y rara vez tienen consecuencias para el rendimiento general entregado.

A medida que se dedica cada vez más espacio físico en las GPU a los Tensor Cores de baja precisión creados para la IA, se brinda una oportunidad para que la comunidad de HPC vuelva a reutilizar el hardware para avanzar en los descubrimientos científicos.

Para permitir esto, NVIDIA está invirtiendo en nuevos métodos para usar Tensor Cores para un conjunto más amplio de casos de uso relevantes para la simulación científica.

Un artículo de Yuki Uchino, del RIKEN Center for Computational Science, y Katsuhisa Ozaki, profesor del Shibaura Institute of Technology, demostró cómo las unidades enteras en las GPU pueden lograr una precisión arbitraria, incluido FP64, utilizando los aceleradores de multiplicación de matrices enteras en Tendor Cores y un algoritmo llamado esquema Ozaki.

Inspirada en este esquema, NVIDIA está desarrollando bibliotecas para acelerar los cálculos de tensores y matrices de alta precisión utilizando un conjunto más grande de Tensor Cores de GPU, centrándose en mejorar la precisión, el rendimiento y la eficiencia energética.

El uso de estas bibliotecas ya ha demostrado algunos beneficios sorprendentes: una simulación de silicio con aproximadamente 1.000 átomos expuestos a la luz ultravioleta se ejecutó 1,8 veces más rápido utilizando las bibliotecas que con el hardware FP64, al tiempo que proporcionó resultados idénticos, ahorrando tiempo y energía.

Con la ayuda de estas nuevas bibliotecas, las simulaciones de HPC comunes, como BerkeleyGW pronto podrá aprovechar los Tensor Cores de menor precisión, lo que permitirá saltos en el rendimiento y la eficiencia energética.

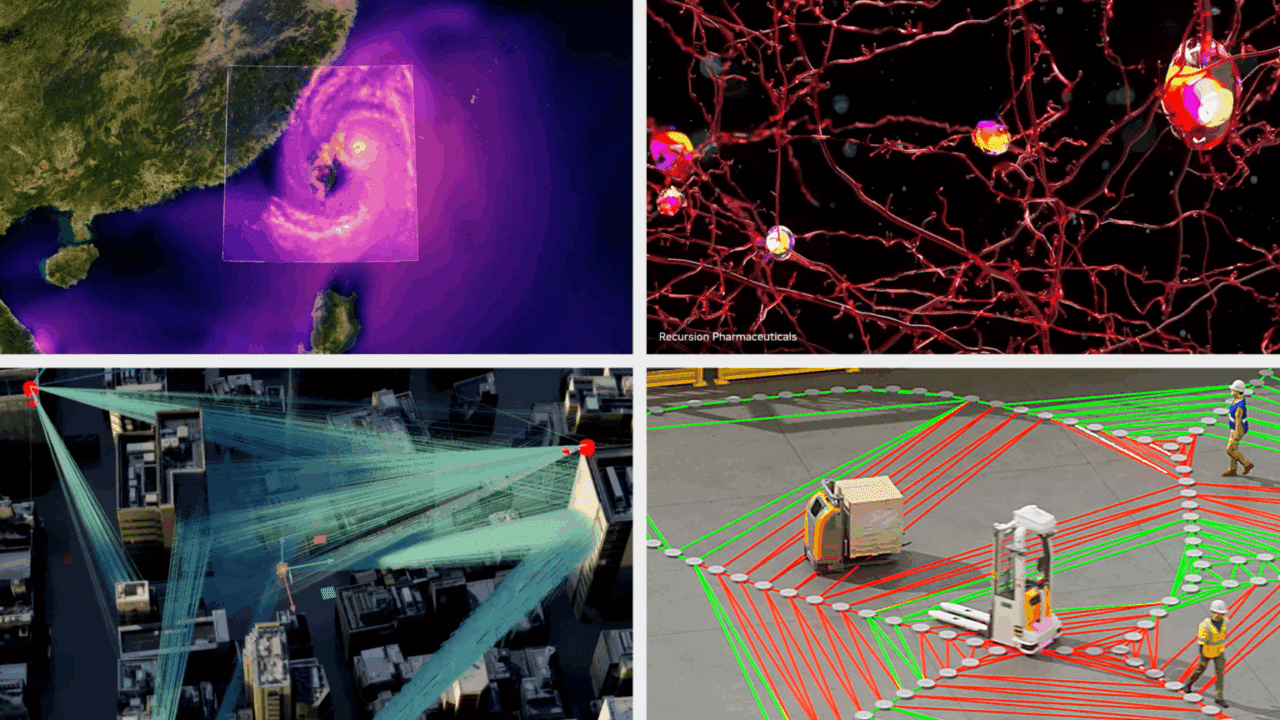

La Supercomputación de IA Hace Avanzar la Ciencia

Si bien la lista TOP500 destaca la velocidad de alta precisión de las supercomputadoras actuales, no cuenta la historia de su increíble impacto en el impulso de los descubrimientos científicos con una precisión e IA mixtas.

El año pasado, los Premios Nobel de Química y Física reconocieron a los investigadores que utilizan la IA, incluidos Demis Hassabis y John Jumper, quienes ganaron los premios por su trabajo en el modelo AlphaFold de Google DeepMind para la predicción de la estructura de proteínas, y Geoff Hinton, profesor emérito de la Universidad de Toronto, y John Hopfield, profesor emérito de la Universidad de Princeton, fueron honrados por avanzar en las arquitecturas de redes neuronales.

El prestigioso Premio Gordon Bell de computación de alto rendimiento también fue para el equipo de David Keyes en KAUST por sus métodos de precisión mixta que emulan el enorme conjunto de datos climáticos ERA5, que proporciona estimaciones horarias de variables atmosféricas, de la superficie terrestre y de las olas oceánicas de los últimos 80 años con 137 niveles de altitud desde la superficie hasta una altura de 80 km.

La precisión mixta es una técnica que combina múltiples formatos de precisión de coma flotante. El uso de tipos de datos de menor precisión puede proporcionar un rendimiento y una eficiencia mejorados, lo que permite que las aplicaciones utilicen menos recursos y aumenten el rendimiento.

El uso de la precisión mixta en la ciencia es cada vez más común a medida que los científicos crean nuevos modelos de IA para acelerar los workflows científicos.

En el Reino Unido, el sistema Isambard-AI de la Universidad de Bristol, impulsado por NVIDIA Grace Hopper, utilizó una precisión mixta para entrenar modelos como Nightingale AI.

Nightingale AI, desarrollado bajo la dirección del profesor Aldo Faisal, es un modelo de base multimodal para el área de la salud y la investigación biomédica, que integra imágenes, cardiología y registros médicos electrónicos. A diferencia de otros grandes modelos de lenguaje del área de la salud, la IA de Nightingale no solo utiliza el razonamiento basado en texto, sino que se basa en patrones de imagen y técnicas de diagnóstico estándar para ofrecer información médica, utilizando grandes cantidades de datos de pacientes. El objetivo de Nightingale AI es servir de base para otras aplicaciones del área de la salud, como los asistentes de consultorio médico y los sistemas de triaje de telemedicina.

Utilizando una precisión mixta, Isambard-AI logró la escala masiva y la precisión precisa necesarias para entrenar LLM multimodales como Nightingale AI sin requerir un hardware excesivo para el entrenamiento o la inferencia.

Hacia la Próxima Iteración de HPC

La combinación de computación acelerada, tecnologías tensoriales avanzadas y métodos de precisión mixtos está transformando la ciencia computacional, demostrando el potencial de aún más avances habilitados por la IA.

Con sistemas como JUPITER uniéndose al TOP500, el trabajo emergente sobre el uso de la IA con fines científicos, como Isambard-AI e innovaciones como el método de emulación Ozaki que acelera el rendimiento de Tensor Core para tareas de alta precisión, está surgiendo una nueva era.

Las supercomputadoras continuarán siendo más rápidas en algunas mediciones, pero la velocidad por sí sola no es suficiente. Encontrar nuevos conocimientos sobre cuestiones científicas importantes dependerá de enfoques inteligentes y flexibles que aceleren el descubrimiento sin comprometer el rigor científico para satisfacer las necesidades de las comunidades científicas y de HPC, y del mundo.