La IA generativa está abriendo nuevas posibilidades para analizar los flujos de vídeo existentes. La analítica de vídeo está evolucionando desde contar objetos hasta convertir el contenido de vídeo en bruto en comprensión en tiempo real. Esto permite obtener información más útil.

El NVIDIA AI Blueprint para búsqueda y resumen de vídeo (VSS) reúne modelos de lenguaje visual (VLM), grandes modelos de lenguaje (LLMs) y generación aumentada por recuperación (RAG) con pipelines optimizados de ingestión, recuperación y almacenamiento. Parte do NVIDIA Metropolis, soporta tanto la comprensión de vídeo almacenado como la de vídeo en tiempo real.

En versiones anteriores, el VSS Blueprint introdujo capacidades como la ingesta eficiente de vídeo, RAG consciente del contexto, pipeline de visión por computadora (CV) y transcripción de audio. Para saber más sobre estas funciones fundamentales, consulta Agentes Avanzados de Analítica de Video Usando el Blueprint de IA de NVIDIA para Búsqueda y Resumen de Vídeo y Construye un Agente de Búsqueda y Resumen de Vídeo con el Blueprint de IA NVIDIA.

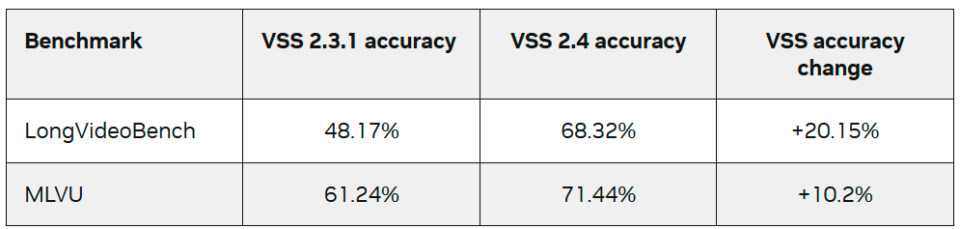

Esta publicación explica las nuevas características de la última versión de VSS Blueprint 2.4, que ofrece cuatro actualizaciones importantes que permiten a los desarrolladores:

- Mejorar la comprensión del mundo físico: VSS está ahora integrado con NVIDIA Cosmos Reason, un VLM de razonamiento de última generación que ofrece razonamiento avanzado de IA física y comprensión de escenas para análisis de vídeo más enriquecidos y conocimientos.

- Mejora de preguntas y respuestas: Las nuevas funciones de grafos de conocimiento y el soporte para cámaras cruzadas incluyen preguntas y respuestas multi-flujo, generación mejorada de grafos de conocimiento, recorrido de grafos basado en agentes, Neo4J y ArangoDB con aceleración cuGraph.

- Desbloquea la IA generativa en el edge con un revisor de eventos: revisa eventos de interés encontrados en los pipelines de CV y proporciona información contextual con IA generativa. Los nuevos endpoints permiten configurar VSS como un complemento inteligente a los pipelines de CV. Esto es ideal para despliegues de edges con baja latencia.

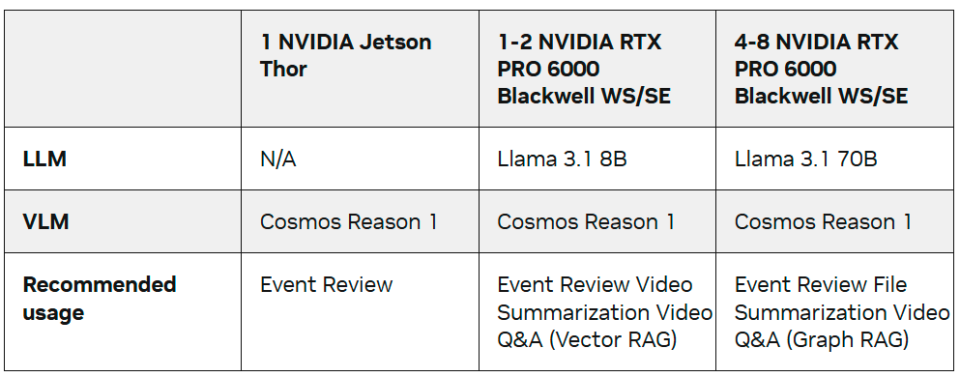

- Despliegue con soporte de hardware ampliado: VSS está ahora disponible en múltiples plataformas equipadas con NVIDIA Blackwell, incluyendo NVIDIA Jetson Thor, NVIDIA DGX Spark y las ediciones NVIDIA RTX Pro 6000 para workstations y servidores.

Mejora la Comprensión del Mundo Físico con Cosmos Reason

Cosmos Reason es un VLM de razonamiento abierto, personalizable y de 7.000 millones de parámetros y de última generación para IA física. Permite que los agentes de la IA de la visión razonen como humanos usando conocimientos previos, comprensión física y sentido común para comprender y actuar en el mundo real. Cosmos Reason permite a los desarrolladores crear agentes de IA capaces de ver, analizar y actuar en el mundo físico analizando petabytes de vídeos grabados o millones de transmisiones en directo. El Cosmos Reason NIM también está disponible ahora, ofreciendo un punto final VLM listo para producción para construir agentes inteligentes de IA visual con razonamiento rápido y escalable.

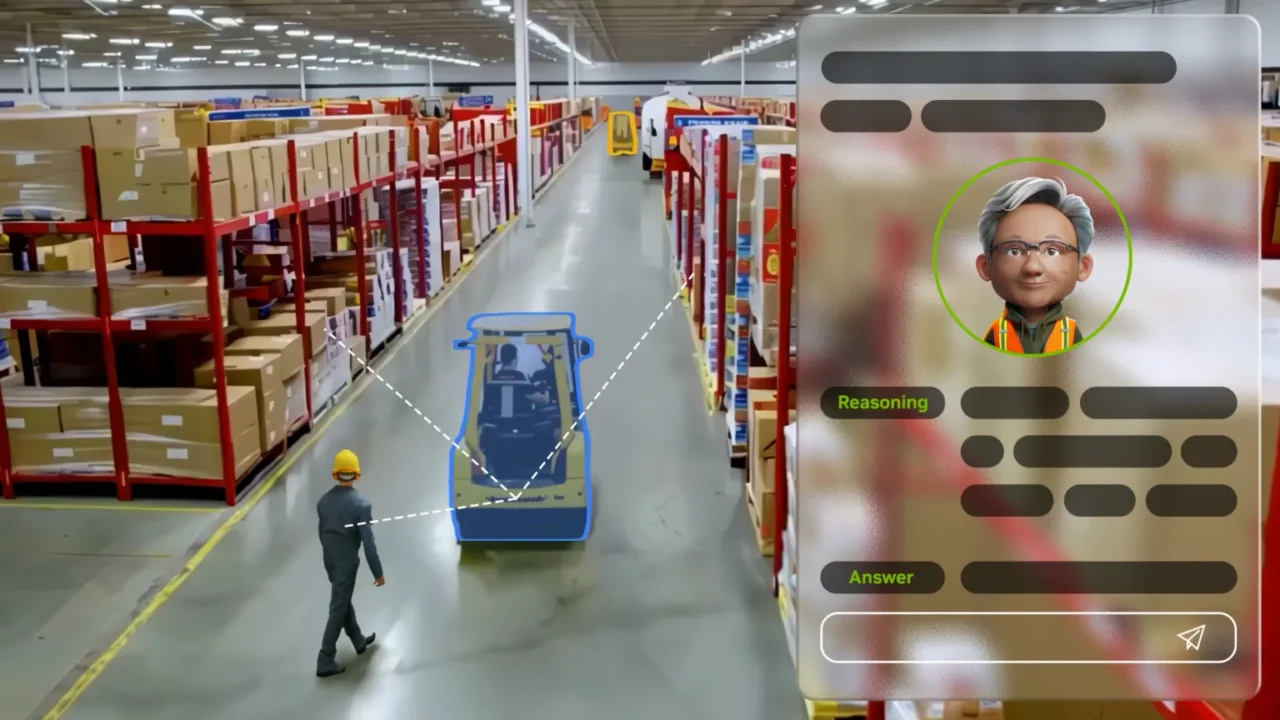

Vídeo 1. Descubre cuatro casos de uso para un agente de IA visual impulsado por un VLM de razonamiento

Los agentes de IA de análisis de vídeo construidos con el VSS Blueprint 2.4 pueden usar Cosmos Reason para extraer leyendas densas y precisas y ricas, enumerar objetos de interés con un conjunto de indicaciones de marcas, proporcionar información valiosa y realizar análisis de causas raíz en imágenes de múltiples industrias, incluyendo líneas de manufactura, almacenes logísticos, tiendas minoristas y redes de transporte.

VSS 2.4 soporta integración nativa con Cosmos Reason. Este soporte acopla estrechamente el proceso de ingestión de vídeo con el VLM para permitir un procesamiento eficiente por lotes y aceleraciones que no son posibles con interfaces VLM basadas en API REST. La pequeña huella de parámetros de 7 mil millones de parámetros de Cosmos Reason facilita su uso tanto para despliegues en el edge como en la nube. Cosmos Reason es totalmente personalizable y puede ajustarse con datos propietarios.

Mejora las Preguntas y Respuestas Con Soporte de Grafos de Conocimiento y Cámara Cruzada

Ingerir grandes cantidades de vídeo es complicado porque los datos no están estructurados, son continuos y tienen un volumen extremadamente alto, lo que dificulta buscar, indexar o resumir de forma eficiente. Un solo vídeo puede abarcar horas de metraje, incluir múltiples eventos ocurriendo a la vez y requerir un cálculo intensivo solo para decodificar y analizar. Los pipelines estándar de visión por computadora a menudo no pueden seguir el ritmo a escala, produciendo detecciones aisladas sin el contexto más amplio necesario para entender lo que realmente está ocurriendo.

VSS resuelve este problema utilizando un pipeline de ingestión de vídeo acelerada por GPU. A medida que llega un archivo de vídeo o una transmisión en directo, se divide en fragmentos más pequeños y Cosmos Reason VLM genera una descripción o pie de foto completo de cada fragmento. Un LLM extrae entonces la información necesaria de los subtítulos generados por VLM para construir un grafo de conocimiento que capture los detalles importantes del vídeo. Una vez construido el grafo de conocimiento, un gran modelo de lenguaje recorre el gráfico para responder a las preguntas de los usuarios en los vídeos.

VSS 2.4 mejora la precisión de preguntas y respuestas y la comprensión de cámara cruzada con:

- Deduplicación de entidades en el grafo de conocimiento

- Recorrido de grafos basado en agentes

- Base de datos de grafos acelerada por CUDA

En versiones anteriores del VSS Blueprint, construir el grafo de conocimiento podía dar lugar a nodos y aristas duplicados. En VSS Blueprint 2.4, se ha añadido un postprocesado de grafo de conocimiento para eliminar entradas duplicadas y fusionar nodos y aristas que son comunes entre vídeos. Esto significa que entidades comunes como el mismo coche que se mueve entre múltiples cámaras ahora se fusionan en una sola entidad, lo que mejora la capacidad de VSS para entender objetos únicos mientras se mueven a través de un vídeo y entre cámaras.

Una vez que el grafo de conocimiento ha sido generado y postprocesado, se utiliza un LLM para recorrer el gráfico y recopilar la información necesaria para responder a la pregunta del usuario sobre los vídeos.

En VSS 2.4, se ha introducido el razonamiento basado en agentes para la recuperación avanzada de grafos de conocimiento. Si está habilitado, un agente basado en LLM descomponerá inteligentemente la pregunta y luego utilizará un conjunto de herramientas para buscar en el gráfico, encontrar metadatos relevantes, reinspeccionar fotogramas muestreados del vídeo e iterar si es necesario para responder con precisión a la pregunta del usuario.

Ahora es posible responder preguntas a través de múltiples flujos de cámara utilizando el postprocesamiento de grafos de conocimiento para fusionar entidades y relaciones y la recuperación avanzada basada en agentes.

Para proporcionar a los desarrolladores las herramientas más recientes, los backends de bases de datos Graph compatibles se han ampliado para incluir ArangoDB. Ahora los usuarios pueden configurar VSS para usar el backend de bases de datos de grafos Neo4J o ArangoDB. ArangoDB aporta un conjunto de mejoras, incluyendo funciones de grafos aceleradas por CUDA para acelerar la generación de grafos de conocimiento. Para más detalles sobre la integración de ArangoDB en VSS, véase Generar un Grafo de Conocimiento en Vídeo: NVIDIA VSS Blueprint con GraphRAG en ArangoDB.

Estas nuevas características para permitir la generación de grafos de conocimiento y la sesión de preguntas y respuestas con agentes son más adecuadas para despliegues multi-GPU que pueden gestionar grandes LLMs y múltiples solicitudes VLM concurrentes.

Ampliar los Pipelines de CV con VSS Event Reviewer

Para despliegues a menor escala y en el edge, la nueva función VSS Event Reviewer introduce endpoints API que facilitan la integración de VSS en los pipelines de visión por ordenador existentes para alertas de baja latencia y sesiones directas de preguntas y respuestas VLM en segmentos de vídeo.

En lugar de ejecutar VSS de forma continua en todos los archivos o flujos, Event Reviewer permite que VSS actúe como un complemento inteligente que ofrece información VLM solo en momentos clave. Este enfoque reduce considerablemente los costes de cómputo, haciendo que VSS sea ideal para despliegues ligeros y plataformas de borde.

Aunque los pipelines estándar de CV destacan en detectar objetos y personas o en aplicar análisis para identificar eventos, como posibles colisiones de vehículos, a menudo generan falsos positivos y carecen de un conocimiento más profundo de la escena.

El VSS puede utilizarse para mejorar estes pipelines de CV analizando clips de vídeo cortos señalados por el sistema CV, revisando los eventos detectados y descubriendo información adicional que los métodos tradicionales pueden pasar por alto.

La Figura 4 muestra cómo VSS puede complementar un pipeline existente. El pipeline de visión por computadora representa cualquier sistema propietario capaz de recibir archivos de vídeo o transmisiones y emitir clips cortos de interés. Los endpoints Revisores de Eventos pueden ser llamados para que pasen estos breves clips de vídeo a VSS para generar alertas y responder preguntas de seguimiento mediante un VLM.

Para demostrar esta característica, se proporciona una cadena de detección de DeepStream de ejemplo en el repositorio de GitHub de VSS usando GroundingDINO. Este ejemplo de pipeline ingiere un vídeo, ejecuta la detección y luego genera clips cuando el número de objetos detectados supera un umbral establecido. El propósito de este pipeline es encontrar los eventos más importantes del vídeo que deben ser inspeccionados por VSS con un VLM.

VSS procesará entonces cada pequeño clip usando el VLM respondiendo a un conjunto de preguntas de sí/no definidas por el usuario. Estas respuestas se convierten en estados verdadero/falso para cada pregunta y pueden usarse para generar alertas de baja latencia para un usuario. Una vez que el clip corto haya sido procesado por VSS, puedes hacer preguntas de seguimiento más detalladas.

Este enfoque utiliza selectivamente el VLM solo en clips de interés determinados por un pipeline ligero de detección. Puede reducir significativamente el coste de cómputo al disminuir las llamadas VLM y liberar la GPU para otras cargas de trabajo.

Despliegue de Forma Flexible con Soporte de Hardware Ampliado

VSS Blueprint 2.4 soporta completamente varias plataformas NVIDIA Blackwell, incluyendo las ediciones servidor y workstation de NVIDIA RTX Pro 6000 y NVIDIA Jetson Thor para despliegues en edge. El soporte para NVIDIA DGX Spark llegará pronto.

Para una lista completa de plataformas soportadas, consulte la sección Plataformas Soportadas de la documentación de VSS.

Empieza con la IA Visual Basada en Agentes

La nueva versión de VSS Blueprint 2.4 aporta nuevas capacidades de IA visual basada en agentes al edge, mejoras para mejorar la precisión de preguntas y respuestas, comprensión de cámaras cruzadas y expansión del soporte de plataformas. Las mejoras en la creación y desplazamiento de grafos de conocimiento mejoran la precisión de las preguntas y respuestas y permiten consultas cruzadas de cámara.

Para despliegues en edge y casos de uso de alertas, la función Event Reviewer es una forma de usar VSS como un complemento inteligente a los pipelines de CV para alertas de baja latencia. Soporte ampliado para plataformas, incluyendo NVIDIA RTX Pro y NVIDIA Thor.

Para empezar rápidamente con el VSS Blueprint, usa un NVIDIA Brev Launchable. El launchable ofrece un despliegue rápido con un solo clic y notebooks Jupyter para explicar cómo lanzar VSS, acceder a la interfaz web y usar las APIs REST de VSS. Visita el repositorio NVIDIA-AI-Blueprints/video-search-and-summarization de GitHub para más recursos técnicos como cuadernos de entrenamiento y código de referencia. Para preguntas más técnicas, visita el Foro de Desarrolladores NVIDIA.

Para detalles sobre despliegues en producción y CSPs, consulta la sección Cloud de la documentación de VSS.