Las empresas que buscan aprovechar el poder de la IA necesitan modelos personalizados adaptados a las necesidades específicas de su industria.

NVIDIA AI Foundry es un servicio que permite a las empresas utilizar datos, computación acelerada y herramientas de software para crear e implementar modelos personalizados que pueden potenciar sus iniciativas de IA generativa.

Al igual que TSMC fabrica chips diseñados por otras empresas, NVIDIA AI Foundry proporciona la infraestructura y las herramientas para que otras empresas desarrollen y personalicen modelos de IA, utilizando DGX Cloud, modelos de base, software NVIDIA NeMo, experiencia de NVIDIA, así como herramientas y soporte del ecosistema.

La diferencia clave es el producto: TSMC produce chips semiconductores físicos, mientras que NVIDIA AI Foundry ayuda a crear modelos personalizados. Ambos permiten la innovación y se conectan a un vasto ecosistema de herramientas y socios.

Las empresas pueden usar NVIDIA AI Foundry para personalizar modelos de comunidad abierta, incluida la nueva colección Llama 3.1, así como NVIDIA Nemotron, CodeGemma de Google DeepMind, CodeLlama, Gemma de Google DeepMind, Mistral, Mixtral, Phi-3, StarCoder2 y otros.

Los Pioneros de la Industria Impulsan la Innovación en IA

Los líderes del sector Amdocs, Capital One, Getty Images, KT, Hyundai Motor Company, SAP, ServiceNow y Snowflake se encuentran entre los primeros en utilizar NVIDIA AI Foundry. Estos pioneros están preparando el escenario para una nueva era de innovación impulsada por la IA en software, tecnología, comunicaciones y medios empresariales.

«Las organizaciones que implementan IA pueden obtener una ventaja competitiva con modelos personalizados que incorporan conocimiento de la industria y el negocio», dijo Jeremy Barnes, vicepresidente de productos de IA en ServiceNow. «ServiceNow utiliza NVIDIA AI Foundry para ajustar e implementar modelos que puedan integrarse fácilmente en los workflows existentes de los clientes».

Los Pilares de NVIDIA AI Foundry

NVIDIA AI Foundry está respaldado por los pilares clave de los modelos básicos, el software empresarial, la computación acelerada, el soporte de expertos y un amplio ecosistema de socios.

Su software incluye modelos básicos de IA de NVIDIA y la comunidad de IA, así como la plataforma completa de software NVIDIA NeMo para acelerar el desarrollo de modelos.

El músculo de computación de NVIDIA AI Foundry es NVIDIA DGX Cloud, una red de recursos acelerados de computación diseñados conjuntamente con las principales nubes públicas del mundo: Amazon Web Services, Google Cloud y Oracle Cloud Infrastructure. Con DGX Cloud, los clientes de AI Foundry pueden desarrollar y ajustar aplicaciones personalizadas de IA generativa con una facilidad y eficiencia sin precedentes, y escalar sus iniciativas de IA según sea necesario sin importantes inversiones iniciales en hardware. Esta flexibilidad es crucial para las empresas que buscan mantenerse ágiles en un mercado que cambia rápidamente.

Si un cliente de NVIDIA AI Foundry necesita ayuda, los expertos de NVIDIA AI Enterprise están disponibles para ayudarlo. Los expertos de NVIDIA pueden guiar a los clientes a través de cada uno de los pasos necesarios para construir, ajustar e implementar sus modelos con datos patentados, asegurando que los modelos se alineen estrechamente con los requisitos de su negocio.

Los clientes de NVIDIA AI Foundry tienen acceso a un ecosistema global de socios que pueden proporcionar una gama completa de soporte. Accenture, Deloitte, Infosys, Tata Consultancy Services y Wipro se encuentran entre los socios de NVIDIA que ofrecen servicios de consultoría de AI Foundry que abarcan el diseño, la implementación y la gestión de proyectos de transformación digital impulsados por IA. Accenture es el primero en ofrecer su propia oferta basada en AI Foundry para el desarrollo de modelos personalizados, el framework Accenture AI Refinery.

Además, los socios de prestación de servicios como Data Monsters, Quantiphi, Slalom y SoftServe ayudan a las empresas a navegar por las complejidades de la integración de la IA en sus entornos de TI existentes, garantizando que las aplicaciones de IA sean escalables, seguras y estén alineadas con los objetivos empresariales.

Los clientes pueden desarrollar modelos de NVIDIA AI Foundry para producción utilizando plataformas AIOps y MLOps de los socios de NVIDIA, incluidos ActiveFence, AutoAlign, Cleanlab, DataDog, Dataiku, Dataloop, DataRobot, Deepchecks, Domino Data Lab, Fiddler AI, Giskard, New Relic, Scale, Tumeryk y Weights & Biases.

Los clientes pueden generar sus modelos de AI Foundry como microservicios de inferencia NVIDIA NIM, que incluyen el modelo personalizado, motores optimizados y una API estándar, para que se ejecuten en su infraestructura acelerada preferida.

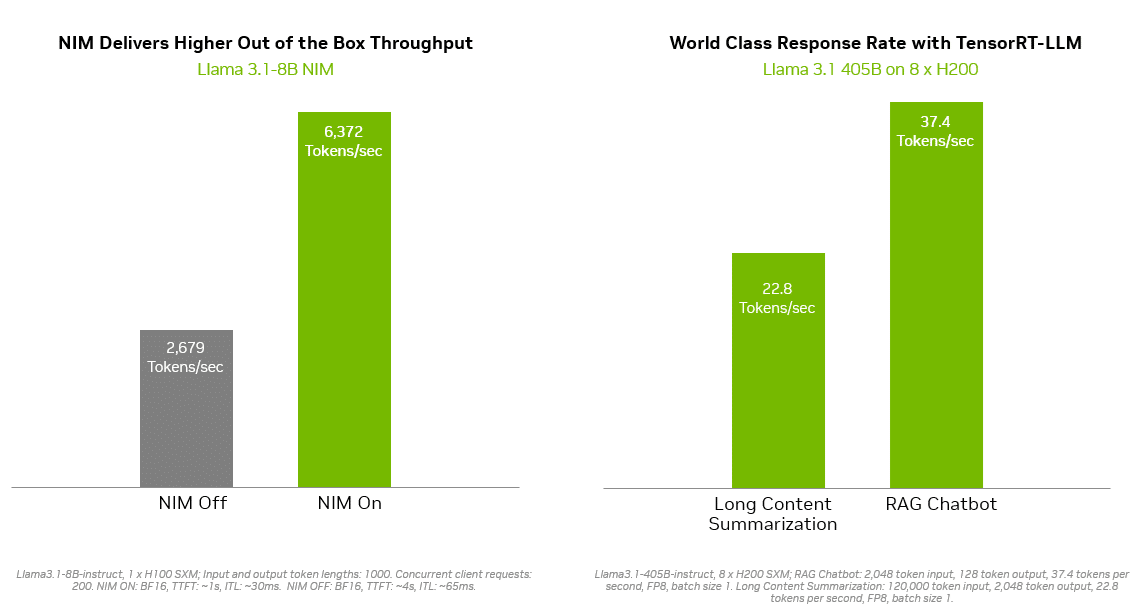

Las soluciones de inferencia como NVIDIA TensorRT-LLM ofrecen una eficiencia mejorada para los modelos Llama 3.1 con el fin de minimizar la latencia y maximizar el rendimiento. Esto permite a las empresas generar tokens más rápido al tiempo que reduce el costo total de ejecutar los modelos en producción. El paquete de software NVIDIA AI Enterprise proporciona soporte y seguridad de nivel empresarial.

La amplia gama de opciones de implementación incluye Sistemas Certificados por NVIDIA de socios globales de manufactura de servidores, incluidos Cisco, Dell Technologies, Hewlett Packard Enterprise, Lenovo y Supermicro, así como instancias en la nube de Amazon Web Services, Google Cloud y Oracle Cloud Infrastructure.

Además, Together AI, una nube líder en aceleración de IA, anunció hoy que permitirá a su ecosistema de más de 100,000 desarrolladores y empresas usar su pila de inferencia acelerada por GPU de NVIDIA para implementar endpoints Llama 3.1 y otros modelos abiertos en DGX Cloud.

«Todas las empresas que ejecutan aplicaciones de IA generativa quieren una experiencia de usuario más rápida, con mayor eficiencia y menor costo», dijo Vipul Ved Prakash, fundador y CEO de Together AI. «Ahora, los desarrolladores y las empresas que utilizan el motor de inferencia Together pueden maximizar el rendimiento, la escalabilidad y la seguridad en NVIDIA DGX Cloud».

NVIDIA NeMo Acelera y Simplifica el Desarrollo de Modelos Personalizados

Con NVIDIA NeMo integrado en AI Foundry, los desarrolladores tienen al alcance de la mano las herramientas necesarias para seleccionar datos, personalizar modelos de base y evaluar el rendimiento. Las tecnologías NeMo incluyen:

- NeMo Curator es una biblioteca de curación de datos acelerada por GPU que mejora el rendimiento de los modelos de IA generativa mediante la preparación de conjuntos de datos a gran escala y de alta calidad para el preentrenamiento y el ajuste.

- NeMo Customizer es un microservicio escalable y de alto rendimiento que simplifica el ajuste y la alineación de los LLM para casos de uso específicos del dominio.

- NeMo Evaluator proporciona una evaluación automática de modelos de IA generativa a través de puntos de referencia académicos y personalizados en cualquier nube o data center acelerado.

- NeMo Guardrails orquesta la gestión de diálogos, respaldando la precisión, la idoneidad y la seguridad en aplicaciones inteligentes con grandes modelos de lenguaje para proporcionar salvaguardas para aplicaciones de IA generativa.

Con la plataforma NeMo de NVIDIA AI Foundry, las empresas pueden crear modelos de IA personalizados que se adapten con precisión a sus necesidades. Esta personalización permite una mejor alineación con los objetivos estratégicos, una mayor precisión en la toma de decisiones y una mayor eficiencia operativa. Por ejemplo, las empresas pueden desarrollar modelos que entiendan la jerga específica de la industria, cumplan con los requisitos regulatorios y se integren sin problemas con los workflows existentes.

«Como siguiente paso de nuestra asociación, SAP planea utilizar la plataforma NeMo de NVIDIA para ayudar a las empresas a acelerar la productividad impulsada por la IA impulsada por SAP Business AI», dijo Philipp Herzig, director de IA de SAP.

Las empresas pueden implementar sus modelos de IA personalizados en producción con los microservicios de inferencia NVIDIA NeMo Retriever NIM. Estos ayudan a los desarrolladores a obtener datos patentados para generar respuestas informadas para sus aplicaciones de IA con generación aumentada de recuperación (RAG).

«La IA segura y confiable no es negociable para las empresas que aprovechan la IA generativa, ya que la precisión de la recuperación afecta directamente la relevancia y la calidad de las respuestas generadas en los sistemas RAG», dijo Baris Gultekin, jefe de IA de Snowflake. «Snowflake Cortex AI aprovecha NeMo Retriever, un componente de NVIDIA AI Foundry, para proporcionar a las empresas respuestas fáciles, eficientes y confiables utilizando sus datos personalizados».

Los Modelos Personalizados Impulsan la Ventaja Competitiva

Una de las principales ventajas de NVIDIA AI Foundry es su capacidad para abordar los desafíos únicos a los que se enfrentan las empresas a la hora de adoptar la IA. Los modelos genéricos de IA pueden no satisfacer las necesidades empresariales específicas y los requisitos de seguridad de los datos. Los modelos de IA personalizados, por otro lado, ofrecen flexibilidad, adaptabilidad y rendimiento superiores, lo que los hace ideales para las empresas que buscan obtener una ventaja competitiva.

Obtén más información sobre cómo NVIDIA AI Foundry permite a las empresas aumentar la productividad y la innovación.