Gracias a los auriculares puedes participar de llamadas en cualquier lugar mientras haces otra cosa. El problema: la gente con la que tienes la llamada oye todo, desde la aspiradora de tu compañera de cuarto hasta las conversaciones de fondo en el café desde el que estás trabajando.

Ahora, el trabajo de un trío de estudiantes graduados de la Universidad de Washington que pasaron la pandemia encerrados en un departamento ruidoso les permite a aquellos con quienes hablas escucharte solo a ti, en lugar de todas las cosas que pasan a tu alrededor.

Los usuarios descubrieron que el sistema, apodado «ClearBuds», que se presentó el mes pasado en la Conferencia Internacional de ACM sobre Sistemas Móviles, Aplicaciones y Servicios, mejoró la supresión de ruido de fondo mucho mejor que una alternativa disponible comercialmente.

«Puedes eliminar el sonido de fondo de la misma manera que puedes eliminar el fondo de tu imagen en una videollamada», explicó Vivek Jayaram, estudiante de doctorado en la Facultad de Ciencias de la Computación e Ingeniería Paul G. Allen.

Los ClearBuds son diferentes a otros auriculares inalámbricos en dos grandes aspectos. Estos dispositivos se describen en un documento escrito en conjunto por los tres compañeros de cuarto, todos estudiantes graduados en Ciencias de la Computación e Ingeniería de la Universidad de Washington (Maruchi Kim, Ishan Chatterjee y Jayaram).

En primer lugar, los ClearBuds usan dos micrófonos por auricular.

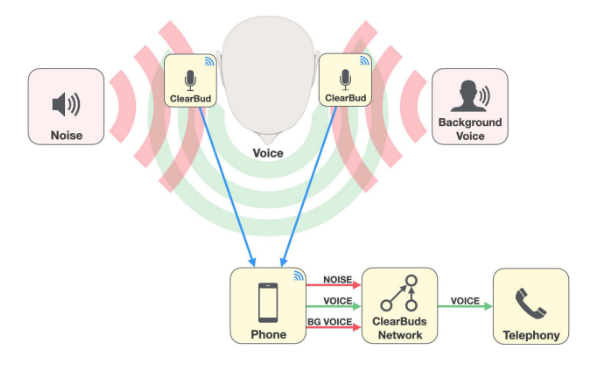

Si bien la mayoría de los auriculares usan los dos micrófonos de un solo auricular, ClearBuds utiliza un micrófono de cada auricular para crear dos señales de entrada de audio.

Esto crea una resolución espacial más alta para que el sistema separe mejor los sonidos que provienen de diferentes direcciones, explicó Kim. En otras palabras, ayuda al sistema a seleccionar la voz del usuario que usa el auricular.

En segundo lugar, el equipo creó un algoritmo de red neuronal que puede ejecutarse en un teléfono móvil para procesar las transmisiones de audio e identificar qué sonidos deben mejorarse y cuáles deben eliminarse.

Los investigadores se basaron en dos redes neuronales separadas para hacer esto.

La primera red neuronal suprime todo lo que no es una voz humana.

La segunda mejora la voz del altavoz. El altavoz se puede identificar porque proviene de micrófonos de ambos auriculares al mismo tiempo.

Juntos, enmascaran eficazmente el ruido de fondo y garantizan que el usuario se escuche fuerte y claro.

Si bien el software que crearon los investigadores era lo suficientemente ligero como para ejecutarse en un dispositivo móvil, usaron una GPU de escritorio NVIDIA TITAN para entrenar las redes neuronales. Usaron tanto muestras de audio sintético como audio real. El entrenamiento tomó menos de un día.

Y los resultados, según informaron los usuarios, fueron considerablemente mejores que lo que ofrecen los auriculares disponibles comercialmente; dichos resultados se están ganando el reconocimiento de toda la industria.

El equipo se llevó el segundo lugar a la mejor investigación en la conferencia ACM MobSys 2022 del mes pasado. Además de Kim, Chatterjee y Jayarm, los coautores del documento incluyeron a Ira Kemelmacher-Shliz, un profesor adjunto de la Escuela Allen;Shwetak Patel, un profesor tanto de la Escuela Allen como en el departamento de Ingeniería Eléctrica y Computación; y Shyam Gollakota y Steven Seitz, ambos profesores en la Escuela Allen.

Lee el documento completo aquí: https://dl.acm.org/doi/10.1145/3498361.3538933

Por si acaso, el sistema descrito en el documento no se puede adoptar al instante. Si bien muchos auriculares tienen dos micrófonos por auricular, solo captan audio desde un auricular. Las normas de la industria solo están al día con la idea de procesar múltiples grabaciones de audio desde auriculares.

Sin embargo, los investigadores esperan que su trabajo, que es de código abierto, inspire a otras personas a acoplar redes neuronales y micrófonos para proporcionar llamadas de audio de mejor calidad.

Estas ideas también se podrían aprovechar para aislar y mejorar las conversaciones que se realizan a través altavoces inteligentes usando conjuntos de micrófonos ad hoc, dijo Kim, e incluso rastreando ubicaciones de robots o misiones de búsqueda y rescate.

A nosotros nos suena bien.

Créditos de la imagen: Raymond Smith, Universidad de Washington