Millones de personas de todo el mundo utilizan chatbots cada día, impulsados por servidores en la nube basados en GPU NVIDIA. Ahora, estas revolucionarias herramientas llegan a las PCs Windows equipados con NVIDIA RTX para proporcionar IA generativa local, rápida y personalizada.

Chat with RTX, que ya puede descargarse gratuitamente, es una demostración técnica que permite a los usuarios personalizar un chatbot con su propio contenido, acelerado por una GPU NVIDIA GeForce RTX Serie 30 o superior con al menos 8 GB de memoria de acceso aleatorio a video, o VRAM.

Pregúntame cualquier cosa

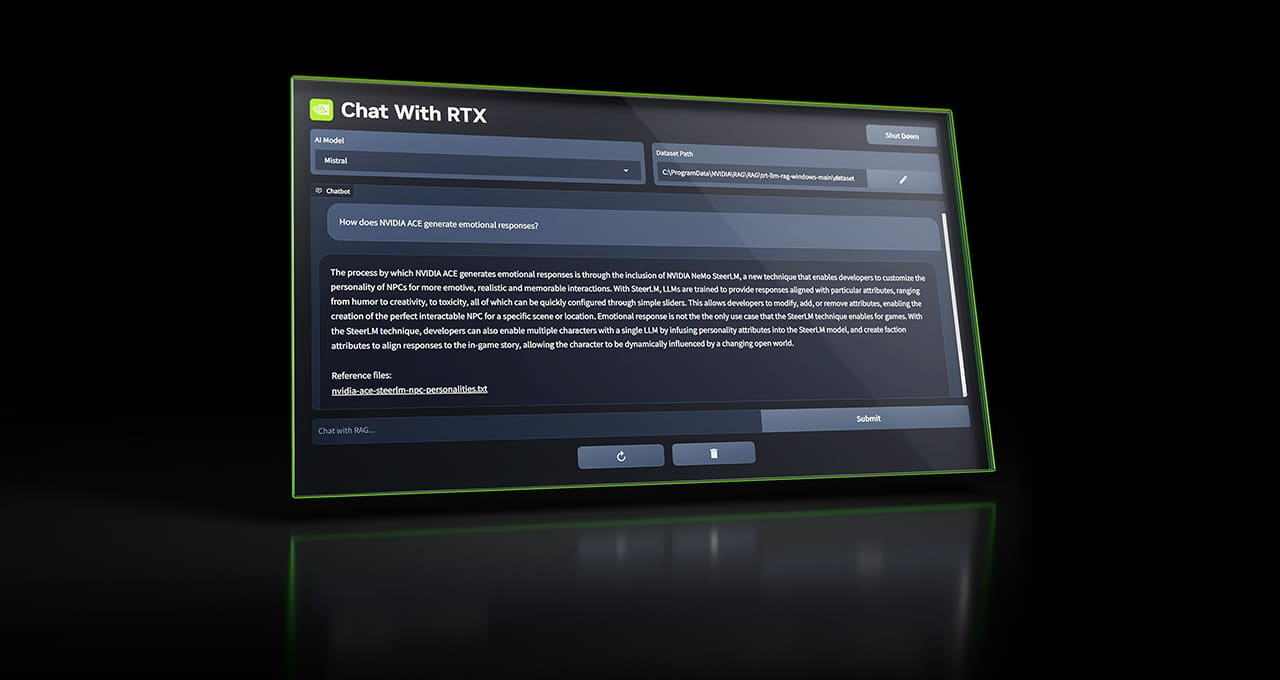

Chat con RTX utiliza la generación aumentada por recuperación (RAG), el software NVIDIA TensorRT-LLM y la aceleración NVIDIA RTX para llevar la inteligencia artificial generativa a las PCs Windows con GeForce. Los usuarios pueden conectar de forma rápida y sencilla los archivos locales de una PC como conjunto de datos a un modelo de lenguaje de gran tamaño y código abierto como Mistral o Llama 2, lo que permite realizar consultas para obtener respuestas rápidas y contextualmente relevantes.

En lugar de buscar en notas o contenidos guardados, los usuarios pueden simplemente escribir consultas. Por ejemplo, uno podría preguntar: «¿Cuál fue el restaurante que me recomendó mi pareja cuando estaba en Las Vegas?» y Chat con RTX escaneará los archivos locales que el usuario le señale y ofrecerá la respuesta con contexto.

La herramienta admite varios formatos de archivo, como .txt, .pdf, .doc/.docx y .xml. Dirije la aplicación a la carpeta que contiene estos archivos y la herramienta los cargará en tu biblioteca en cuestión de segundos.

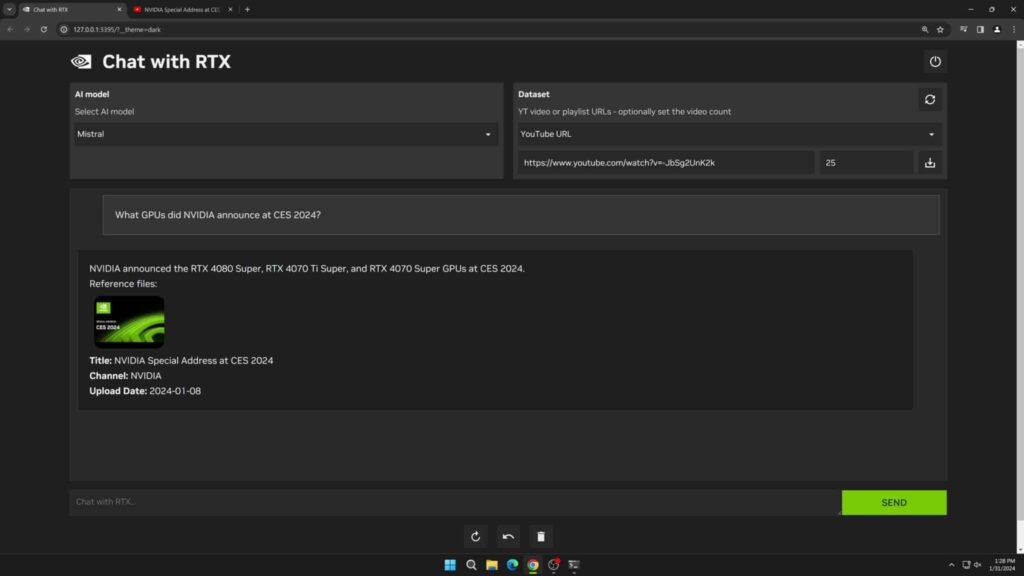

Los usuarios también pueden incluir información de vídeos y listas de reproducción de YouTube. Añadir una URL de vídeo a Chat con RTX permite a los usuarios integrar este conocimiento en su chatbot para realizar consultas contextuales. Por ejemplo, pedir recomendaciones de viajes basadas en el contenido de los videos favoritos de personas influyentes, u obtener tutoriales rápidos y procedimientos basados en los principales recursos educativos.

Dado que Chat with RTX se ejecuta localmente en PCs y estaciones de trabajo Windows RTX, los resultados proporcionados son rápidos, y los datos del usuario permanecen en el dispositivo. En lugar de depender de servicios LLM basados en la nube, Chat with RTX permite a los usuarios procesar datos confidenciales en una PC local sin necesidad de compartirlos con terceros ni de disponer de conexión a Internet.

Además de una GPU GeForce RTX Serie 30 o superior con un mínimo de 8 GB de VRAM, Chat con RTX requiere Windows 10 u 11, y los últimos drivers de GPU NVIDIA.

Nota del editor: Hemos identificado un problema en Chat con RTX que hace que la instalación falle cuando el usuario selecciona un directorio de instalación diferente. Esto se solucionará en una futura versión. Por el momento, los usuarios deben utilizar el directorio de instalación predeterminado («C:\Users\<nombredeusuario>\AppData\Local\NVIDIA\ChatWithRTX»).

Desarrolla aplicaciones basadas en LLM con RTX

Chat with RTX muestra el potencial de aceleración de los LLM con las GPUs RTX. La aplicación se ha creado a partir del proyecto de referencia para desarrolladores TensorRT-LLM RAG, disponible en GitHub. Los desarrolladores pueden utilizar el proyecto de referencia para desarrollar e implantar sus propias aplicaciones basadas en RAG para RTX, aceleradas por TensorRT-LLM. Más información sobre la creación de aplicaciones basadas en LLM.

Participe con una aplicación o un plug-in Windows basado en IA generativa en el concurso para desarrolladores NVIDIA Generative AI on NVIDIA RTX, abierto hasta el viernes 23 de febrero, para optar a premios como una GPU GeForce RTX 4090, un pase completo y presencial a la conferencia NVIDIA GTC y mucho más.

Más información sobre Chat con RTX.

Explore las sesiones y experiencias sobre IA generativa en NVIDIA GTC, la conferencia mundial sobre IA y computación acelerada que se celebra del 18 al 21 de marzo en San José, California, y en línea.