Ming-Yu Liu y Arun Mallya estaban en una videollamada cuando la transmisión de uno de ellos comenzó a cortarse y, luego, se congeló.

Es una molesta realidad de la vida en la pandemia que la mayoría de nosotros hemos compartido. Pero a diferencia de la mayoría de nosotros, Liu y Mallya podían hacer algo al respecto.

Son investigadores de IA en NVIDIA y especialistas en visión de computación. Junto a su colega Ting-Chun Wang, se dieron cuenta de que podían usar una red neuronal en lugar del software llamado códec de video, que normalmente se usa para comprimir y descomprimir video para su transmisión a través de la red.

Hasta ahora, su trabajo permite una videollamada con una sexta parte del ancho de banda de red que los usuarios suelen necesitar. Promete reducir el consumo de ancho de banda en órdenes de magnitud.

“Queremos brindar una mejor experiencia para las comunicaciones de video con IA para que incluso las personas que solo tienen acceso a un ancho de banda extremadamente bajo puedan pasar de llamadas de voz a videollamadas”, dijo Mallya.

Mejores Conexiones Gracias a las GAN

La técnica funciona incluso cuando las personas que llaman llevan un sombrero, gafas, auriculares o una máscara. Y solo por diversión, condimentaron su demostración con un par de campanas y silbidos para que los usuarios puedan cambiar digitalmente su peinado o ropa o crear un avatar.

Una característica más seria en proceso utiliza la red neuronal para ajustar la posición de la cabeza de la persona que llama y así lograr un mejor contacto visual. Elimina el problema común de las personas que llaman y parecen estar mirando fuera de la pantalla o necesitan mirar una cámara sobre su monitor para parecer que lo están mirando directamente.

“Con las técnicas de visión de computación, podemos ubicar la cabeza de una persona en una amplia gama de ángulos y creemos que esto ayudará a las personas a establecer un mejor contacto visual”, dijo Wang.

Saluda a la última forma en que la IA está haciendo que la vida virtual sea más real.

Cómo Funcionan las Videollamadas Asistidas por IA

El mecanismo detrás de las videollamadas asistidas por IA es simple.

Un remitente primero transmite una imagen de referencia de la persona que llama, al igual que los sistemas actuales que normalmente utilizan un flujo de video comprimido. Luego, en lugar de enviar una gran cantidad de imágenes llenas de píxeles, envía datos sobre la ubicación de algunos puntos clave alrededor de los ojos, la nariz y la boca del usuario.

Una red generativa antagónica en el lado del receptor utiliza la imagen inicial y los puntos clave faciales para reconstruir imágenes posteriores en una GPU local. Como resultado, se envían muchos menos datos a través de la red.

El trabajo de Liu en GAN se destacó el año pasado con GauGAN, una herramienta de inteligencia artificial que convierte los garabatos de cualquier persona en obras de arte fotorrealistas. La herramienta GauGAN ya se ha utilizado para crear más de un millón de imágenes y está disponible en AI Playground.

“La pandemia nos motivó porque ahora todos están haciendo videoconferencias. Por lo tanto, exploramos las formas de aliviar los cuellos de botella del ancho de banda para que los proveedores puedan atender a más personas al mismo tiempo”, dijo Liu.

Las GPU Eliminan los Cuellos de Botella del Ancho de Banda

El enfoque es parte de una tendencia de la industria de convertir los cuellos de botella de la red en tareas computacionales que se pueden abordar más fácilmente con recursos locales o en el cloud.

“En estos días, muchas empresas quieren convertir los problemas de ancho de banda en problemas de computación, porque a menudo es difícil agregar más ancho de banda y es más fácil agregar más computación”, dijo Andrew Page, director de productos avanzados del grupo de medios de NVIDIA.

La IA Mejora los Servicios de Video

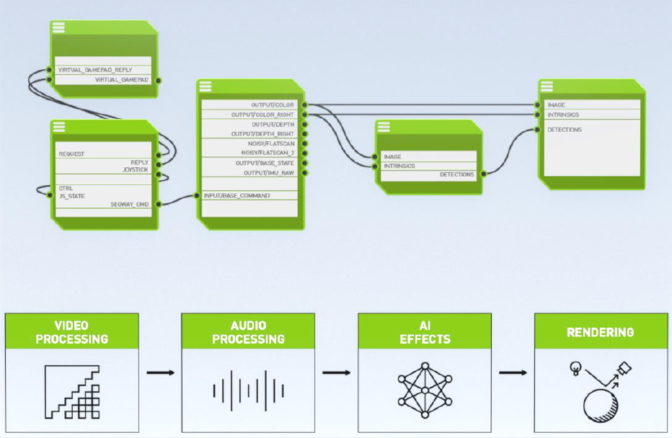

La compresión de video GAN es una de las varias capacidades que vienen a NVIDIA Maxine, una plataforma de transmisión de video con IA en el cloud para mejorar las videoconferencias y las llamadas. Incluye funciones de IA de audio, video y conversación en un solo juego de herramientas que admite una amplia gama de dispositivos.

Maxine, que se anunció en GTC de Octubre, permite a los proveedores de servicios entregar video a súper resolución con traducción en tiempo real, eliminación de ruido de fondo y subtítulos cerrados sensibles al contexto. Los usuarios pueden disfrutar de funciones como alineación de rostros, soporte para asistentes virtuales y animación realista de avatares.

“La videoconferencia está experimentando un renacimiento”, dijo Page. “Durante la pandemia, todos hemos experimentado cambios. Sin embargo, el video está aquí para quedarse ahora como parte de nuestras vidas en el futuro porque somos criaturas visuales”.

Maxine aprovecha la potencia de las GPU NVIDIA con Tensor Cores que ejecuta software como NVIDIA Jarvis, un SDK para IA conversacional que ofrece un conjunto de capacidades de voz y texto. Juntos, brindan capacidades de inteligencia artificial que son útiles hoy y sirven como bloques de construcción para los productos y servicios de video del mañana.

Obtenga más información sobre la Investigación de NVIDIA. Y mire al CEO de NVIDIA, Jensen Huang, recapitular todas las noticias en GTC en el video a continuación.

Habilite los subtítulos en español: «Setting» > «Configuration» > Auto-translate»