La creación de objetos 3D para crear escenas de juegos, mundos virtuales como el metaverso, el diseño de productos o los efectos visuales es tradicionalmente un proceso meticuloso, donde los artistas calificados equilibran detalles y fotorrealismo con plazos y presupuestos ajustados.

Se necesita mucho tiempo para hacer algo que se vea y actúe como lo haría en el mundo físico. El problema es cada vez más difícil cuando varios objetos y personajes necesitan interactuar en un mundo virtual. Simular la física es tan importante como simular la luz. Un robot en una fábrica virtual, por ejemplo, debe tener no solo el mismo aspecto, sino también la misma capacidad de peso y frenado que su contraparte física.

Es difícil. Pero las oportunidades son enormes y afectan a industrias de billones de dólares tan variadas como el transporte, la salud, las telecomunicaciones y el entretenimiento, además del diseño de productos. En definitiva, se creará más contenido en el mundo virtual que en el físico.

Para simplificar y acortar este proceso, NVIDIA presentó hoy una nueva investigación y un amplio conjunto de herramientas que aplican el poder de los gráficos neuronales a la creación y animación de objetos y mundos 3D.

Estos SDK, incluidos NeuralVDB, una actualización innovadora del estándar de la industria OpenVDB, y Kaolin Wisp, una biblioteca de Pytorch que establece un framework para la investigación de campos neuronales, facilitan el proceso creativo para los diseñadores al tiempo que facilitan a millones de usuarios que no son profesionales del diseño la creación de contenido 3D.

Los gráficos neuronales son un nuevo campo que entrelaza la IA y los gráficos para crear un proceso de gráficos acelerados que aprende a partir de los datos. La integración de la IA mejora los resultados, ayuda a automatizar las elecciones de diseño y proporciona oportunidades nuevas e inimaginables para artistas y creadores. Los gráficos neuronales redefinen la forma en que los usuarios crean, simulan y experimentan mundos virtuales.

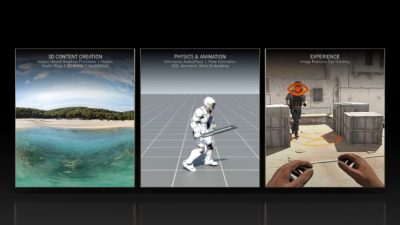

Estos SDK y la investigación contribuyen a cada etapa del pipeline de creación de contenido, lo que incluye:

Creación de Contenido 3D

- Kaolin Wisp, una incorporación a Kaolin, es una biblioteca de PyTorch que permite una investigación de deep learning 3D más rápida, ya que reduce el tiempo necesario para probar e implementar nuevas técnicas de semanas a días. Kaolin Wisp es una biblioteca orientada a la investigación para campos neuronales, que establece un conjunto común de herramientas y un framework para acelerar nuevas investigaciones en campos neuronales.

- Primitivas de gráficos neuronales instantáneos es un nuevo enfoque para capturar la forma de los objetos del mundo real y la inspiración detrás de NVIDIA Instant NeRF, un modelo de renderizado inverso que convierte una colección de imágenes fijas en una escena 3D digital. Esta técnica y el código de GitHub asociado aceleran el proceso hasta 1000 veces.

- 3D MoMa es un nuevo proceso de renderización inverso que permite a los usuarios importar rápidamente un objeto 2D a un motor de gráficos para crear un objeto 3D que se puede modificar con materiales, iluminación y física realistas.

- GauGAN360 es la próxima evolución de NVIDIA GauGAN, un modelo de IA que convierte garabatos burdos en obras maestras fotorrealistas. GauGAN360 genera panoramas 8K de 360 grados que se pueden convertir en escenas de Omniverse.

- Omniverse Avatar Cloud Engine (ACE) es una nueva colección de API, microservicios y herramientas de cloud para crear, personalizar e implementar aplicaciones humanas digitales. ACE se basa en NVIDIA Unified Compute Framework, lo que permite a los desarrolladores integrar a la perfección las tecnologías básicas de IA de NVIDIA en sus aplicaciones de avatar.

Física y Animación

- NeuralVDB es una mejora innovadora en OpenVDB, el estándar actual de la industria para el almacenamiento de datos volumétricos. Mediante el machine learning, NeuralVDB introduce representaciones neuronales compactas, lo que reduce enormemente la huella de la memoria para permitir datos 3D de mayor resolución.

- Omniverse Audio2Face es una tecnología de IA que genera expresivas animaciones faciales a partir de una sola fuente de audio. Se puede utilizar para aplicaciones interactivas en tiempo real o como una herramienta de creación de animación facial tradicional.

- ASE (Animation Skills Embedding) es un enfoque que permite a los personajes físicamente simulados actuar de una manera más receptiva y realista en situaciones desconocidas. Usa deep learning para enseñar a los personajes a responder a nuevas tareas y acciones.

- TAO Toolkit es un framework para permitir a los usuarios crear un modelo de estimación de posturas preciso y de alto rendimiento, que puede evaluar lo que una persona podría estar haciendo en una escena utilizando la visión de computación mucho más rápida que los métodos actuales.

Experiencia

- Image Features Eye Tracking es un modelo de investigación que vincula la calidad de la renderización de píxeles con el tiempo de reacción del usuario. Al predecir la mejor combinación de calidad de renderización, propiedades de pantalla y condiciones de visualización para la menor latencia, permitirá un mejor rendimiento en aplicaciones de gráficos por computación rápidas e interactivas, como los juegos competitivos.

- Los Anteojos Holográficos para la Realidad Virtual es una colaboración con la Universidad de Stanford para crear un nuevo diseño de anteojos de realidad virtual que ofrece imágenes holográficas en 3D a todo color en una innovadora pila óptica de 2.5 mm de espesor.

Únete a NVIDIA en SIGGRAPH para conocer más sobre las últimas investigaciones y avances tecnológicos en gráficos, IA y mundos virtuales. Conoce las últimas innovaciones de NVIDIA Research y accede al conjunto completo de SDK, herramientas y bibliotecas de NVIDIA.