Una nueva investigación de la Universidad de Washington está refinando los modelos meteorológicos de IA utilizando el deep learning para obtener predicciones más precisas y pronósticos a largo plazo. El estudio, publicado en Geophysical Research Letters, muestra cómo el ajuste de los datos atmosféricos iniciales permite a los modelos avanzados de IA ampliar los límites de pronóstico actuales. A medida que el clima extremo se vuelve cada vez más severo y frecuente debido al cambio climático, dar a los gobiernos, las empresas, el público y los servicios de emergencia más tiempo para prepararse para desastres naturales como inundaciones, olas de calor o huracanes podría ayudar a reducir la pérdida de vidas y propiedades.

«Si a un modelo meteorológico perfecto se le dan condiciones iniciales ligeramente imperfectas, el error se agrava con el tiempo y resulta en un pronóstico inexacto», dijo el autor principal, Trent Vonich, candidato a doctorado en la Universidad de Washington. «Esto es especialmente cierto cuando se modela un sistema caótico como la atmósfera de la Tierra. Recientemente ha habido un gran enfoque en hacer mejores modelos, mientras que se ignora un poco el hecho de que un modelo perfecto es solo la mitad del problema. Los modelos de machine learning nos ayudan a abordar esto porque son totalmente diferenciables de extremo a extremo, lo que nos permite capturar interacciones no lineales entre entradas y salidas, algo que las técnicas heredadas no pueden hacer».

Si bien los sistemas de pronóstico del tiempo de IA de última generación, como GraphCast de Google y Pangu-Weather de Huawei, predicen de manera confiable el próximo clima con hasta 10 días de anticipación, están limitados por la precisión de los datos iniciales ingresados a su sistema.

Estos modelos se entrenaron con el conjunto de datos de reanálisis masivo ERA5 que contenía petabytes de información. El conjunto de datos captura la temperatura por hora, la velocidad del viento, la humedad, la presión atmosférica, la precipitación y la nubosidad en una cuadrícula global de 37 niveles de presión. Incluye condiciones meteorológicas históricas, que se remontan a 1979, y datos casi en tiempo real.

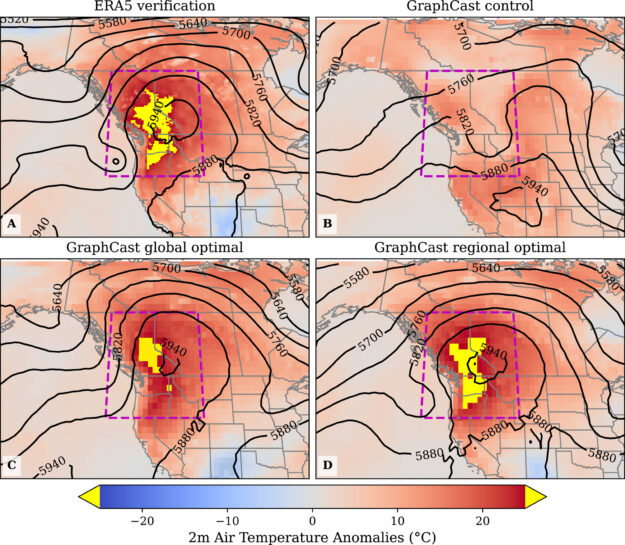

Los investigadores se centraron en refinar las variables atmosféricas iniciales que condujeron a la ola de calor del noroeste del Pacífico de junio de 2021 para mejorar la precisión de este evento extremo. Aplicaron la optimización no lineal utilizando el framework JAX acelerado por GPU para optimizar los datos.

Según Vonich, solo se necesitan 20 minutos para realizar 100 actualizaciones de condiciones iniciales en una GPU NVIDIA A100 Tensor Core.

Los investigadores probaron la precisión de su framework utilizando datos atmosféricos capturados durante la ola de calor del noroeste del Pacífico de 2021, que se excluyeron del conjunto de datos de entrenamiento original. Los datos optimizados redujeron los errores de pronóstico de 10 días en un 90%, prediciendo con éxito la intensidad y el momento de la ola de calor. También duplicó con creces la ventana de predicción, mejorando los pronósticos no optimizados con hasta 23 días de anticipación.

«Esta investigación puede mostrar que las observaciones y mediciones meteorológicas más precisas pueden ser tan importantes como el desarrollo de mejores modelos», dijo Vonich. «Si esta técnica se puede utilizar para identificar sesgos sistemáticos en las condiciones iniciales, podría tener un impacto inmediato en la mejora de las previsiones operativas. Además, más tiempo de entrega permite una mayor preparación para las comunidades. La aviación, el transporte marítimo y muchas otras industrias también dependen de pronósticos meteorológicos precisos. Las mejoras también pueden traducirse en un beneficio económico para ellos».

Póngase al día con el estudio Límite de Previsibilidad de la Ola de Calor del Noroeste del Pacífico de 2021 a Partir Del Análisis de Sensibilidad de Deep Learning.