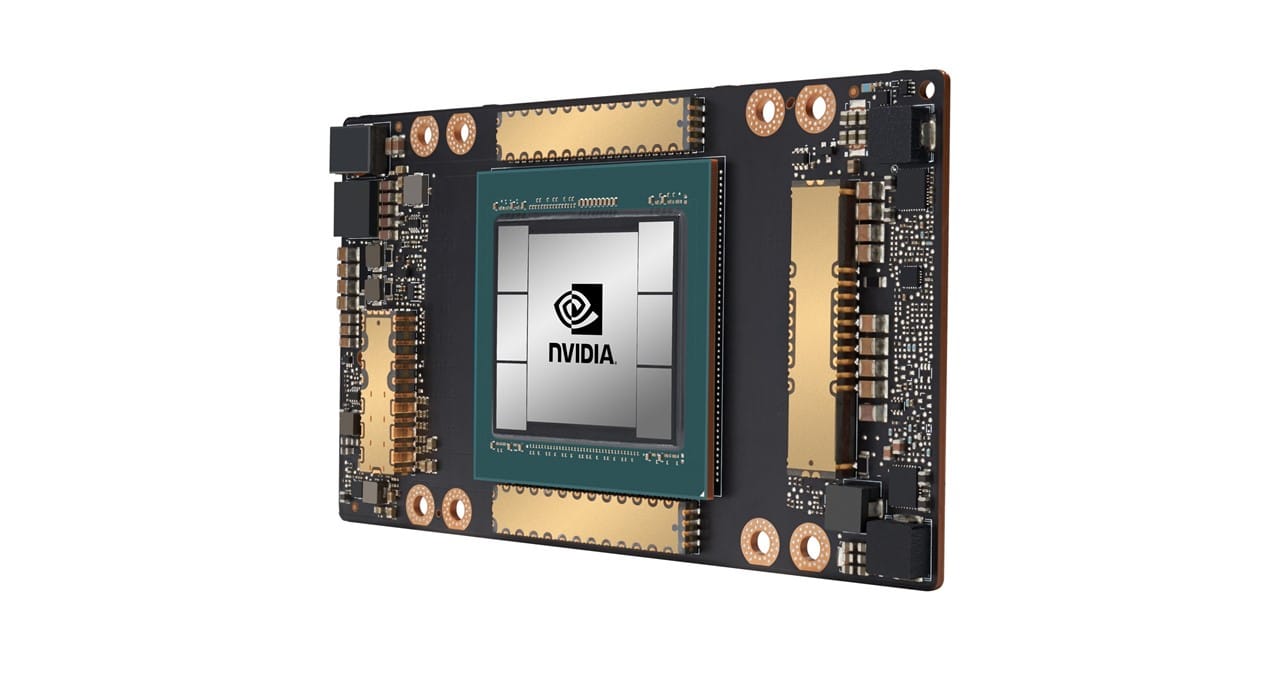

La GPU NVIDIA A100 Tensor Core ha llegado a Google Cloud.

La A100 ha llegado al cloud más rápido que cualquier GPU de NVIDIA en la historia, dado que ya está disponible en versión alfa en Google Compute Engine, a poco más de un mes después de su lanzamiento.

El lanzamiento de hoy de la familia de instancias de VM (A2) Accelerator-Optimized con A100 convierte a Google en el primer proveedor de servicios de cloud en ofrecer la nueva GPU de NVIDIA.

A100, que se basa en la reciente arquitectura NVIDIA Ampere, ofrece el mayor salto generacional de NVIDIA. Aumenta el rendimiento del entrenamiento y el procesamiento de inferencia en 20 veces, en comparación con sus predecesores, para proporcionar enormes aceleraciones para las cargas de trabajo que impulsan la revolución de la IA.

“Los clientes de Google Cloud a menudo nos buscan para proporcionar los últimos servicios de hardware y software para ayudarlos a impulsar la innovación en la IA y las cargas de trabajo de procesamiento científico”, dijo Manish Sainani, director de Gestión de Productos de Google Cloud. “Con nuestra nueva familia A2 VM, nos enorgullece ser el primer proveedor importante de cloud en comercializar GPU NVIDIA A100, tal como lo hicimos con las GPU NVIDIA T4. Estamos entusiasmados en ver qué harán nuestros clientes con estas nuevas capacidades.”

En los data centers de cloud, A100 puede potenciar una amplia gama de aplicaciones que requieren mucho procesamiento, lo que incluye el entrenamiento e inferencia de la inteligencia artificial, el análisis de datos, el procesamiento científico, la genómica, el análisis de video en el extremo, los servicios 5G y más.

Las industrias críticas de rápido crecimiento podrán acelerar sus descubrimientos con el rendimiento revolucionario de A100 en Google Compute Engine. Desde el escalamiento vertical del procesamiento científico y el entrenamiento de IA hasta el escalamiento horizontal de las aplicaciones de inferencia, que permiten la IA conversacional en tiempo real, A100 acelera cargas de trabajo complejas e impredecibles de todos los tamaños que se ejecutan en cloud.

NVIDIA CUDA 11, que pronto estará disponible para el público general, pone a disposición de los desarrolladores las nuevas capacidades de las GPU NVIDIA A100, que incluyen Tensor Cores, modos de precisión mixta, múltiples instancias de GPU, administración de memoria avanzada y construcciones de lenguaje en paralelo C ++/Fortran estándar.

Rendimiento de A100 Revolucionario en Cloud para las Cargas de Trabajo de Todos los Tamaños

Las nuevas instancias A2 VM pueden ofrecer diferentes niveles de rendimiento para acelerar de manera eficiente las cargas de trabajo del entrenamiento y la inferencia de machine learning habilitados por CUDA, del análisis de datos y del procesamiento de alto rendimiento.

Para las cargas de trabajo grandes y exigentes, Google Compute Engine ofrece a los clientes la instancia a2-megagpu-16g, que incluye 16 GPU A100, con un total de 640 GB de memoria de GPU y 1,3 TB de memoria del sistema, todo conectado mediante NVSwitch con hasta 9,6 TB/s de ancho de banda total.

Para aquellos con cargas de trabajo más pequeñas, Google Compute Engine también ofrece máquinas virtuales A2 en configuraciones más pequeñas para satisfacer las necesidades de aplicaciones específicas.

Google Cloud anunció que pronto se ofrecerá compatibilidad adicional con NVIDIA A100 para Google Kubernetes Engine, Plataforma IA en Cloud y otros servicios de Google Cloud. Para obtener más información, incluidos los detalles técnicos sobre la nueva familia A2 VM y cómo registrarse para acceder, visita el blog de Google Cloud.