NVIDIA ofrece el rendimiento de entrenamiento de IA más rápido del mundo entre los productos disponibles comercialmente, según las evaluaciones MLPerf que se publicaron hoy.

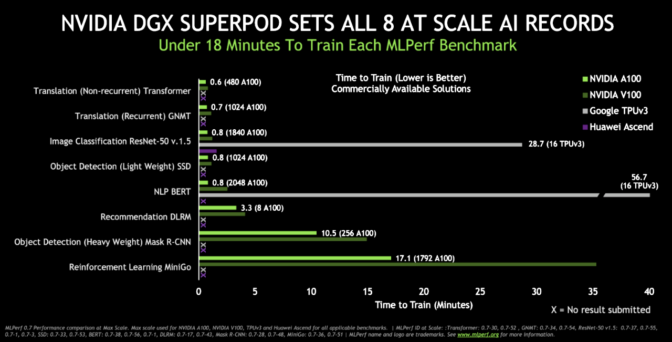

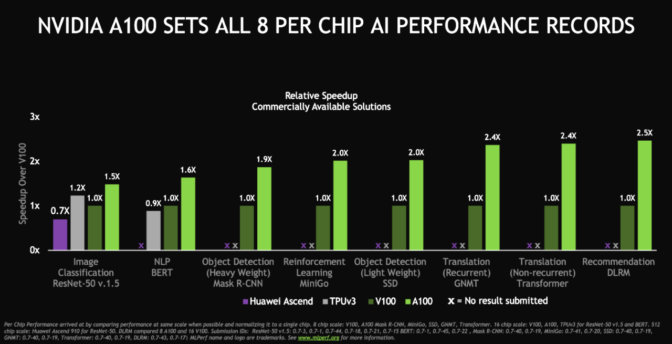

La GPU A100 Tensor Core demostró el rendimiento más rápido por acelerador en los ocho puntos de referencia MLPerf. Para obtener el tiempo más rápido en general para la solución a escala, el sistema DGX SuperPOD, un grupo masivo de sistemas DGX A100 conectados con HDR InfiniBand, también estableció ocho nuevos hitos de rendimiento. Los verdaderos ganadores son los clientes que aplican este desempeño hoy para transformar sus negocios de manera más rápida y rentable con IA.

Esta es la tercera participación consecutiva de NVIDIA, y la mejor, en las pruebas de entrenamiento de MLPerf, un grupo de evaluaciones de la industria, que se formó en mayo de 2018. NVIDIA estableció seis récords en las primeras evaluaciones de entrenamiento de MLPerf en diciembre de 2018 y ocho en julio de 2019.

NVIDIA estableció récords en la categoría que más les importan a los clientes: los productos disponibles comercialmente. Realizamos pruebas con nuestra última arquitectura NVIDIA Ampere y nuestra arquitectura Volta.

NVIDIA fue la única compañía que presentó productos disponibles comercialmente para todas las pruebas. La mayoría de las otras presentaciones utilizaron la categoría de vista previa, orientada a los productos que posiblemente no estarán disponibles hasta dentro varios meses, o la categoría de investigación, orientada a los productos que no se espera que estén disponibles durante algún tiempo.

NVIDIA Ampere Mejora en Tiempo Récord

Además de batir récords de rendimiento, el A100, el primer procesador basado en la arquitectura Ampere de NVIDIA, llegó al mercado más rápido que cualquier GPU de NVIDIA anterior. Al momento de su lanzamiento, se usó para potenciar los sistemas DGX de tercera generación de NVIDIA y estuvo disponible públicamente en un servicio de nube de Google solo seis semanas después.

Los proveedores de nube líderes en el mundo (como Alibaba Cloud, Amazon Web Services, Baidu Cloud, Microsoft Azure y Tencent Cloud) y docenas de los principales fabricantes de servidores (incluidos Dell Technologies, Hewlett Packard Enterprise, Inspur y Supermicro) también están ayudando a satisfacer la fuerte demanda de A100.

Los usuarios de todo el mundo están aplicando el A100 para abordar los desafíos más complejos en IA, ciencia de datos y computación científica.

Algunos usuarios están creando una nueva ola de sistemas de recomendación o aplicaciones de IA conversacional, mientras que otros potencian la búsqueda de tratamientos para el COVID-19. Todos aprovechan el avance de rendimiento generacional más importante en ocho generaciones de GPU de NVIDIA.

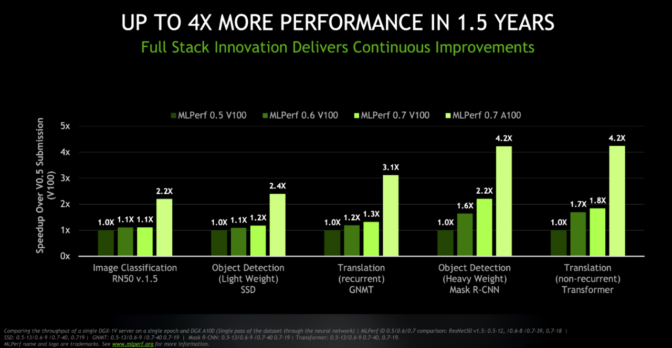

Un Rendimiento 4 Veces Superior en Menos de Dos Años

Los últimos resultados demuestran el enfoque de NVIDIA en la evolución continua de una plataforma de inteligencia artificial que abarca procesadores, redes, software y sistemas.

Por ejemplo, las pruebas muestran que, con las mismas tasas de transferencia, el sistema DGX actual con GPU A100 ofrece un rendimiento hasta 4 veces mejor que el sistema DGX que usó GPU V100, en la primera ronda de pruebas de entrenamiento MLPerf. Mientras tanto, el servidor DGX V100 original ahora puede ofrecer hasta el doble de rendimiento gracias a las últimas optimizaciones de software.

Mediante las innovaciones que se implementaron en la plataforma de IA, fue posible lograr estos avances en menos de dos años. Las GPU NVIDIA A100 de la actualidad, junto con las actualizaciones de software para las bibliotecas CUDA-X, potencian los clústeres en expansión desarrollados con redes Mellanox HDR 200 Gb/s InfiniBand.

HDR InfiniBand permite latencias extremadamente bajas, alto rendimiento de datos y ofrece motores inteligentes de aceleración de procesamiento mediante deep learning a través de la tecnología del Protocolo de Reducción y Agregación Jerárquica Escalable (SHARP).

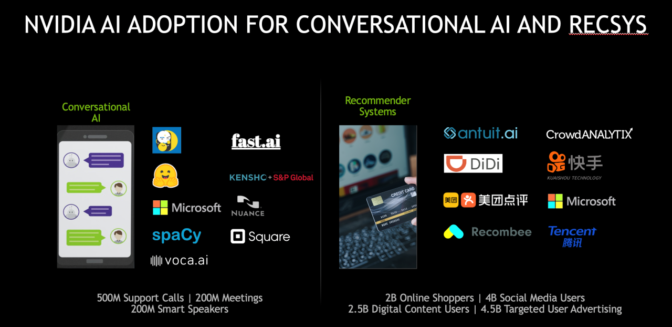

NVIDIA se Destaca en los Sistemas de Recomendación y la IA Conversacional

Las evaluaciones MLPerf, respaldadas por organizaciones como Amazon, Baidu, Facebook, Google, Harvard, Intel, Microsoft y Stanford, evolucionan constantemente para seguir siendo relevantes a medida que la IA evoluciona.

Las evaluaciones de referencia más recientes incluyeron dos nuevas pruebas en las que NVIDIA se destacó: una de ellas calificaba el rendimiento en los sistemas de recomendación, una tarea de IA cada vez más popular; la otra evaluación probó la IA conversacional con BERT, uno de los modelos de redes neuronales más complejos que se usan en la actualidad. Finalmente, la prueba de aprendizaje de refuerzo usó Mini-go con el tablero Go de tamaño completo de 19×19 y fue la prueba más compleja en esta ronda que involucró diversas operaciones desde el juego hasta el entrenamiento.

Las empresas ya están cosechando los beneficios de este rendimiento en estas aplicaciones estratégicas de IA.

En noviembre, Alibaba alcanzó un récord de ventas en el Día del Soltero de 38 000 millones de dólares, gracias a las GPU de NVIDIA que le permitió proporcionar más de 100 veces más consultas/segundo en sus sistemas de recomendación, en comparación con las CPU. Por su parte, la IA conversacional se está convirtiendo en el tema más popular, ya que impulsa los resultados comerciales en industrias desde las finanzas hasta la atención médica.

NVIDIA ofrece tanto el rendimiento necesario para ejecutar estos potentes trabajos como la facilidad de uso para aceptarlos.

El software allana caminos estratégicos hacia la IA

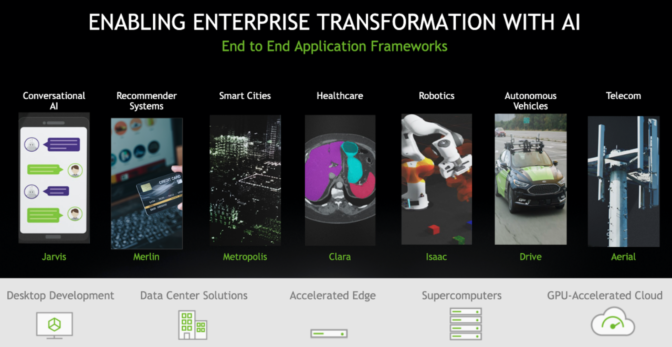

En mayo, NVIDIA anunció dos frameworks, Jarvis para IA conversacional y Merlin para sistemas de recomendación. Merlin incluye el framework HugeCTR para capacitación que impulsó los últimos resultados de MLPerf.

Estos son parte de una creciente familia de frameworks de aplicaciones para mercados que incluyen automotriz (NVIDIA DRIVE), atención de la salud (Clara), robótica (Isaac) y la venta minorista y las ciudades inteligentes (Metropolis).

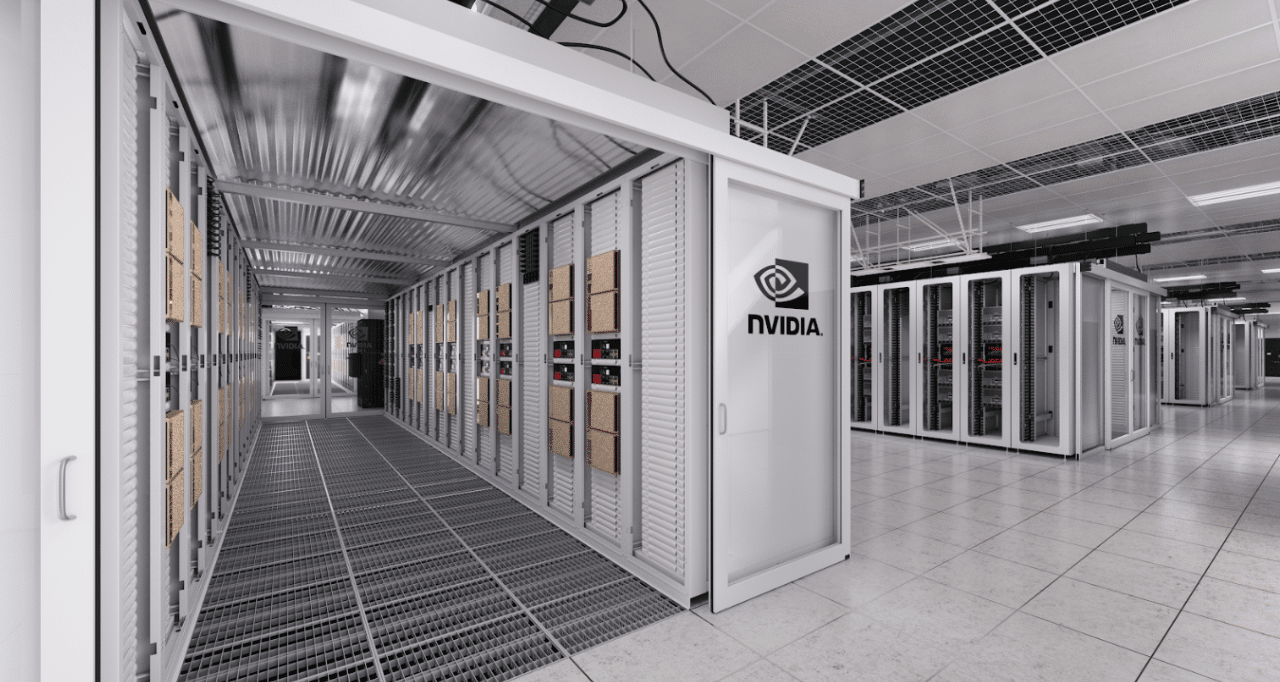

La Arquitectura DGX SuperPOD Ofrece Velocidad a Escala

NVIDIA realizó pruebas MLPerf para sistemas en Selene, un clúster interno basado en DGX SuperPOD, su arquitectura de referencia pública para clústeres de GPU a gran escala que se pueden implementar en semanas. Esa arquitectura amplía los principios de diseño y las prácticas recomendadas que se utilizan en DGX POD para resolver los problemas más desafiantes en la IA de hoy.

Selene debutó recientemente en la lista TOP500 como el sistema industrial más rápido en los EE. UU., con más de un exaflops de rendimiento de IA. Además, es el segundo sistema del mundo en cuanto a la eficiencia energética, según la lista Green500.

Los clientes ya están utilizando estas arquitecturas de referencia para desarrollar sistemas DGX POD y DGX SuperPOD por su cuenta. Entre ellos se incluye HiPerGator, la supercomputadora de IA académica más rápida de los EE. UU., que la Universidad de Florida presentará como la piedra angular de su iniciativa de IA de planes de estudios cruzados.

Mientras tanto, un centro superior de supercomputación, el Laboratorio Nacional de Argonne, está utilizando las GPU A100 para encontrar formas de combatir el COVID-19.. Argonne fue el primero de media docena de centros de procesamiento de alto rendimiento en adoptar las GPU A100.

Los sistemas DGP SuperPOD ya están generando resultados comerciales para empresas como Continental en la industria automotriz, Lockheed Martin en el sector aeroespacial y Microsoft en los servicios de computación en la nube.

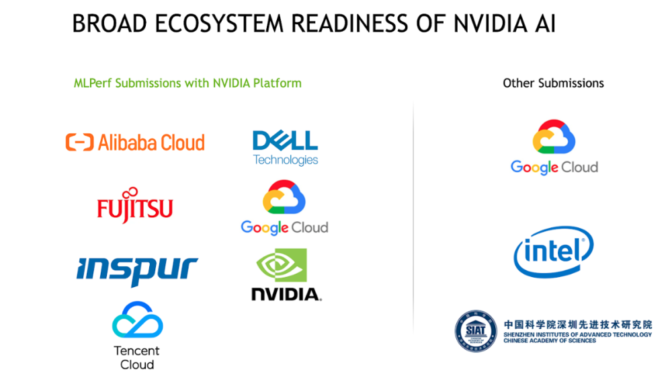

Todos estos sistemas están funcionando gracias, en parte, a un amplio ecosistema que admite las GPU de NVIDIA y los sistemas DGX.

Excelente Desempeño en la Evaluación MLPerf por Parte del Ecosistema de NVIDIA

De las nueve empresas que presentaron resultados, siete presentaron GPU NVIDIA, incluidos proveedores de servicios en cloud (Alibaba Cloud, Google Cloud, Tencent Cloud) y fabricantes de servidores (Dell, Fujitsu e Inspur), destacando la fortaleza del ecosistema de NVIDIA.

Muchos de estos socios utilizaron contenedores en NGC, el centro de software de NVIDIA, junto con marcos disponibles públicamente para sus envíos.

Los socios de MLPerf representan parte de un ecosistema de casi dos docenas de proveedores de servicios en cloud y OEM con productos o planes para instancias online, servidores y tarjetas PCIe que utilizan GPU NVIDIA A100.

El Software Probado Está Disponible en NGC Hoy

Gran parte del mismo software que NVIDIA y sus socios utilizaron para las últimas evaluaciones MLPerf está disponible para los clientes hoy mismo en NGC.

NGC aloja varios contenedores optimizados para GPU, scripts de software, modelos previamente entrenados y SDK. Permiten a los científicos y desarrolladores de datos acelerar sus flujos de trabajo de IA en marcos de trabajo populares como TensorFlow y PyTorch.

Las organizaciones están adoptando los contenedores para ahorrar tiempo y lograr resultados comerciales importantes antes. En definitiva, esa es la evaluación más importante de todos.

Representación artística en la parte superior: el nuevo DGX SuperPOD de NVIDIA, construido en menos de un mes y con más de 2,000 GPU NVIDIA A100, barrió todas las categorías de referencia de MLPerf para el rendimiento a escala entre los productos disponibles comercialmente.