En todo el mundo, las fábricas de IA están aumentando: nuevos data centers masivos construidos no para servir páginas web o correo electrónico, sino para entrenar e implementar inteligencia en sí. Los gigantes de internet han invertido miles de millones en infraestructura de IA a escala de nube para sus clientes. Las empresas están compitiendo para construir las bases de IA que generarán la próxima generación de productos y servicios. Los gobiernos también están invirtiendo, ansiosos por aprovechar la IA para la medicina personalizada y los servicios lingüísticos adaptados a las poblaciones nacionales.

Bienvenido a la era de las fábricas de IA, donde las reglas se están reescribiendo y el cableado no se parece en nada al viejo internet. Estos no son los típicos data centers de hiperescala. Son algo completamente diferente. Piense en ellos como motores de alto rendimiento unidos de decenas a cientos de miles de GPU, no solo construidos, sino orquestados, operados y activados como una sola unidad. ¿Y esa orquestación? Es todo el juego.

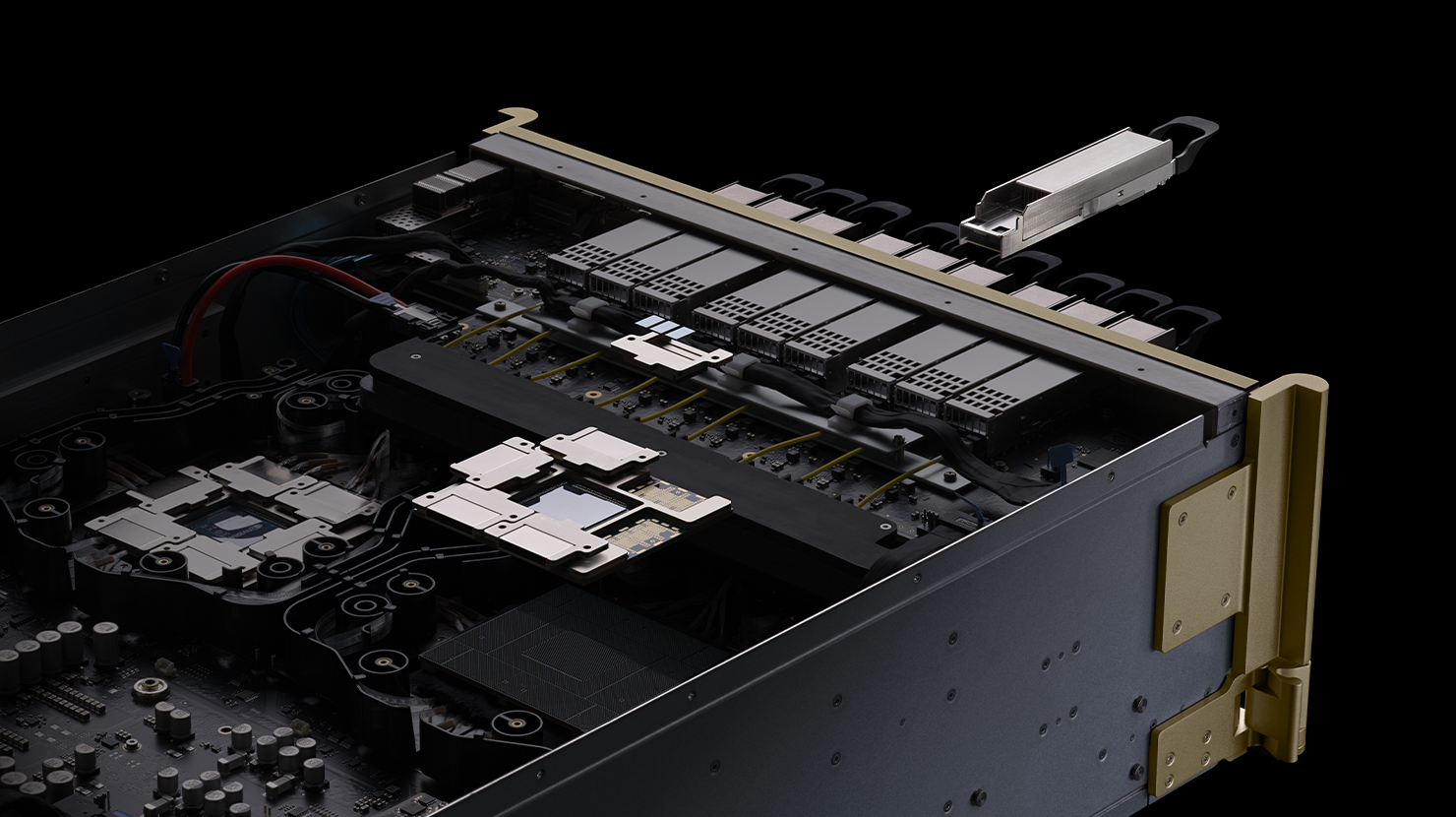

Este gigantesco data center se ha convertido en la nueva unidad de computación, y la forma en que estas GPU están conectadas define lo que esta unidad de computación puede hacer. Una arquitectura de red no es suficiente. Lo que se necesita es un diseño en capas con tecnologías de vanguardia, como ópticas empaquetadas que alguna vez parecieron ciencia ficción.

La complejidad no es un error; es la característica definitoria. La infraestructura de IA se está alejando rápidamente de todo lo que vino antes, y si no hay que repensar cómo se conectan los pipelines, la escala se rompe. Si las capas de red se equivocan, toda la máquina se detiene. Hazlo bien y obtén un rendimiento extraordinario.

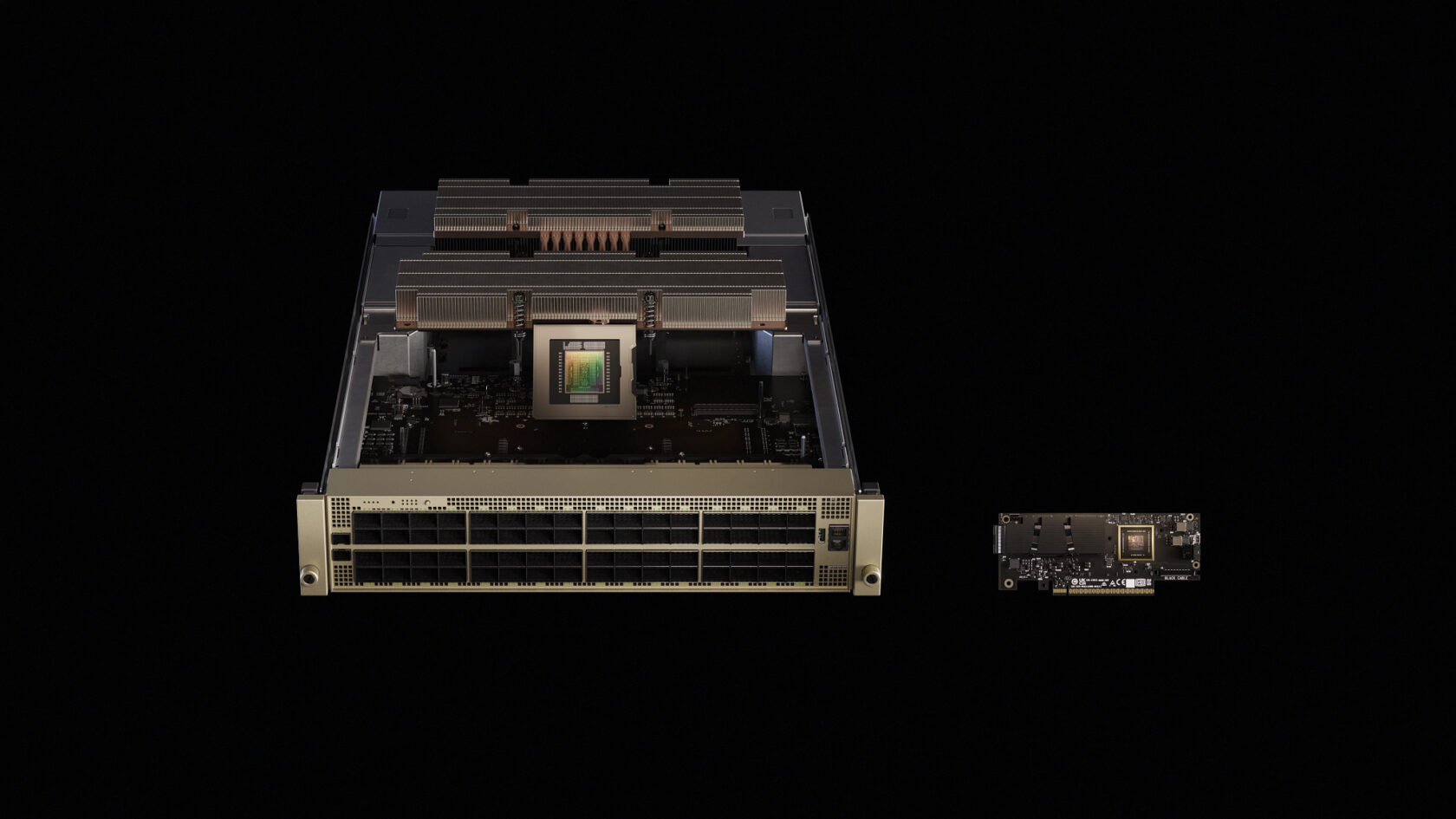

Con ese cambio viene el peso, literalmente. Hace una década, los chips se construyeron para ser elegantes y livianos. Ahora, el filo se parece al lomo de cobre de varios cientos de libras de un rack de servidores. Colectores refrigerados por líquido. Barras colectoras personalizadas. Espinas de cobre. La IA ahora exige hardware masivo a escala industrial. Y cuanto más profundos son los modelos, más se amplían y se expanden estas máquinas.

La columna vertebral NVIDIA NVLink, por ejemplo, está construida a partir de más de 5,000 cables coaxiales, enrollados herméticamente y enrutados con precisión. Es casi tantos datos por segundo como todo Internet. Eso es 130TB/s de ancho de banda de GPU a GPU, completamente mallado.

Esto no solo es rápido. Es fundamental. La superautopista de la IA ahora vive dentro del bastidor.

El Data Center es la Computadora

Entrenar los modelos de lenguaje grandes (LLM) modernos detrás de la IA no se trata de quemar ciclos en una sola máquina. Se trata de orquestar el trabajo de decenas o incluso cientos de miles de GPU que son los grandes impulsores de la computación de IA.

Estos sistemas se basan en la computación distribuida, dividiendo cálculos masivos entre nodos (servidores individuales), donde cada nodo maneja una porción de la carga de trabajo. En el entrenamiento, esas rebanadas, generalmente matrices masivas de números, deben fusionarse y actualizarse regularmente. Esa fusión se produce a través de operaciones colectivas, como «all-reduce» (que combina datos de todos los nodos y redistribuye el resultado) y «all-to-all» (donde cada nodo intercambia datos con todos los demás nodos).

Estos procesos son susceptibles a la velocidad y capacidad de respuesta de la red, lo que los ingenieros llaman latencia (retraso) y ancho de banda (capacidad de datos), lo que provoca paradas en el entrenamiento.

Para la inferencia, el proceso de ejecutar modelos entrenados para generar respuestas o predicciones, los desafíos se invierten. Los sistemas de generación aumentada por recuperación, que combinan LLM con búsqueda, exigen búsquedas y respuestas en tiempo real. Y en entornos de nube, la inferencia multiinquilino significa mantener las cargas de trabajo de diferentes clientes funcionando sin problemas, sin interferencias. Eso requiere redes ultrarrápidas y de alto rendimiento que puedan manejar una demanda masiva con un estricto aislamiento entre usuarios.

La Ethernet tradicional se diseñó para cargas de trabajo de un solo servidor, no para las demandas de la IA distribuida. Tolerar la fluctuación y la entrega inconsistente alguna vez fue aceptable. Ahora, es un cuello de botella. Las arquitecturas de switches Ethernet tradicionales nunca se diseñaron para un rendimiento constante y predecible, y ese legado aún da forma a sus últimas generaciones.

La computación distribuida requiere una infraestructura escalable creada para un funcionamiento sin fluctuación, una que pueda manejar ráfagas de rendimiento extremo, ofrecer baja latencia, mantener un rendimiento RDMA predecible y constante y aislar el ruido de la red. Esta es la razón por la que las redes InfiniBand son el estándar de oro para las supercomputadoras de computación de alto rendimiento y las fábricas de IA.

Con NVIDIA Quantum InfiniBand, las operaciones colectivas se ejecutan dentro de la propia red utilizando la tecnología de Scalable Hierarchical Aggregation and Reduction Protocol, duplicando el ancho de banda de datos para las reducciones. Utiliza enrutamiento adaptativo y control de congestión basado en telemetría para distribuir los flujos a través de rutas, garantizar un ancho de banda determinista y aislar el ruido. Estas optimizaciones permiten a InfiniBand escalar la comunicación de IA con precisión. Es por eso que la infraestructura NVIDIA Quantum conecta la mayoría de los sistemas en la lista TOP500 de las supercomputadoras más poderosas del mundo, demostrando un crecimiento del 35% en solo dos años.

Para clústeres que abarcan docenas de racks, los switches NVIDIA QuantumX800 Infiniband llevan a InfiniBand a nuevas alturas. Cada switch proporciona 144 puertos de conectividad de 800Gbps, con SHARPv4 basado en hardware, enrutamiento adaptativo y control de congestión basado en telemetría. La plataforma integra fotónica de silicio coempaquetada para minimizar la distancia entre la electrónica y la óptica, reduciendo el consumo de energía y la latencia. Junto con NVIDIA ConnectX-8 SuperNIC que ofrecen 800Gb/s por GPU, esta estructura vincula modelos de billones de parámetros e impulsa la computación en la red.

Pero los hiperescaladores y las empresas han invertido miles de millones en su infraestructura de software Ethernet. Necesitan un camino rápido hacia adelante que utilice el ecosistema existente para las cargas de trabajo de IA. Presentamos NVIDIA SpectrumX: un nuevo tipo de Ethernet diseñado específicamente para IA distribuida.

SpectrumX Ethernet: Llevando la IA a la Empresa

SpectrumX reinventa Ethernet para IA. Lanzado en 2023, SpectrumX ofrece redes sin pérdidas, enrutamiento adaptativo y aislamiento del rendimiento. El switcher SN5610, basado en el ASIC Spectrum4, admite velocidades de puerto de hasta 800Gb/s y utiliza el control de congestión de NVIDIA para mantener un rendimiento de datos del 95% a escala.

SpectrumX es Ethernet totalmente basado en estándares. Además de admitir Cumulus Linux, es compatible con el sistema operativo de red SONiC de código abierto,dando flexibilidad a los clientes. Un ingrediente clave son los NVIDIA SuperNIC, basados en NVIDIA BlueField-3 o ConnectX-8, que proporcionan conectividad RoCE de hasta 800Gb/s y descargar el reordenamiento de paquetes y la gestión de la congestión.

Spectrum-X trae las mejores innovaciones de InfiniBand, como el control de congestión basado en telemetría, el equilibrio de carga adaptativo y la colocación directa de datos, a Ethernet, lo que permite a las empresas escalar a cientos de miles de GPU. Los sistemas a gran escala con SpectrumX, incluida la supercomputadora de IA más colosal del mundo, han logrado un rendimiento de datos del 95% con cero degradación de la latencia de las aplicaciones. Las estructuras Ethernet estándar ofrecerían solo aproximadamiente 60% de rendimiento debido a colisiones de flujo.

Una Cartera para ScaleUp y ScaleOut

Ninguna red puede servir a todas las capas de una fábrica de IA. El enfoque de NVIDIA es hacer coincidir la estructura correcta con el nivel correcto, luego unir todo con software y silicio.

NVLink: Escalado Vertical Dentro del Rack

Dentro de un bastidor de servidores, las GPU deben comunicarse entre sí como si fueran núcleos diferentes en el mismo chip. NVIDIA NVLink y NVLink Switch amplían la memoria y el ancho de banda de la GPU en todos los nodos. En un sistema NVIDIA GB300 NVL72, 36 CPU NVIDIA Grace y 72 GPU NVIDIA Blackwell Ultra están conectadas en un único dominio NVLink, con un ancho de banda agregado de 130TB/s. La tecnología NVLink Switch amplía aún más esta estructura: un solo sistema GB300 NVL72 puede ofrecer 130TB/s de ancho de banda de GPU, lo que permite que los clústeres admitan 9 veces el número de GPU de un solo servidor de 8 GPU. Con NVLink, todo el rack se convierte en una GPU grande.

Fotónica: El Próximo Salto

Para llegar a millones de fábricas de IA de GPU, la red debe romper los límites de potencia y densidad de la óptica enchufable. Los switches NVIDIA Quantum-X y Spectrum-X Photonics integran la fotónica de silicio directamente en el paquete del switch, ofreciendo de 128 a 512 puertos de 800Gb/s con anchos de banda totales que van desde 100Tb/s a 400Tb/s. Estos conmutadores ofrecen 3,5 veces más eficiencia energética y 10 veces mejor resiliencia en comparación con la óptica tradicional, allanando el camino para las fábricas de IA a escala de gigavatios.

Cumplir la Promesa de los Estándares Abiertos

SpectrumX y NVIDIA Quantum InfiniBand se basan en estándares abiertos. SpectrumX es Ethernet totalmente basado en estándares con soporte para stacks Ethernet abiertos como SONiC, mientras que NVIDIA Quantum InfiniBand y Spectrum-X cumplen con las especificaciones InfiniBand y RDMA sobre Ethernet convergente (RoCE) de la Asociación Comercial InfiniBand. Los elementos clave del stack de software de NVIDIA, incluidas las bibliotecas NCCL y DOCA, se ejecutan en una variedad de hardware, y socios como Cisco, Dell Technologies, HPE y Supermicro integran Spectrum-X en sus sistemas.

Los estándares abiertos crean la base para la interoperabilidad, pero los clústeres de IA del mundo real requieren una optimización estricta en todo el stack: GPU, NIC, switches, cables y software. Los proveedores que invierten en integración de extremo a extremo ofrecen una mejor latencia y rendimiento. SONiC, el sistema operativo de red de código abierto reforzado en data centers de hiperescala, elimina las licencias y el bloqueo de proveedores y permite una personalización intensa, pero los operadores aún eligen stacks de hardware y software especialmente diseñados para satisfacer las necesidades de rendimiento de la IA. En la práctica, los estándares abiertos por sí solos no ofrecen un rendimiento determinista; necesitan innovación en capas.

Hacia Fábricas de IA de Millones de GPU

Las fábricas de IA están escalando rápidamente. Los gobiernos de Europa están construyendo siete fábricas nacionales de IA, mientras que los proveedores de la nube y las empresas de Japón, India y Noruega están implementando la infraestructura de IA impulsada por NVIDIA. El próximo horizonte son las instalaciones de gigavatios con un millón de GPU. Para llegar allí, la red debe evolucionar de una ocurrencia tardía a un pilar de la infraestructura de IA.

La lección de la era de los data centers de gigavatios es simple: el data center ahora es la computadora. NVLink une las GPU dentro del bastidor. NVIDIA Quantum InfiniBand los escala a través de él. Spectrum-X lleva ese rendimiento a mercados más amplios. La fotónica de silicio lo hace sostenible. Todo está abierto donde importa, optimizado donde cuenta.