Los data centers tradicionales en la nube han servido como base de la infraestructura de computación durante más de una década, atendiendo a una amplia gama de usuarios y aplicaciones. Sin embargo, los data centers han evolucionado en los últimos años para mantenerse al día con los avances tecnológicos y la creciente demanda de computación impulsada por IA. Esta publicación explora el papel fundamental que desempeñan las redes para dar forma al futuro de los data centers y facilitar la era de la IA.

Data Centers Especializados: Fábricas de IA y Nubes de IA

Actualmente están surgiendo dos clases distintas de data centers: las fábricas de IA y las nubes de IA. Ambos están diseñados para satisfacer las demandas únicas de las cargas de trabajo de IA, que se caracterizan por su dependencia de la computación acelerada.

Las fábricas de IA están diseñadas para manejar workflows masivos y a gran escala y el desarrollo de grandes modelos de lenguaje (LLM) y otros modelos de IA fundamentales. Estos modelos son los componentes básicos con los que se construyen los sistemas de IA más avanzados. Para permitir un escalado sin problemas y una utilización eficiente de los recursos en miles de GPU, es imprescindible contar con una red sólida y de alto rendimiento.

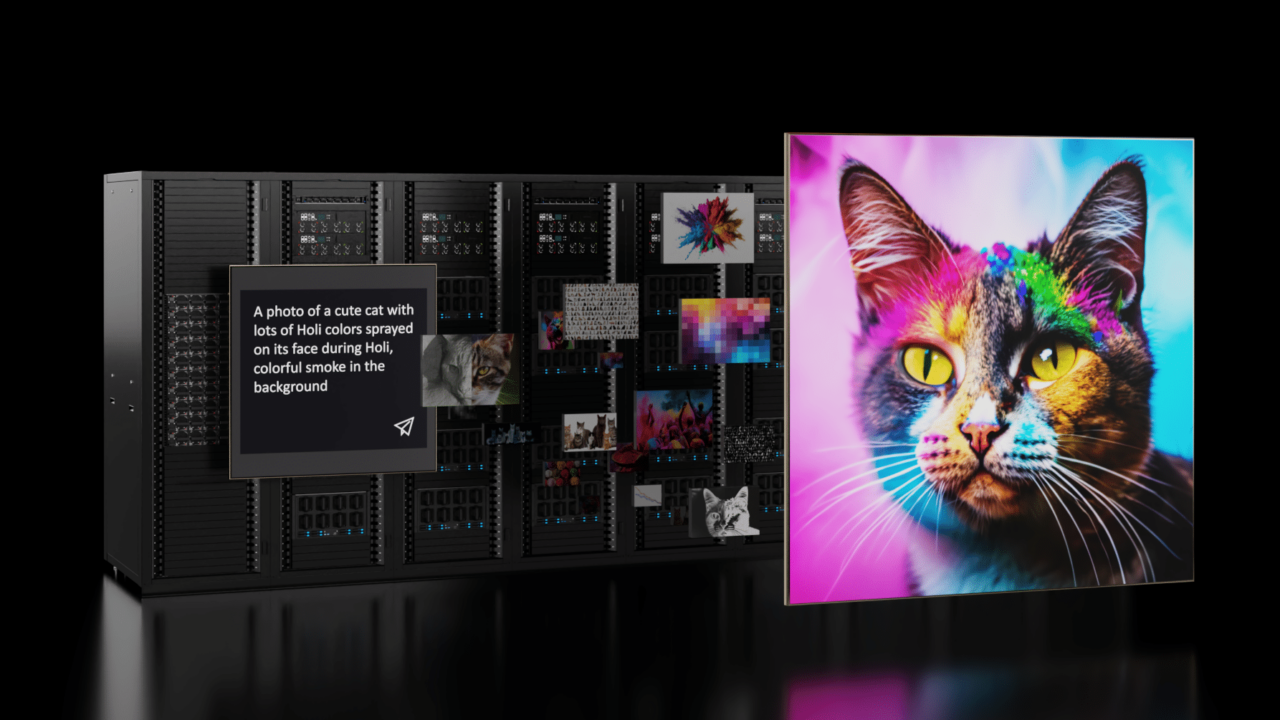

Las nubes de IA amplían las capacidades de la infraestructura de nube tradicional para admitir aplicaciones de IA generativa a gran escala. La IA generativa va más allá de los sistemas de IA convencionales al crear nuevos contenidos, como imágenes, texto y audio, basados en los datos con los que ha sido entrenada. La gestión de nubes de IA con miles de usuarios requiere herramientas de gestión avanzadas y una infraestructura de red que pueda gestionar diversas cargas de trabajo de forma eficiente.

IA y Computación Distribuida

Las cargas de trabajo de IA son intensivas desde el punto de vista computacional, especialmente las que implican modelos grandes y complejos como ChatGPT y BERT. Para acelerar el entrenamiento de modelos y el procesamiento de grandes conjuntos de datos, los profesionales de la IA han recurrido a la computación distribuida. Este enfoque implica distribuir la carga de trabajo entre varios servidores o nodos interconectados conectados a través de una red de alta velocidad y baja latencia.

La computación distribuida es fundamental para el éxito de la IA, y la escalabilidad y la capacidad de la red para manejar un número creciente de nodos es crucial. Una red altamente escalable permite a los investigadores de IA aprovechar más recursos computacionales, lo que conduce a un rendimiento más rápido y mejorado.

A la hora de diseñar la arquitectura de red para los data centers de IA, es esencial crear una solución integrada con la computación distribuida como máxima prioridad. Los arquitectos de data centers deben considerar cuidadosamente el diseño de la red y adaptar las soluciones a las demandas únicas de las cargas de trabajo de IA que planean implementar.

NVIDIA Quantum-2 InfiniBand y NVIDIA Spectrum-X son dos plataformas de red diseñadas y optimizadas específicamente para hacer frente a los desafíos de red del data center de IA, cada una con sus propias características e innovaciones únicas.

InfiniBand Impulsa el Rendimiento de la IA

La tecnología InfiniBand ha sido una fuerza impulsora detrás de las implementaciones de supercomputación a gran escala para la computación científica distribuida compleja. Se ha convertido en la red de facto para las fábricas de IA. Con latencias ultrabajas, InfiniBand se ha convertido en un eje para acelerar las aplicaciones de computación de alto rendimiento (HPC) e IA convencionales de hoy en día. Muchas de las capacidades de red cruciales necesarias para que los sistemas de IA sean eficientes son nativas de la plataforma NVIDIA Quantum-2 InfiniBand.

La computación en red, impulsada por InfiniBand, integra motores de computación basados en hardware en la red. Esto descarga operaciones complejas a escala y utiliza el protocolo de agregación y reducción jerárquica escalable (SHARP) de NVIDIA, un mecanismo de agregación dentro de la red. SHARP admite múltiples operaciones colectivas simultáneas, lo que duplica el ancho de banda de datos para reducir los datos y mejorar el rendimiento.

El enrutamiento adaptativo InfiniBand distribuye el tráfico de forma óptima, mitigando la congestión y mejorando la utilización de los recursos. Dirigido por un administrador de subred, InfiniBand selecciona rutas libres de congestión en función de las condiciones de la red, maximizando la eficiencia sin comprometer el orden de llegada de los paquetes.

La arquitectura de control de congestión de InfiniBand garantiza un ancho de banda y una latencia deterministas. Utiliza un proceso de tres etapas para gestionar la congestión, evitando cuellos de botella en el rendimiento de las cargas de trabajo de IA.

Estas optimizaciones inherentes permiten a InfiniBand satisfacer las demandas de las aplicaciones de IA y, en última instancia, impulsar un rendimiento y una eficiencia superiores.

Navegación por Ethernet para Implementaciones de IA

La implementación de redes Ethernet para una infraestructura de IA requiere abordar las necesidades específicas del protocolo Ethernet. Con el tiempo, Ethernet ha incorporado un conjunto de características expansivo, completo y (a veces) complejo que se adapta a una amplia gama de escenarios de red.

Como tal, Ethernet tradicional o listo para usar no está diseñado explícitamente para un alto rendimiento. Las nubes de IA que utilizan Ethernet tradicional para su estructura de computación solo pueden lograr una fracción del rendimiento que lograrían con una red optimizada.

En entornos multiinquilino en los que se ejecutan simultáneamente varios trabajos de IA, el aislamiento del rendimiento es fundamental para evitar una mayor degradación del rendimiento. Si hay un error de enlace, la estructura Ethernet tradicional puede hacer que el rendimiento de IA del clúster se reduzca a la mitad. Esto se debe a que Ethernet tradicional se ha optimizado principalmente para los workflows empresariales cotidianos y no está diseñado para satisfacer las demandas de las aplicaciones de IA de alto rendimiento que dependen de la Biblioteca de Comunicaciones Colectivas (NCCL) de NVIDIA.

Estos problemas de rendimiento se deben a factores inherentes a Ethernet tradicional, entre los que se incluyen:

- Latencias de conmutación más altas, comunes en todos los ASIC básicos

- Arquitectura de switch de búfer dividido, que puede provocar injusticias en el ancho de banda

- Equilibrio de carga suboptimizado para los grandes flujos generados por las cargas de trabajo de IA

- Aislamiento del rendimiento y problemas de vecinos ruidosos

La plataforma de red Spectrum-X resuelve estos problemas y más. Spectrum-X se basa en el protocolo Ethernet estándar con extensiones RDMA sobre Ethernet convergente (RoCE), lo que mejora el rendimiento de la IA. Estas extensiones aprovechan las mejores prácticas nativas de InfiniBand y aportan innovaciones como el enrutamiento adaptativo y el control de congestión a Ethernet.

Spectrum-X es la única plataforma Ethernet que ofrece el alto ancho de banda efectivo y el aislamiento de rendimiento necesarios para las nubes de IA generativa multiusuario, habilitadas gracias a que Spectrum-4 funciona en estrecha coordinación con las DPU NVIDIA BlueField-3.

Resumen

La era de la IA está aquí, y la red es la piedra angular de su éxito. Para aprovechar al máximo el potencial de la IA, los arquitectos de data centers deben considerar cuidadosamente el diseño de la red y adaptar estos diseños a las demandas únicas de las cargas de trabajo de IA. Abordar las consideraciones de red es clave para liberar todo el potencial de las tecnologías de IA e impulsar la innovación en la industria de los data centers.

NVIDIA Quantum InfiniBand es una opción ideal para las fábricas de IA, gracias a sus latencias ultrabajas, su rendimiento escalable y sus conjuntos de funciones avanzadas. NVIDIA Spectrum-X, con sus innovaciones tecnológicas especialmente diseñadas para la IA, ofrece una solución innovadora para las organizaciones que crean nubes de IA basadas en Ethernet.

Para obtener más información sobre las demandas de rendimiento de la IA y los requisitos de red, consulte el documento técnico Networking for the Era of AI.