Un equipo de investigación tiene como objetivo sacudir el statu quo de los modelos de terremotos.

Investigadores de las Universidades de California en Berkeley y Santa Cruz, y de la Universidad Técnica de Múnich publicaron recientemente un artículo que describe un nuevo modelo que ofrece deep learning a la predicción de terremotos.

Apodado RECAST, el modelo puede utilizar conjuntos de datos más grandes y ofrecer una mayor flexibilidad que el estándar de modelo actual, ETAS, que ha mejorado solo de forma incremental desde su desarrollo en 1988, argumenta.

Los autores del artículo, Kelian Dascher-Cousineau, Oleksandr Shchur, Emily Brodsky y Stephan Günnemann, entrenaron el modelo en workstations con GPU NVIDIA.

«Hay todo un campo de investigación que explora cómo mejorar ETAS», dijo Dacher-Cousineau, investigadora postdoctoral en UC Berkeley. «Es un modelo inmensamente útil que se ha utilizado mucho, pero ha sido frustrantemente difícil mejorarlo».

La IA Impulsa la Sismología

La promesa de RECAST es que la flexibilidad de su modelo, su capacidad de autoaprendizaje y su capacidad de escalar le permitirán interpretar conjuntos de datos más grandes y hacer mejores predicciones durante las secuencias de terremotos, dijo.

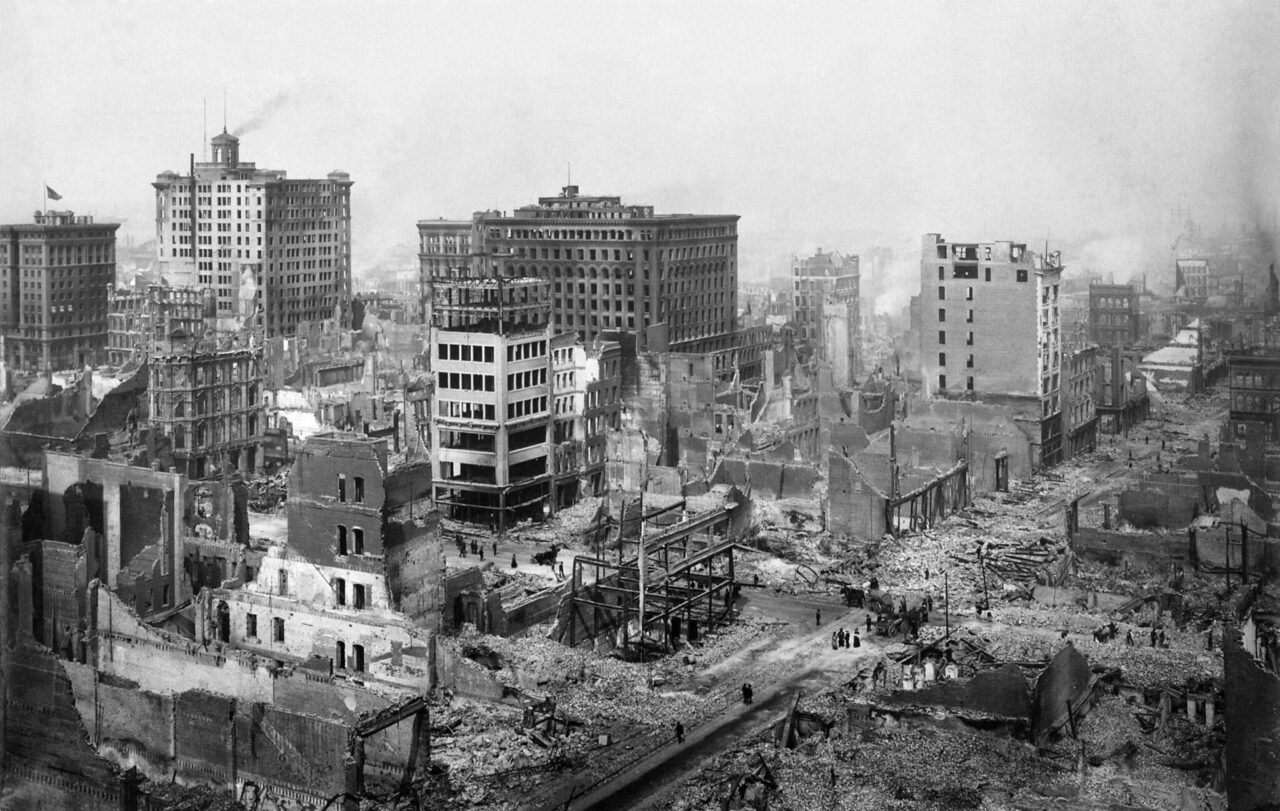

Los avances de los modelos con mejores pronósticos podrían ayudar a agencias como el Servicio Geológico de Estados Unidos y sus contrapartes en otros lugares a ofrecer mejor información a quienes necesitan saber. Los bomberos y otros socorristas que ingresan a los edificios dañados, por ejemplo, podrían beneficiarse de pronósticos más confiables sobre las réplicas.

«Hay mucho margen de mejora en el lado de las previsiones. Y por una variedad de razones, nuestra comunidad realmente no se ha sumergido en el lado del machine learning de las cosas, en parte debido a que somos conservadores y en parte porque estas son decisiones realmente impactantes», dijo Dacher-Cousineau.

El Modelo RECAST Mueve la Aguja

Si bien el trabajo anterior sobre las predicciones de réplicas se ha basado en modelos estadísticos, esto no se escala para manejar los conjuntos de datos más grandes que están disponibles a partir de una explosión de capacidades de datos recientemente mejoradas, según los investigadores.

La arquitectura del modelo RECAST se basa en los desarrollos de los procesos de puntos temporales neuronales, que son modelos generativos probabilísticos para secuencias de eventos de tiempo continuo. En pocas palabras, el modelo tiene una arquitectura de red neuronal codificador-decodificador que se utiliza para predecir el momento de un próximo evento basado en un historial de eventos pasados.

Dacher-Cousineau dijo que la publicación y la evaluación comparativa del modelo en el documento demuestra que puede aprender rápidamente a hacer lo que ETAS puede hacer, mientras que tiene un gran potencial para hacer más.

«Nuestro modelo es un modelo generativo que, al igual que un modelo de procesamiento del lenguaje natural, puede generar párrafos y párrafos de palabras, y puede muestrearlo y hacer catálogos sintéticos», dijo Dacher-Cousineau. «Parte del documento está ahí para convencer a los sismólogos de la vieja escuela de que este es un modelo que está haciendo lo correcto, no estamos sobreadaptando».

Aumento de los Datos Sísmicos con Catálogos Mejorados

Los catálogos de terremotos, o registros de datos de terremotos, para geografías particulares pueden ser pequeños. Esto se debe a que, hasta el día de hoy, muchos provienen de analistas sísmicos que interpretan garabatos de datos en bruto que provienen de los sismómetros. Pero esta también es un área en la que los investigadores de IA están construyendo modelos para interpretar de forma autónoma estas ondas P y otras señales en los datos en tiempo real.

Mientras tanto, los datos mejorados están ayudando a llenar el vacío. Con los datos etiquetados en los catálogos de terremotos, los ingenieros de machine learning están revisando estas fuentes de datos sin procesar y creando catálogos mejorados para obtener de 10 a 100 veces el número de terremotos para los datos y categorías de entrenamiento.

«Por lo tanto, no es necesariamente que pongamos más instrumentos para recopilar datos, sino que mejoramos los conjuntos de datos», dijo Dacher-Cousineau.

Aplicación de Conjuntos de Datos Más Grandes a Otras Configuraciones

Con los conjuntos de datos más grandes, los investigadores están empezando a ver mejoras de RECAST con respecto al modelo ETAS estándar.

Para avanzar en el estado del arte en el pronóstico de terremotos, Dascher-Cousineau está trabajando con un equipo de estudiantes universitarios de UC Berkeley para capacitar catálogos de terremotos en múltiples regiones para mejores predicciones.

«Tengo en mente las analogías del procesamiento del lenguaje natural, donde parece muy plausible que las secuencias de terremotos en Japón sean útiles para informar los terremotos en California», dijo. «Y se puede ver que va en la dirección correcta».

Más información sobre la generación de datos sintéticos con NVIDIA Omniverse Replicator