Abordar uno de los mayores desafíos de computación de esta útil requiere una computación más grande que la vida.

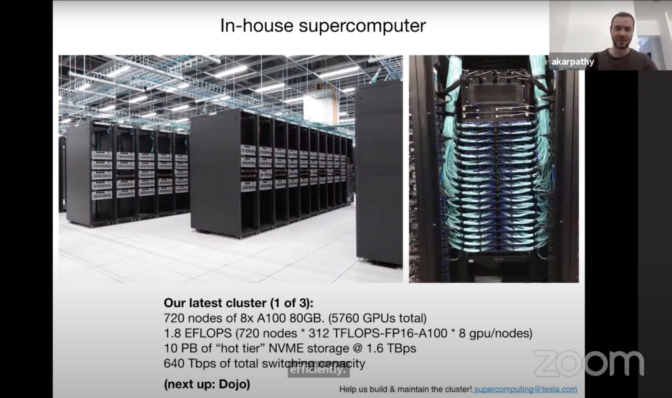

En CVPR en junio pasado, Andrej Karpathy, director senior de IA en Tesla, presentó la supercomputadora interna que el fabricante de automóviles está utilizando para entrenar redes neuronales profundas para el piloto automático y las capacidades de conducción autónoma. El clúster utiliza 720 nodos de 8 GPU NVIDIA A100 Tensor Core (5,760 GPU en total) para lograr un rendimiento de 1.8 exaflops líder en la industria.

“Esta es una supercomputadora realmente increíble”, dijo Karpathy. “En realidad creo que en términos de flops, esta es aproximadamente la supercomputadora nro. 5 del mundo”.

Con niveles sin precedentes de computación para la industria automotriz en el centro de su ciclo de desarrollo, Tesla permite que los ingenieros de vehículos autónomos hagan el trabajo de su vida de manera eficiente y a la vanguardia.

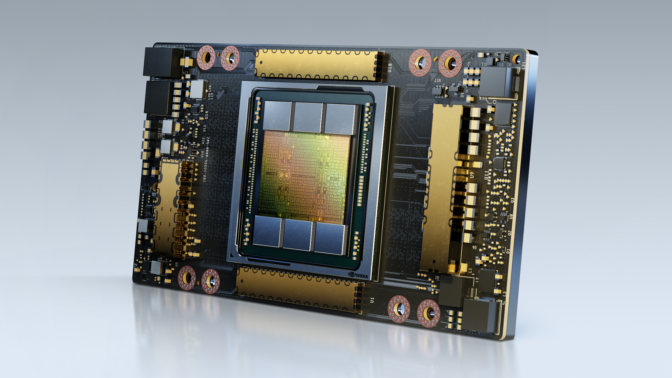

Las GPU NVIDIA A100 ofrecen una aceleración en todas las escalas para potenciar los data centers de mayor rendimiento del mundo. Con la arquitectura NVIDIA Ampere, la GPU A100 proporciona un rendimiento hasta 20 veces mayor que la generación anterior y se puede dividir en siete instancias de GPU para ajustarse dinámicamente a las demandas cambiantes.

El clúster de GPU es parte del enfoque de conducción autónoma verticalmente integrado de Tesla, que utiliza más de 1 millón de automóviles que ya recorren las carreteras para refinar y construir nuevas características para la mejora continua.

El clúster de GPU es parte del enfoque de conducción autónoma verticalmente integrado de Tesla, que utiliza más de 1 millón de automóviles que ya recorren las carreteras para refinar y construir nuevas características para la mejora continua.

Del Automóvil al Data Center

El desarrollo cíclico de Tesla comienza en el coche. Una red neuronal profunda que se ejecuta en “modo sombra” percibe y hace predicciones silenciosamente mientras el automóvil está conduciendo sin controlar realmente el vehículo.

Estas predicciones se graban y los errores o identificaciones erróneas se almacenan. Los ingenieros de Tesla luego usan estas instancias para crear un conjunto de datos de entrenamiento de escenarios difíciles y diversos para refinar la DNN.

El resultado es una colección de aproximadamente 1 millón de clips de 10 segundos grabados a 36 cuadros por segundo, con un increíble número total de 1.5 petabytes de datos. A continuación, la DNN se ejecuta en estos escenarios del data center una y otra vez hasta que funciona sin errores. Finalmente, se envía de vuelta al vehículo y comienza el proceso de nuevo.

Karpathy dijo que entrenar una DNN de esta manera y en una cantidad tan grande de datos requiere “una gran cantidad de computación”, lo que llevó a Tesla a construir e implementar la supercomputadora de la generación actual con GPU A100 de alto rendimiento.

Iteración Continua

Además de la capacitación integral, la supercomputadora de Tesla brinda a los ingenieros de vehículos autónomos el rendimiento necesario para experimentar e iterar en el proceso de desarrollo.

Karpathy dijo que la estructura actual de DNN que el fabricante de automóviles está implementando permite a un equipo de 20 ingenieros trabajar en una sola red a la vez, aislando diferentes características para el desarrollo paralelo.

Estos DNN se pueden ejecutar a través de conjuntos de datos de entrenamiento a velocidades más rápidas de lo que anteriormente era posible para una iteración rápida.

“La visión de computación es la base de lo que hacemos y permite el piloto automático. Para que eso funcione, necesitas entrenar una enorme red neuronal y experimentar mucho”, dijo Karpathy. “Es por eso que hemos invertido mucho en la computación”.