Desde asistentes de IA que realizan investigaciones profundas hasta vehículos autónomos que toman decisiones de navegación en fracciones de segundo, la adopción de IA está explotando en todas las industrias.

Detrás de cada una de esas interacciones está la inferencia, la etapa posterior al entrenamiento en la que un modelo de IA procesa entradas y produce salidas en tiempo real.

Los modelos de razonamiento de IA más avanzados de la actualidad , capaces de lógica de varios pasos y toma de decisiones complejas, generan muchos más tokens por interacción que los modelos más antiguos, lo que impulsa un aumento en el uso de tokens y la necesidad de una infraestructura que pueda fabricar inteligencia a escala.

Las fábricas de IA son una forma de satisfacer estas crecientes necesidades.

Pero ejecutar inferencias a una escala tan grande no se trata solo de arrojar más cómputo al problema.

Para implementar la IA con la máxima eficiencia, la inferencia debe evaluarse en función del marco Think SMART:

- Escala y complejidad

- Rendimiento multidimensional

- Arquitectura y software

- Retorno de la inversión impulsado por el rendimiento

- Ecosistema tecnológico y base instalada

Escala y Eficiencia

A medida que los modelos evolucionan de aplicaciones compactas a sistemas masivos y multiexpertos, la inferencia debe seguir el ritmo de cargas de trabajo cada vez más diversas, desde responder consultas rápidas de una sola vez hasta razonar en varios pasos que involucran millones de tokens.

El tamaño cada vez mayor y la complejidad de los modelos de IA introducen importantes implicaciones para la inferencia, como la intensidad de los recursos, la latencia y el rendimiento, la energía y los costos, así como la diversidad de casos de uso.

Para hacer frente a esta complejidad, los proveedores de servicios de IA y las empresas están ampliando su infraestructura, con nuevas fábricas de IA que se conectan de socios como CoreWeave, Dell Technologies,Google Cloud y Nebius.

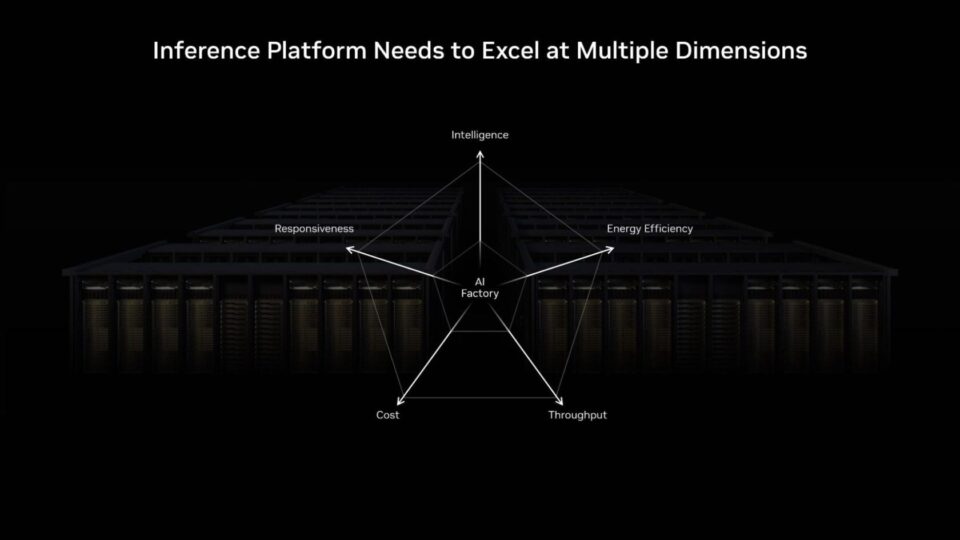

Rendimiento Multidimensional

Escalar implementaciones complejas de IA significa que las fábricas de IA necesitan la flexibilidad para servir tokens en un amplio espectro de casos de uso mientras equilibran la precisión, la latencia y los costos.

Algunas cargas de trabajo, como la traducción de voz a texto en tiempo real, exigen una latencia ultrabaja y una gran cantidad de tokens por usuario, lo que agota los recursos computacionales para obtener la máxima capacidad de respuesta. Otros son insensibles a la latencia y están orientados al rendimiento puro, como generar respuestas a docenas de preguntas complejas simultáneamente.

Pero los escenarios en tiempo real más populares operan en algún punto intermedio: requieren respuestas rápidas para mantener contentos a los usuarios y un alto rendimiento para atender simultáneamente a millones de usuarios, todo mientras se minimiza el costo por token.

Por ejemplo, la plataforma de inferencia NVIDIA está diseñado para equilibrar tanto la latencia como el rendimiento, impulsando los puntos de referencia de inferencia en modelos como GPT-OSS, búsqueda profunda-R1 y Llama 3.1.

Qué Evaluar para Lograr un Rendimiento Multidimensional Óptimo

- Inteligencia: Evalúe cómo el tamaño y la complejidad del modelo impactan tanto el rendimiento como el costo. Los modelos más grandes pueden ofrecer una inteligencia más profunda, pero requieren mucha más capacidad de cómputo, lo que afecta la eficiencia general.

- Capacidad de Respuesta: Equilibre la experiencia del usuario con la escalabilidad del sistema. Asignar más capacidad de cómputo por consulta mejora la capacidad de respuesta, mientras que compartir recursos entre usuarios maximiza el rendimiento total y los ingresos.

- Eficiencia Energética: Mida el rendimiento en tokens por segundo por vatio para comprender la productividad real dentro de los límites de potencia. Lograr una mayor eficiencia energética se traduce directamente en una mejor economía y sostenibilidad a gran escala.

- Costo: Evalúe el rendimiento por dólar para garantizar una implementación de IA escalable y rentable. La economía sostenible proviene de equilibrar la capacidad de respuesta de baja latencia con la eficiencia de alto rendimiento en diversas cargas de trabajo de inferencia.

- Rendimiento: Realice un seguimiento de cuántos tokens procesa su sistema por segundo y con qué flexibilidad se adapta a la demanda variable. Optimizar el rendimiento de tokens es esencial para escalar las cargas de trabajo y maximizar la producción.

Arquitectura y Software Codesign

El rendimiento de la inferencia de IA debe diseñarse desde cero. Proviene del hardware y el software que trabajan en sincronía: GPU, redes y código ajustados para evitar cuellos de botella y aprovechar al máximo cada ciclo.

La arquitectura potente sin orquestación inteligente desperdicia potencial; Un gran software sin hardware rápido y de baja latencia significa un rendimiento lento. La clave es diseñar un sistema para que pueda convertir de manera rápida, eficiente y flexible las indicaciones en respuestas útiles.

Las empresas pueden usar la infraestructura de NVIDIA para crear un sistema que ofrezca un rendimiento óptimo.

Arquitectura Optimizada para la Inferencia a Escala de Fábrica de IA

La plataforma NVIDIA Blackwell desbloquea un aumento de 50 veces en la productividad de la fábrica de IA para la inferencia, lo que significa que las empresas pueden optimizar el rendimiento y la capacidad de respuesta interactiva, incluso cuando ejecutan los modelos más complejos.

El sistema de escala de rack NVIDIA GB200 NVL72 conecta 36 CPU NVIDIA Grace y 72 GPU Blackwell con la interconexión NVIDIA NVLink, lo que ofrece un potencial de ingresos 40 veces mayor, un rendimiento 30 veces mayor, 25 veces más eficiencia energética y 300 veces más eficiencia del agua para cargas de trabajo de razonamiento de IA exigentes.

Además, NVFP4 es un formato de baja precisión que ofrece el máximo rendimiento en NVIDIA Blackwell y reduce las demandas de energía, memoria y ancho de banda sin perder el ritmo de la precisión, por lo que los usuarios pueden realizar más consultas por vatio y reducir los costos por token.

Plataforma de Inferencia de Pila Completa Acelerada en Blackwell

Habilitar la inferencia a escala de fábrica de IA requiere más que una arquitectura acelerada. Requiere una plataforma completa con múltiples capas de soluciones y herramientas que puedan trabajar en conjunto.

Las implementaciones modernas de IA requieren un escalado automático dinámico de una a miles de GPU. La plataforma NVIDIA Dynamo dirige la inferencia distribuida para asignar GPU de forma dinámica y optimizar los flujos de datos, lo que ofrece hasta 4 veces más rendimiento sin aumentos de costos. Las nuevas integraciones en la nube mejoran aún más la escalabilidad y la facilidad de implementación.

Para las cargas de trabajo de inferencia centradas en obtener un rendimiento óptimo por GPU, como acelerar una gran combinación de modelos expertos, los marcos como NVIDIA TensorRT-LLM están ayudando a los desarrolladores a lograr un rendimiento innovador.

Con su nuevo flujo de trabajo centrado en PyTorch, TensorRT-LLM agiliza la implementación de IA al eliminar la necesidad de administración manual del motor. Estas soluciones no solo son poderosas por sí solas, sino que están diseñadas para funcionar en conjunto. Por ejemplo, con Dynamo y TensorRT-LLM, los proveedores de inferencia de misión crítica como Baseten pueden ofrecer inmediatamente un rendimiento de modelo de última generación incluso en nuevos modelos de frontera como gpt-oss.

En el lado del modelo, familias como NVIDIA Nemotron están construidas con datos de entrenamiento abiertos para mayor transparencia, al tiempo que generan tokens lo suficientemente rápido como para manejar tareas de razonamiento avanzadas con alta precisión, sin aumentar los costos de cómputo. Y con NVIDIA NIM, esos modelos se pueden empaquetar en microservicios listos para ejecutar, lo que facilita que los equipos los implementen y escalen en todos los entornos mientras logran el menor costo total de propiedad.

Juntas, estas capas (orquestación dinámica, ejecución optimizada, modelos bien diseñados e implementación simplificada) forman la columna vertebral de la habilitación de inferencia tanto para los proveedores de la nube como para las empresas.

Retorno de la Inversión Impulsado por el Rendimiento

A medida que crece la adopción de la IA, las organizaciones buscan cada vez más maximizar el retorno de la inversión de cada consulta de usuario.

El rendimiento es el mayor impulsor del retorno de la inversión. Un aumento de 4 veces en el rendimiento de la arquitectura NVIDIA Hopper a Blackwell produce un crecimiento de ganancias de hasta 10 veces dentro de un presupuesto de energía similar.

En los centros de datos de potencia limitada y las fábricas de IA, generar más tokens por vatio se traduce directamente en mayores ingresos por rack. Administrar el rendimiento de tokens de manera eficiente, equilibrando la latencia, la precisión y la carga de usuarios, es crucial para mantener bajos los costos.

La industria está viendo rápidas mejoras en los costos, llegando incluso a reducir costos por millón de tokens en un 80% a través de optimizaciones en toda la pila. Las mismas ganancias se pueden lograr corriendo GPT-OSS y otros modelos de código abierto del ecosistema de inferencia de NVIDIA, ya sea en centros de datos de hiperescala o en PC de IA locales.

Ecosistema Tecnológico y Base Instalada

A medida que avanzan los modelos, con ventanas de contexto más largas, más tokens y comportamientos de tiempo de ejecución más sofisticados, su rendimiento de inferencia escala.

Los modelos abiertos son una fuerza impulsora en este impulso, acelerando más del 70% de las cargas de trabajo de inferencia de IA en la actualidad. Permiten tanto a las nuevas empresas como a las empresas crear agentes personalizados, copilotos y aplicaciones en todos los sectores.

Las comunidades de código abierto desempeñan un papel fundamental en el ecosistema de IA generativa, fomentando la colaboración, acelerando la innovación y democratizando el acceso. NVIDIA tiene más de 1,000 proyectos de código abierto en GitHub, además de 450 modelos y más de 80 conjuntos de datos en Hugging Face. Estos ayudan a integrar marcos populares como JAX, PyTorch, vLLM y TensorRT-LLM en la plataforma de inferencia de NVIDIA, lo que garantiza el máximo rendimiento y flexibilidad de inferencia en todas las configuraciones.

Es por eso que NVIDIA continúa contribuyendo al código abierto proyectos como LLM-D y colabora con líderes de la industria en modelos abiertos, incluidos Llama, Google Gemma, NVIDIA Nemotron, DeepSeek y GPT-OSS, ayudando a llevar las aplicaciones de IA de la idea a la producción a una velocidad sin precedentes.

El Resultado Final para una Inferencia Optimizada

La plataforma de inferencia de NVIDIA, junto con el marco Think SMART para implementar cargas de trabajo de IA modernas, ayuda a las empresas a garantizar que su infraestructura pueda seguir el ritmo de las demandas de los modelos que avanzan rápidamente, y que cada token generado ofrezca el máximo valor.

Obtenga más información sobre cómo la inferencia impulsa el potencial de generación de ingresos de las fábricas de IA.

Para obtener actualizaciones mensuales, suscríbase al boletín NVIDIA Think SMART.