La computación acelerada , una capacidad que alguna vez se limitó a las computadoras de alto rendimiento en los laboratorios de investigación del gobierno, se ha generalizado.

Los bancos, los fabricantes de automóviles, las fábricas, los hospitales, los minoristas y otros están adoptando supercomputadoras de inteligencia artificial para abordar las crecientes montañas de datos que necesitan procesar y comprender.

Estos sistemas potentes y eficientes son supercarreteras de la informática. Transportan datos y cálculos a través de rutas paralelas en un viaje relámpago hacia resultados procesables.

Los procesadores GPU y CPU son los recursos a lo largo del camino, y sus rampas de acceso son interconexiones rápidas. El estándar de oro en interconexiones para computación acelerada es NVLink .

Entonces, ¿qué es NVLink?

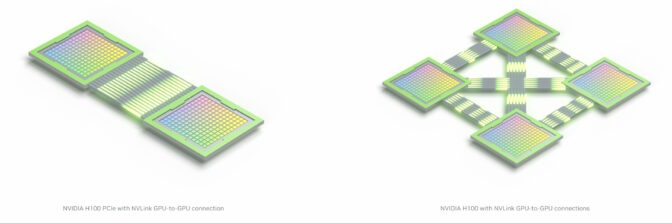

NVLink es una conexión de alta velocidad para GPU y CPU formada por un protocolo de software robusto, que normalmente se monta en varios pares de cables impresos en una placa de computadora. Permite que los procesadores envíen y reciban datos de grupos de memoria compartidos a la velocidad de la luz.

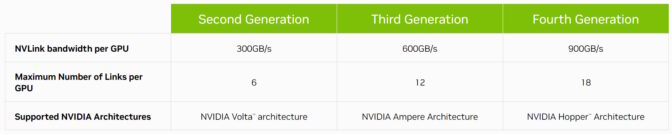

Ahora en su cuarta generación, NVLink conecta host y procesadores acelerados a velocidades de hasta 900 gigabytes por segundo (GB/s).

Eso es más de 7 veces el ancho de banda de PCIe Gen 5, la interconexión utilizada en los servidores x86 convencionales. Y NVLink tiene una eficiencia energética 5 veces superior a PCIe Gen 5, gracias a las transferencias de datos que consumen solo 1,3 picojulios por bit.

La historia de NVLink

Presentado por primera vez como una interconexión de GPU con la GPU NVIDIA P100, NVLink ha avanzado a la par con cada nueva arquitectura de GPU NVIDIA.

En 2018, NVLink saltó a la fama en la informática de alto rendimiento cuando debutó conectando GPU y CPU en dos de las supercomputadoras más poderosas del mundo, Summit y Sierra .

Los sistemas, instalados en los Laboratorios Nacionales Oak Ridge y Lawrence Livermore, están ampliando los límites de la ciencia en campos como el descubrimiento de fármacos , la predicción de desastres naturales y más.

El ancho de banda se duplica y luego vuelve a crecer

En 2020, NVLink de tercera generación duplicó su ancho de banda máximo por GPU a 600 GB/s, con una docena de interconexiones en cada GPU NVIDIA A100 Tensor Core .

El A100 impulsa las supercomputadoras de IA en centros de datos empresariales, servicios de computación en la nube y laboratorios de HPC en todo el mundo.

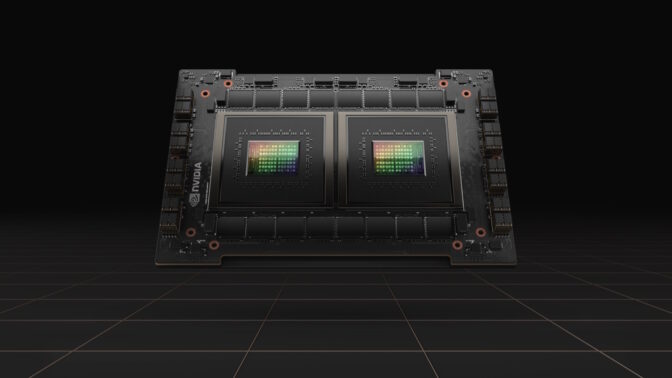

Actualmente, 18 interconexiones NVLink de cuarta generación están integradas en una sola GPU NVIDIA H100 Tensor Core . Y la tecnología ha asumido un nuevo rol estratégico que habilitará las CPU y aceleradores más avanzados del planeta.

El enlace de chip a chip

NVIDIA NVLink-C2C es una versión de la interconexión a nivel de placa para unir dos procesadores dentro de un solo paquete, creando un superchip. Por ejemplo, conecta dos chips de CPU para ofrecer 144 núcleos Arm Neoverse V2 en NVIDIA Grace CPU Superchip, un procesador diseñado para ofrecer un rendimiento energéticamente eficiente para usuarios de la nube, empresas y HPC.

NVIDIA NVLink-C2C también une una CPU Grace y una GPU Hopper para crear el Superchip Grace Hopper . Incluye computación acelerada para los trabajos de IA y HPC más difíciles del mundo en un solo chip.

Alps , una supercomputadora de inteligencia artificial planificada para el Centro Nacional de Computación de Suiza, estará entre las primeras en usar Grace Hopper. Cuando entre en funcionamiento a finales de este año, el sistema de alto rendimiento funcionará en grandes problemas científicos en campos que van desde la astrofísica hasta la química cuántica.

Grace y Grace Hopper también son excelentes para llevar la eficiencia energética a las exigentes workloads de computación en el cloud.

Por ejemplo, Grace Hopper es un procesador ideal para sistemas de recomendación . Estos motores económicos de Internet necesitan un acceso rápido y eficiente a una gran cantidad de datos para brindar billones de resultados a miles de millones de usuarios diariamente.

Además, NVLink se utiliza en un potente sistema en chip para fabricantes de automóviles que incluye procesadores NVIDIA Hopper, Grace y Ada Lovelace. NVIDIA DRIVE Thor es una computadora para automóvil que unifica funciones inteligentes como el grupo de instrumentos digitales, el infoentretenimiento, la conducción automatizada, el estacionamiento y más en una sola arquitectura.

Enlaces LEGO de Computación

NVLink también actúa como el enchufe estampado en una pieza de LEGO. Es la base para construir supersistemas para abordar los trabajos más grandes de HPC e IA.

Por ejemplo, NVLinks en las ocho GPU en un sistema NVIDIA DGX comparten conexiones rápidas y directas a través de chips NVSwitch. Juntos, habilitan una red NVLink donde cada GPU en el servidor es parte de un solo sistema.

Para obtener aún más rendimiento, los sistemas DGX se pueden apilar en unidades modulares de 32 servidores, creando un clúster informático potente y eficiente .

Los usuarios pueden conectar un bloque modular de 32 sistemas DGX en una sola supercomputadora de IA mediante una combinación de una red NVLink dentro del DGX y NVIDIA Quantum-2 Switched Infiniband entre ellos. Por ejemplo, un NVIDIA DGX H100 SuperPOD incluye 256 GPU H100 para ofrecer hasta un exaflop de rendimiento máximo de IA.

Para obtener aún más rendimiento, los usuarios pueden aprovechar las supercomputadoras de IA en la nube, como la que Microsoft Azure está construyendo con decenas de miles de GPU A100 y H100 . Es un servicio utilizado por grupos como OpenAI para entrenar algunos de los modelos de IA generativa más grandes del mundo.

Y es un ejemplo más del poder de la computación acelerada.