La computación acelerada trabaja en segundo plano, para mejorar la vida incluso en una noche tranquila en casa.

Evita el fraude con tarjetas de crédito cuando compras una película para transmitir. Recomienda una cena que te guste y organiza una entrega rápida. Tal vez incluso ayudó al director de la película a ganar un Óscar por sus impresionantes imágenes.

Entonces, ¿Qué Es la Computación Acelerada?

La computación acelerada es el uso de hardware especializado para acelerar enormemente el trabajo, a menudo con procesamiento paralelo que agrupa tareas que ocurren con frecuencia. Descarga el trabajo exigente que puede atascar las CPU, los procesadores que normalmente ejecutan tareas en serie.

Nacida en el PC, la computación acelerada llegó a la mayoría de edad en las supercomputadoras. Vive hoy en tu teléfono inteligente y en todos los servicios del cloud. Y, ahora, las empresas de todo tipo la están adoptando para transformar sus negocios con datos.

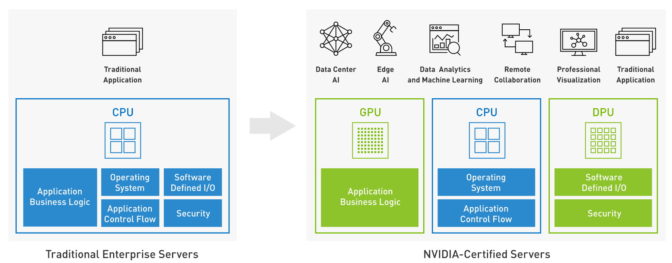

Las computadoras aceleradas combinan las CPU y otros tipos de procesadores como iguales en una arquitectura a veces llamada computación heterogénea.

Computadoras Aceleradas: Una Mirada detrás de Bambalinas

Las GPU son los aceleradores más utilizados. Las unidades de procesamiento de datos (DPU) son una clase que emerge rápidamente y permite una red mejorada y acelerada. Cada una tiene un papel que desempeñar junto con la CPU del host para crear un sistema unificado y equilibrado.

Hoy en día, tanto los sistemas comerciales como los técnicos adoptan la computación acelerada para manejar trabajos como el machine learning, el análisis de datos, las simulaciones y las visualizaciones. Es un estilo moderno de computación que ofrece un alto rendimiento y eficiencia energética.

Cómo las PC Popularizaron la Computación Acelerada

El hardware especializado llamado coprocesadores ha aparecido durante mucho tiempo en las computadoras para acelerar el trabajo de una CPU host. Primero ganaron prominencia alrededor de 1980 con procesadores de punto flotante que agregaron capacidades matemáticas avanzadas a la PC.

Durante la siguiente década, el auge de los videojuegos y las interfaces gráficas de usuario creó una demanda de aceleradores gráficos. En 1993, casi 50 compañías fabricaban chips o tarjetas gráficas.

En 1999, NVIDIA lanzó la GeForce 256, el primer chip en descargar de la CPU tareas clave para renderizar imágenes 3D. También fue el primero en utilizar cuatro procesos gráficos para el procesamiento paralelo.

NVIDIA lo llamó una unidad de procesamiento de gráficos (GPU), apostando a una nueva categoría de aceleradores de computadoras.

Cómo los Investigadores Aprovecharon el Procesamiento Paralelo

Para 2006, NVIDIA había vendido 500 millones de GPU. Lideraba un campo de solo tres proveedores de gráficos y detectó el siguiente gran hito en el horizonte.

Algunos investigadores ya estaban desarrollando su propio código para aplicar el poder de las GPU a tareas fuera del alcance de las CPU. Por ejemplo, un equipo de Stanford dirigido por Ian Buck dio a conocer Brook, el primer modelo de programación ampliamente adoptado para extender el popular lenguaje C para el procesamiento paralelo.

Buck comenzó en NVIDIA como pasante y ahora se desempeña como vicepresidente de computación acelerada. En 2006, lideró el lanzamiento de CUDA, un modelo de programación para aprovechar los motores de procesamiento paralelo dentro de la GPU para cualquier tarea.

Junto con un procesador G80 en 2007, CUDA impulsó una nueva línea de las GPU de NVIDIA que llevó la computación acelerada a una gama cada vez mayor de aplicaciones industriales y científicas.

HPC + GPU = Ciencia Acelerada

Esta familia de GPU destinadas al data center se expandió con una cadencia regular gracias una sucesión de nuevas arquitecturas que llevan el nombre de innovadores: Tesla, Fermi, Kepler, Maxwell, Pascal, Volta, Turing, Ampere.

Al igual que los aceleradores gráficos de la década de 1990, estas nuevas GPU se enfrentaron a muchos rivales, incluidos nuevos procesadores paralelos como el transputer de Inmos.

“Pero solo la GPU sobrevivió porque los demás no tenían un ecosistema de software y esa fue su sentencia de muerte”, dijo Kevin Krewell, analista de Tirias Research.

Expertos en computación de alto rendimiento de todo el mundo construyeron sistemas HPC acelerados con GPU para ser pioneros en la ciencia. Su trabajo hoy en día abarca campos desde la astrofísica de los agujeros negros hasta la secuenciación del genoma y más allá.

De hecho, El Laboratorio Nacional de Oak Ridge incluso publicó una guía de computación acelerada para usuarios de HPC.

Redes Aceleradas de InfiniBand Revs

Muchas de estas supercomputadoras utilizan InfiniBand, un vínculo rápido y de baja latencia ideal para crear grandes redes distribuidas de GPU. Al ver la importancia de las redes aceleradas, NVIDIA adquirió Mellanox, un pionero de InfiniBand, en abril de 2020.

Apenas seis meses después, NVIDIA anunció su primera DPU, un procesador de datos que define un nuevo nivel de seguridad, almacenamiento y aceleración de red. Una hoja de ruta de las DPU bluefield ya está ganando terreno en supercomputadoras, servicios de cloud, sistemas OEM y software de terceros.

Para junio de 2021, 342 de las supercomputadoras TOP500 más rápidas del mundo utilizaban tecnologías de NVIDIA, incluido el 70 por ciento de todos los sistemas nuevos y ocho de los 10 sistemas principales.

Hasta la fecha, el ecosistema CUDA ha generado más de 700 aplicaciones aceleradas y abordó grandes desafíos como el descubrimiento de fármacos, la respuesta a desastres e incluso los planes para misiones a Marte.

Mientras tanto, la computación acelerada también permitió el siguiente gran salto en los gráficos. En 2018, la arquitectura Turing de NVIDIA impulsó las GPU GeForce RTX, las primeras en ofrecer ray tracing, el santo grial de la tecnología visual, para brindarles a los games y las simulaciones un realismo realista.

IA, una Aplicación Increíble para la Computación Acelerada

En 2012, el mundo de la tecnología escuchó un Big Bang, que señalaba que había llegado una nueva y poderosa forma de computación, la IA.

Detrás de bambalinas, es un trabajo de procesamiento en paralelo. Por lo tanto, desde los primeros días de deep learning, los investigadores y los proveedores de servicios de cloud comenzaron a usar computadoras aceleradas por GPU para entrenar y ejecutar sus redes neuronales.

Las empresas líderes en todos los mercados específicos vieron rápidamente la importancia de la IA en las computadoras aceleradas.

- American Express lo utiliza para prevenir el fraude con tarjetas de crédito.

- Los servicios de cloud lo utilizan en sistemas de recomendación que impulsan las ventas.

- Muchas empresas utilizan la IA conversacional para mejorar el servicio al cliente.

- Las empresas de telecomunicaciones están explorando la IA para ofrecer servicios 5G inteligentes.

- Los cineastas la usaron para hacer que Robert DeNiro y Al Pacino parecieran más jóvenes en The Irishman.

- Y puedes verla en acción con las comidas sugeridas y entregadas de DoorDash o Domino’s.

Algún día, cada empresa será una empresa de datos, y cada servidor será una computadora acelerada.

Es una visión compartida por los líderes de las principales compañías de software de TI como VMware y Red Hat, que están adaptando sus productos para la computación acelerada. Los fabricantes de sistemas ya están entregando docenas de Sistemas Certificados por NVIDIA, computadoras aceleradas listas para trabajar para todas las empresas.

Son vehículos para el viaje hacia la computación acelerada en la empresa. Para ayudar a pavimentar la línea de acceso, NVIDIA está entregando una solución de pila completa con productos como NVIDIA AI Enterprise, Base Command, Fleet Command y aplicaciones aceleradas listas para usar en el catálogo NGC.

Un Futuro Energéticamente Eficiente

La computación acelerada “es el único camino a seguir”, según veteranos de la computación como John Hennessey y David Patterson. Describieron la tendencia como un movimiento hacia «arquitecturas específicas del dominio» en una charla conmemorativa de su premio Turing 2017, el equivalente a el Nobel en computación.

La eficiencia energética del enfoque es una razón importante por la que representa el futuro. Por ejemplo, las GPU ofrecen una eficiencia energética 42 veces mejor en la inferencia de IA que las CPU.

De hecho, si cambiara todos los servidores solo de CPU que ejecutan IA en todo el mundo a sistemas acelerados por GPU, podría ahorrar la friolera de 10 billones de vatios-hora de energía al año. Eso es como ahorrar la energía que consumen 1.4 millones de hogares en un año.

Los expertos en computación acelerada ya están cosechando estos beneficios.

Treinta y cinco de los 40 mejores sistemas en la lista Green500 de las supercomputadoras más eficientes energéticamente del mundo se ejecutan en tecnologías de NVIDIA, incluidos nueve de los 10 sistemas principales. Las supercomputadoras en la lista que usan las GPU de NVIDIA son 3.5 veces más eficientes energéticamente que las que no lo hacen, una tendencia constante y creciente.

Para obtener más información, mira un ejemplo de charlas sobre computación acelerada de GTC y el video sobre la computación acelerada empresarial que se encuentra a continuación.