Todo el mundo quiere una computación verde.

Los usuarios móviles exigen el máximo rendimiento y duración de la batería. Las empresas y los gobiernos requieren cada vez más sistemas que sean potentes y respetuosos con el medio ambiente. Y los servicios en la nube deben responder a las demandas globales sin hacer que la red tartamudee.

Por estas y otras razones, la computación verde ha evolucionado rápidamente en las últimas tres décadas, y ha llegado para quedarse.

¿Qué Es la Computación Verde?

La computación verde, o computación sostenible, es la práctica de maximizar la eficiencia energética y minimizar el impacto ambiental en la forma en que se diseñan y utilizan los chips, sistemas y software de las computadoras.

También llamada tecnología de la información verde, TI verde o TI sostenible, la computación verde abarca preocupaciones en toda la cadena de suministro, desde las materias primas utilizadas para fabricar computadoras hasta cómo se reciclan los sistemas.

En su vida laboral, las computadoras ecológicas deben entregar la mayor cantidad de trabajo con la menor cantidad de energía, generalmente medida por el rendimiento por vatio.

¿Por Qué Es Importante la Computación Verde?

La computación verde es una herramienta importante para combatir el cambio climático, la amenaza existencial de nuestro tiempo.

Las temperaturas globales han aumentado alrededor de 1,2 °C en el último siglo. Como resultado, los casquetes polares se están derritiendo, lo que hace que el nivel del mar suba unos 20 centímetros y aumente el número y la gravedad de los fenómenos meteorológicos extremos.

El creciente uso de la electricidad es una de las causas del calentamiento global. Los data centers representan una pequeña fracción del uso total de electricidad, alrededor del 1% o 200 teravatios-hora por año, pero son un factor creciente que exige atención.

Los ordenadores potentes y energéticamente eficientes son parte de la solución. Están haciendo avanzar la ciencia y nuestra calidad de vida, incluidas las formas en que entendemos y respondemos al cambio climático.

¿Cuáles Son los Elementos de la Computación Verde?

Los ingenieros saben que la computación verde es una disciplina holística.

«La eficiencia energética es un problema de pila completa, desde el software hasta los chips», dijo Sachin Idgunji, copresidente del grupo de trabajo de energía para el punto de referencia de IA MLPerf de la industria y un distinguido ingeniero que trabaja en el análisis de rendimiento en NVIDIA.

Por ejemplo, en un análisis, descubrió que los sistemas NVIDIA DGX A100 ofrecían una mejora de casi 5 veces en la eficiencia energética en los puntos de referencia de entrenamiento de IA escalables en comparación con la generación anterior.

«Mi función principal es analizar y mejorar la eficiencia energética de las aplicaciones de IA en todo, desde la GPU y el nodo del sistema hasta la escala completa del data center», dijo.

El trabajo de Idgunji es una descripción de trabajo para un creciente grupo de ingenieros que construyen productos, desde teléfonos inteligentes hasta supercomputadoras.

¿Cuál Es la Historia de la Computación Verde?

La computación verde saltó a la luz pública en 1992, cuando la Agencia de Protección Ambiental de Estados Unidos (EPA, por sus siglas en inglés) lanzó Energy Star, un programa para identificar productos electrónicos de consumo que cumplieran con los estándares de eficiencia energética.

Un informe de 2017 encontró que casi 100 programas gubernamentales e industriales en 22 países promovían lo que llamó TIC verdes, tecnologías de la información y la comunicación sostenibles.

Una de estas organizaciones, el Green Electronics Council, proporciona la Herramienta de Evaluación Ambiental de Productos Electrónicos, un registro de sistemas y sus niveles de eficiencia energética. El ayuntamiento afirma que ha ahorrado casi 400 millones de megavatios-hora de electricidad mediante el uso de 1.500 millones de productos ecológicos que ha recomendado hasta la fecha.

El trabajo en computación verde continúa en toda la industria en todos los niveles.

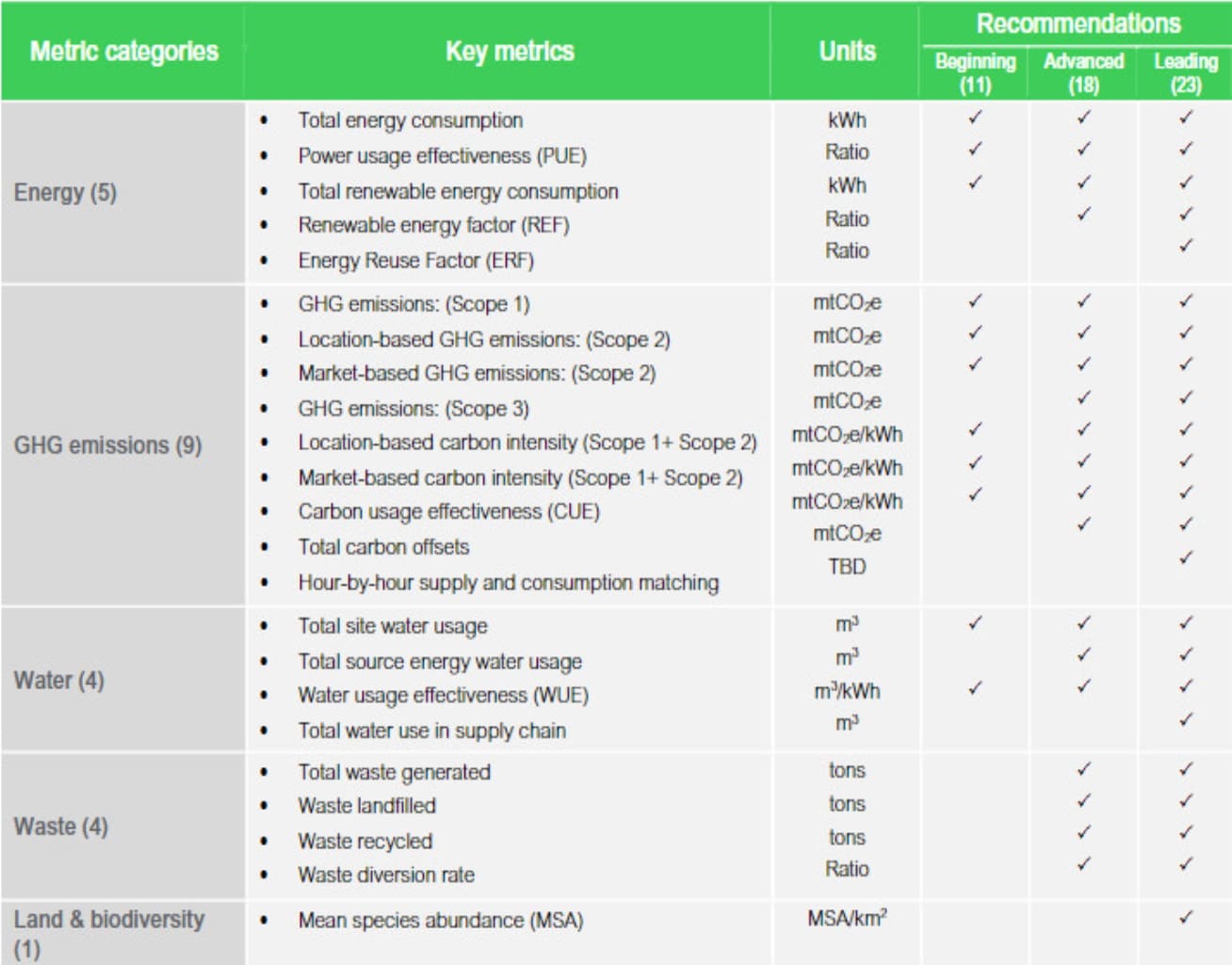

Por ejemplo, algunos grandes data centers utilizan refrigeración líquida, mientras que otros ubican data centers donde pueden utilizar aire ambiente frío. Schneider Electric publicó recientemente un documento técnico en el que recomienda 23 métricas para determinar el nivel de sostenibilidad de los data centers.

Pionero en Eficiencia Energética

Wu Feng, profesor de ciencias de la computación en Virginia Tech, construyó una carrera empujando los límites de la computación verde. Comenzó por necesidad mientras trabajaba en el Laboratorio Nacional de Los Álamos.

Un clúster de computación para la investigación en ciencia abierta que mantenía en un almacén externo tenía el doble de fallos en verano que en invierno. Por lo tanto, construyó un sistema de menor potencia que no generaría tanto calor.

Hizo una demostración del sistema, denominado Green Destiny, en la conferencia Supercomputing de 2001. Cubierto por la BBC, CNN y el New York Times, entre otros, provocó años de charlas y debates en la comunidad de HPC sobre la fiabilidad potencial y la eficiencia de la computación ecológica.

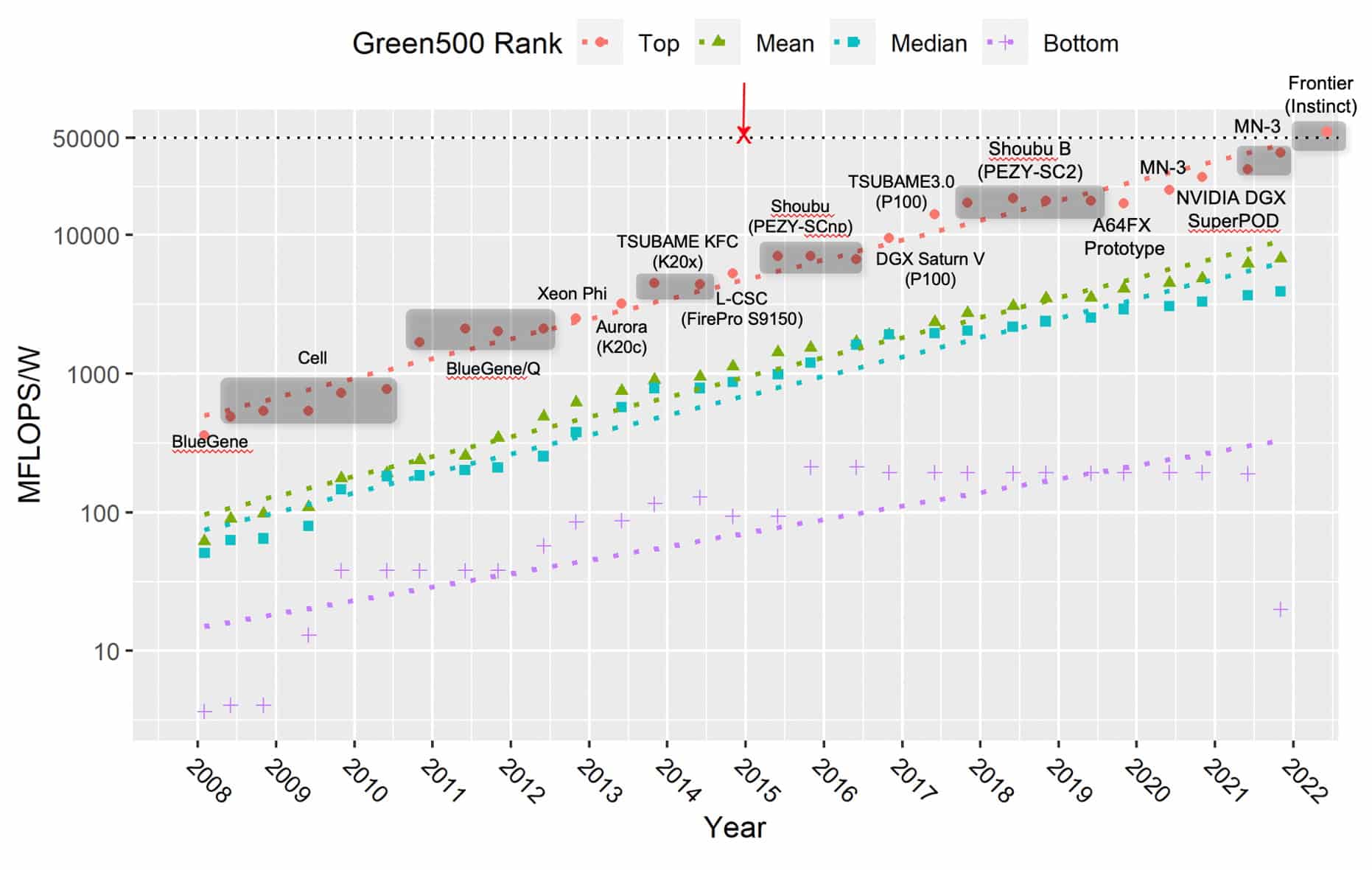

El interés aumentó a medida que crecían las supercomputadoras y los centros de datos, superando sus límites en el consumo de energía. En noviembre de 2007, después de trabajar con unas 30 luminarias de HPC y recopilar comentarios de la comunidad, Feng lanzó la primera lista Green500, el punto de referencia de la industria para la supercomputación energéticamente eficiente.

Un Punto de Referencia de la Computación Ecológica

El Green500 se convirtió en un punto de reunión para una comunidad que necesitaba controlar el consumo de energía y, al mismo tiempo, llevar el rendimiento a nuevas alturas.

«La eficiencia energética aumentó exponencialmente, los fracasos por vatio se duplicaron aproximadamente cada año y medio para la supercomputadora más ecológica en la parte superior de la lista», dijo Feng.

Según algunas mediciones, los resultados mostraron que la eficiencia energética de los sistemas más ecológicos del mundo aumentó dos órdenes de magnitud en los últimos 14 años.

Feng atribuye las ganancias principalmente al uso de aceleradores como las GPU, ahora comunes entre los sistemas más rápidos del mundo.

«Los aceleradores agregaron la capacidad de ejecutar código de una manera masivamente paralela sin mucha sobrecarga, nos permitieron correr increíblemente rápido», dijo.

Citó dos generaciones de supercomputadoras Tsubame en Japón como ejemplos tempranos. Utilizaron GPU de arquitectura NVIDIA Kepler y Pascal para liderar la lista Green500 en 2014 y 2017, parte de una procesión de sistemas acelerados por GPU en la lista.

«Los aceleradores han tenido un gran impacto en toda la lista», dijo Feng, quien recibirá un premio por su trabajo de supercomputación verde en el evento Supercomputing en noviembre.

«En particular, NVIDIA fue fantástica en su compromiso y apoyo al Green500 al garantizar que se informaran sus cifras de eficiencia energética, ayudando así a que la eficiencia energética se convirtiera en un ciudadano de primera clase en la forma en que se diseñan las supercomputadoras hoy en día», agregó.

La IA y las Redes Se Vuelven Más Eficientes

Hoy en día, las GPU y las unidades de procesamiento de datos (DPU) están aportando una mayor eficiencia energética a las tareas de IA y redes, así como a los trabajos de HPC, como las simulaciones que se ejecutan en superordenadores y centros de datos empresariales.

La IA, la tecnología más poderosa de nuestro tiempo, se convertirá en parte de todos los negocios. McKinsey & Co. estima que la IA añadirá la asombrosa cifra de 13 billones de dólares al PIB mundial en 2030 a medida que crezcan los despliegues.

NVIDIA estima que los centros de datos podrían ahorrar la friolera de 19 teravatios-hora de electricidad al año si todas las descargas de IA, HPC y redes se ejecutaran en aceleradores de GPU y DPU (consulte los gráficos a continuación). Eso equivale al consumo de energía de 2,9 millones de turismos conducidos durante un año.

Es una medida sorprendente del potencial de eficiencia energética con la computación acelerada.

AI Benchmark Mide la Eficiencia

Debido a que la IA representa una parte cada vez mayor de las cargas de trabajo empresariales, los puntos de referencia de la industria MLPerf para la IA han estado midiendo el rendimiento por vatio en los envíos para la inferencia del data center y el edge desde febrero de 2021.

«La próxima frontera para nosotros es medir la eficiencia energética de la IA en sistemas distribuidos más grandes, para las cargas de trabajo de HPC y para el entrenamiento de la IA, es similar al trabajo de Green500», dijo Idgunji, cuyo grupo de energía en MLPerf incluye miembros de otras seis compañías de chips y sistemas.

Los resultados públicos motivan a los participantes a realizar mejoras significativas con cada generación de productos. También ayudan a los ingenieros y desarrolladores a comprender las formas de equilibrar el rendimiento y la eficiencia en las principales cargas de trabajo de IA que prueba MLPerf.

«Las optimizaciones de software son una gran parte del trabajo porque pueden generar grandes impactos en la eficiencia energética, y si su sistema es energéticamente eficiente, también es más confiable», dijo Idgunji.

Computación Ecológica para los Consumidores

En PC y laptops, «hemos estado invirtiendo en eficiencia durante mucho tiempo porque es lo correcto», dijo Narayan Kulshrestha, un arquitecto de potencia de GPU en NVIDIA que ha estado trabajando en el campo durante casi dos décadas.

Por ejemplo, Dynamic Boost 2.0 utiliza el deep learning para dirigir automáticamente la energía a una CPU, una GPU o la memoria de una GPU para aumentar la eficiencia del sistema. Además, NVIDIA creó un diseño a nivel de sistema para portátiles, llamado Max-Q, para optimizar y equilibrar la eficiencia energética y el rendimiento.

Construir Una Economía Cíclica

Cuando un usuario reemplaza un sistema, la práctica estándar en la computación verde es que el sistema antiguo se descompone y se recicla. Pero Matt Hull ve mejores posibilidades.

«Nuestra visión es una economía cíclica que permita a todos con IA a una variedad de precios», dijo Hull, vicepresidente de ventas de productos de IA para data center de NVIDIA.

Por lo tanto, su objetivo es encontrar un nuevo hogar para los usuarios de los países en desarrollo que lo encuentren útil y asequible. Es un trabajo en progreso que busca el socio adecuado y escribe un nuevo capítulo en un proceso de gestión del ciclo de vida existente.

La Computación Verde Lucha Contra el Cambio Climático

Las computadoras de bajo consumo se encuentran entre las herramientas más afiladas para combatir el cambio climático.

Los científicos de los laboratorios gubernamentales y las universidades han utilizado durante mucho tiempo las GPU para modelar escenarios climáticos y predecir patrones meteorológicos. Los avances recientes en IA, impulsados por las GPU NVIDIA, ahora pueden ayudar a modelar el pronóstico del tiempo 100,000 veces más rápido que los modelos tradicionales. Mire el siguiente video para obtener más detalles:

En un esfuerzo por acelerar la ciencia del clima, NVIDIA anunció planes para construir Earth-2, una supercomputadora de IA dedicada a predecir los impactos del cambio climático. Utilizará NVIDIA Omniverse, una plataforma de colaboración y simulación de diseño 3D, para construir un gemelo digital de la Tierra para que los científicos puedan modelar climas en resolución ultra alta.

Además, NVIDIA está trabajando con el Centro de Satélites de las Naciones Unidas para acelerar la gestión de desastres climáticos y capacitar a científicos de datos de todo el mundo en el uso de IA para mejorar la detección de inundaciones.

Mientras tanto, las empresas de servicios públicos están adoptando el machine learning para avanzar hacia una red verde, resiliente e inteligente. Las centrales eléctricas están utilizando gemelos digitales para predecir el costoso mantenimiento y modelar nuevas fuentes de energía, como los diseños de reactores de fusión.

¿Qué Nos Depara el Futuro de la Computación Verde?

Feng ve que la tecnología central detrás de la computación verde avanza en múltiples frentes.

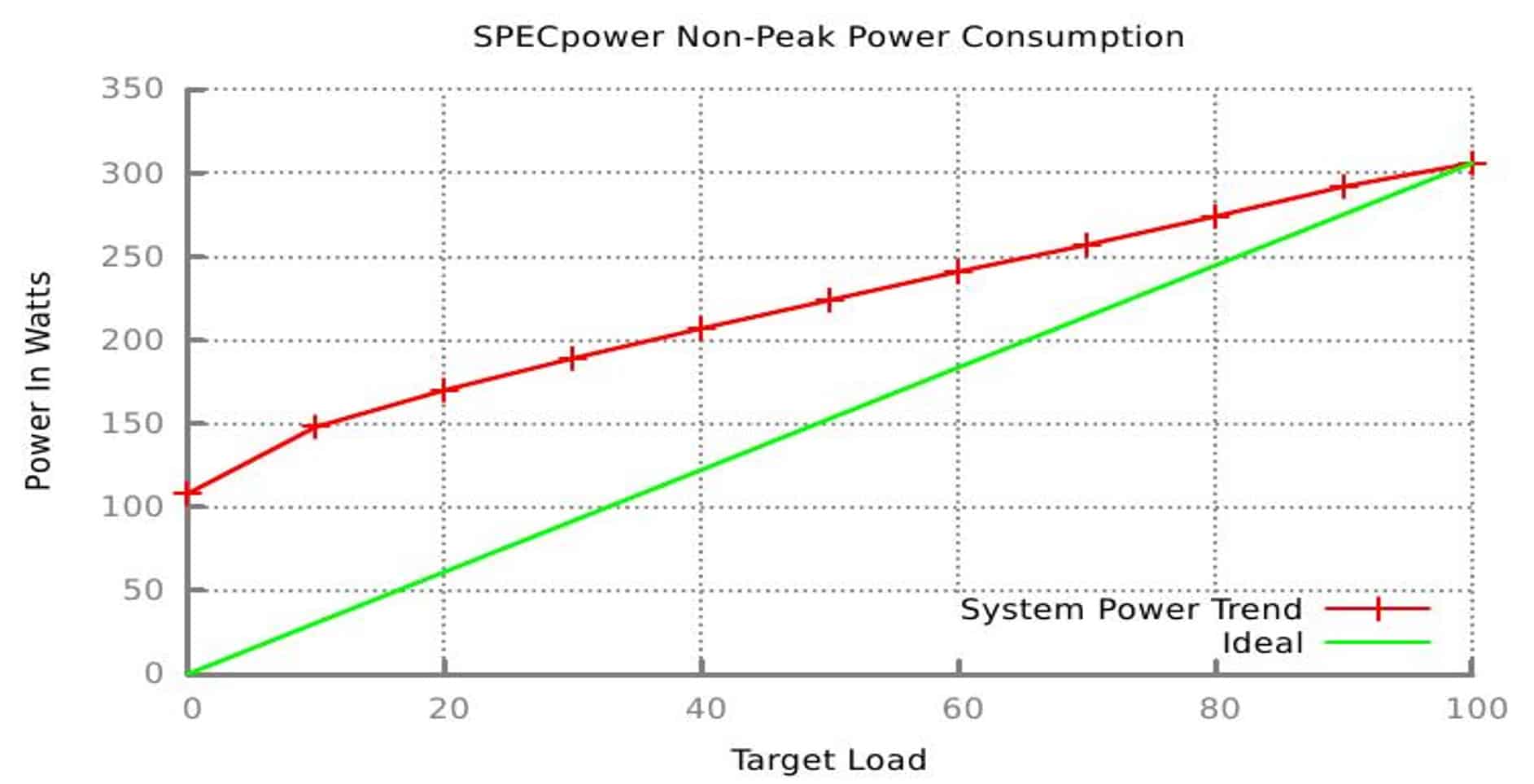

A corto plazo, está trabajando en lo que se llama proporcionalidad de la energía, es decir, formas de asegurarse de que los sistemas obtengan la máxima potencia cuando necesitan el máximo rendimiento y se reduzcan con gracia a cero potencia a medida que disminuyen la velocidad al ralentí, como el motor de un automóvil moderno que reduce la velocidad de sus RPM y luego se apaga en un semáforo en rojo.

A largo plazo, está explorando formas de minimizar el movimiento de datos dentro y entre los chips de las computadoras para reducir su consumo de energía. Y es uno de los muchos investigadores que estudian la promesa de la computación cuántica para ofrecer nuevos tipos de aceleración.

Todo forma parte del trabajo continuo de la computación ecológica, que ofrece un rendimiento cada vez mayor con una eficiencia cada vez mayor.

Descubra cómo la IA está impulsando el futuro de la energía limpia.