Los bancos utilizan la IA para determinar si deben extender el crédito, y a cuánto, a los clientes. Los departamentos de radiología implementan la IA para ayudar a distinguir entre tejido sano y tumores. Y los equipos de recursos humanos la emplean para averiguar cuál de los cientos de CV debe enviarse a los reclutadores.

Estos son solo algunos ejemplos de cómo se está adoptando la IA en todas las industrias. Y, con tanto en juego, las empresas y los gobiernos que adoptan la IA y machine learning reciben cada vez más presiones para mostrar cómo sus modelos de IA toman decisiones.

Charles Elkan, director general de Goldman Sachs, ofrece una clara analogía con gran parte del estado actual de la IA, en la que las organizaciones debaten su fiabilidad y cómo superar las objeciones a los sistemas de IA:

No entendemos exactamente cómo un perro que huele bombas hace su trabajo, pero confiamos mucho en las decisiones que toman.

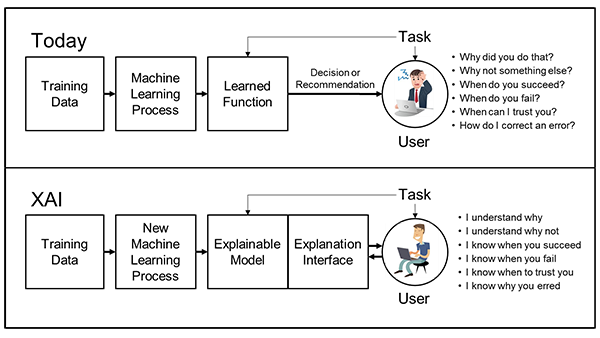

Para llegar a una mejor comprensión de cómo los modelos de IA llegan a sus decisiones, las organizaciones están recurriendo a la inteligencia artificial (IA) explicable.

¿Qué Es la IA Explicable?

La IA explicable, también abreviada como XAI, es un conjunto de herramientas y técnicas utilizadas por las organizaciones para ayudar a las personas a comprender mejor por qué un modelo toma ciertas decisiones y cómo funciona. La XAI es:

- Un conjunto de procedimientos recomendados: Aprovecha algunos de los mejores procedimientos y reglas que los científicos de datos han estado usando durante años para ayudar a otros a comprender cómo se entrena un modelo. Saber cómo y en qué datos se entrenó un modelo nos ayuda a entender cuándo lo hace y cuándo no tiene sentido usar ese modelo. También arroja luz sobre las fuentes de sesgo a las que el modelo podría haber estado expuesto.

- Un conjunto de principios de diseño: Los investigadores se centran cada vez más en simplificar la construcción de sistemas de IA para que sean inherentemente más fáciles de entender.

- Un conjunto de herramientas: A medida que los sistemas se vuelven más fáciles de entender, los modelos de entrenamiento se pueden refinar aún más incorporando esos aprendizajes en él y ofreciendo esos aprendizajes a otros para su incorporación en sus modelos.

¿Cómo Funciona la AI Explicable?

Si bien todavía hay un gran debate sobre la estandarización de los procesos de la XAI, algunos puntos clave se destacan en todas las industrias que lo implementan:

- ¿A quién tenemos que explicar el modelo?

- ¿Qué tan precisa o exacta es la explicación que necesitamos?

- ¿Necesitamos explicar el modelo general o una decisión en particular?

Los científicos de datos se están centrando en todas estas preguntas, pero la explicabilidad se reduce a lo siguiente: ¿Qué estamos tratando de explicar?

Explicar la calidad del modelo:

- ¿Cómo se entrenó el modelo?

- ¿Qué datos se utilizaron?

- ¿Cómo se midió y mitiga el impacto de cualquier sesgo en los datos de entrenamiento?

Estas preguntas son el equivalente de la ciencia de datos a explicar a qué escuela fue tu cirujano, junto con quiénes fueron sus maestros, qué estudiaron y qué calificaciones obtuvieron. Hacer esto bien tiene más que ver con el proceso y con dejar un registro en papel que con la IA pura, pero es fundamental para establecer la confianza en un modelo.

Si bien explicar la calidad de un modelo suena bastante fácil, es difícil en la práctica, ya que muchas herramientas actualmente no admiten una fuerte recopilación de información. NVIDIA proporciona dicha información sobre sus modelos previamente entrenados. Estos se comparten en el catálogo NGC, un centro de IA optimizada para GPU y SDK y modelos de computación de alto rendimiento que ayudan rápidamente a las empresas a crear sus aplicaciones.

Explicar el modelo general:

Esta es un área activa de investigación, que a veces se llama interpretabilidad del modelo. La mayoría de las explicaciones de los modelos caen en uno de dos campos:

En una técnica a veces llamada “modelado proxy”, se pueden usar modelos más simples y comprensibles, como los árboles de decisión, para describir aproximadamente el modelo de IA más detallado. Estas explicaciones dan un “sentido” del modelo en general, pero el equilibrio entre la aproximación y la simplicidad del modelo proxy sigue siendo más arte que ciencia.

El modelado proxy siempre es una aproximación e, incluso si se aplica bien, puede crear oportunidades para que las decisiones de la vida real sean muy diferentes de lo que se espera de los modelos proxy.

El segundo enfoque es el “diseño para la interpretabilidad”. Esto limita las opciones de diseño y entrenamiento de la red de IA de maneras que intentan ensamblar la red general a partir de partes más pequeñas que obligamos a tener un comportamiento más simple. Esto permite que los modelos sigan siendo eficaces, pero con un comportamiento que es mucho más fácil de explicar.

Sin embargo, esto no es tan fácil como parece, y sacrifica cierto nivel de eficiencia y precisión al eliminar componentes y estructuras de la caja de herramientas del científico de datos. Este enfoque también puede requerir significativamente más potencia computacional.

Por Qué la XAI Explica Mejor las Decisiones Individuales

El área mejor entendida de XAI es la toma de decisiones individuales: por qué una persona no fue aprobada para recibir un préstamo, por ejemplo.

Las técnicas con nombres como LIME y SHAP ofrecen respuestas matemáticas muy literales a esta pregunta, y los resultados de esas matemáticas se pueden presentar a los científicos de datos, gerentes, reguladores y consumidores. Para algunos datos —imágenes, audio y texto— se pueden visualizar resultados similares mediante el uso de la «atención» en los modelos, lo que obliga al propio modelo a mostrar su trabajo.

En el caso de los valores de Shapley utilizados en SHAP, hay algunas pruebas matemáticas de las técnicas subyacentes que son particularmente atractivas basadas en el trabajo de teoría de juegos realizado en la década de 1950. Hay una investigación activa en el uso de estas explicaciones de decisiones individuales para explicar el modelo como un todo, centrándose principalmente en la agrupación en clústeres y forzando varias restricciones de suavidad en las matemáticas subyacentes.

El inconveniente de estas técnicas es que son algo costosas computacionalmente. Además, sin un esfuerzo significativo durante el entrenamiento del modelo, los resultados pueden ser muy sensibles a los valores de datos de entrada. Algunos también argumentan que, debido a que los científicos de datos solo pueden calcular valores aproximados de Shapley, las características atractivas y demostrables de estos números también son solo aproximadas, lo que reduce drásticamente su valor.

Si bien se mantiene un debate saludable, está claro que al mantener una calidad adecuada del modelo, adoptar un método de explicabilidad del modelo que proporcione claridad a los líderes superiores sobre los riesgos involucrados en el modelo y monitorear los resultados reales con explicaciones individuales, los modelos de IA se pueden desarrollar con comportamientos claramente entendidos.

Para ver más de cerca los ejemplos de trabajo de XAI, consulta las charlas presentadas por Wells Fargo y ScotiaBank en NVIDIA GTC21.