La inteligencia artificial, como cualquier tecnología transformadora, es un trabajo en progreso, que crece continuamente en sus capacidades y su impacto social. Las iniciativas de IA confiable reconocen los efectos en el mundo real que la IA puede tener en las personas y la sociedad, y tienen como objetivo canalizar ese poder de manera responsable para lograr un cambio positivo.

¿Qué Es Una IA Confiable?

La IA confiable es un enfoque para el desarrollo de la IA que prioriza la seguridad y la transparencia para quienes interactúan con ella. Los desarrolladores de IA confiable entienden que ningún modelo es perfecto y toman medidas para ayudar a los clientes y al público en general a comprender cómo se construyó la tecnología, sus casos de uso previstos y sus limitaciones.

Además de cumplir con las leyes de privacidad y protección al consumidor, los modelos de IA confiable se prueban para garantizar la seguridad, la protección y la mitigación de sesgos no deseados. También son transparentes, ya que proporcionan información como puntos de referencia de precisión o una descripción del conjunto de datos de entrenamiento, para diversas audiencias, incluidas las autoridades reguladoras, los desarrolladores y los consumidores.

Principios de Una IA Confiable

Los principios de IA confiable son fundamentales para el desarrollo integral de IA de NVIDIA. Tienen un objetivo simple: permitir la confianza y la transparencia en la IA y respaldar el trabajo de socios, clientes y desarrolladores.

Privacidad: Cumplimiento de la Normativa, Protección de Datos

A menudo se describe a la IA como hambrienta de datos. A menudo, cuantos más datos se entrena un algoritmo, más precisas son sus predicciones.

Pero los datos tienen que venir de alguna parte. Para desarrollar una IA confiable, es clave tener en cuenta no solo qué datos están legalmente disponibles para su uso, sino también qué datos son socialmente responsables de usar.

Los desarrolladores de modelos de IA que se basan en datos como la imagen, la voz, el trabajo artístico o los registros de salud de una persona deben evaluar si las personas han dado el consentimiento adecuado para que su información personal se utilice de esta manera.

Para instituciones como hospitales y bancos, la creación de modelos de IA significa equilibrar la responsabilidad de mantener la privacidad de los datos de los pacientes o clientes mientras se entrena un algoritmo sólido. NVIDIA ha creado una tecnología que permite el aprendizaje federado, en la que los investigadores desarrollan modelos de IA entrenados con datos de múltiples instituciones sin que la información confidencial salga de los servidores privados de una empresa.

Los sistemas NVIDIA DGX y el software NVIDIA FLARE han permitido varios proyectos de aprendizaje federado en el área de la salud y en el sector de servicios financieros, lo que facilita la colaboración segura de múltiples proveedores de datos en modelos de IA más precisos y generalizables para el análisis de imágenes médicas y la detección de fraudes.

Seguridad y Protección: Evitar Daños no Intencionados y Amenazas Maliciosas

Una vez implementados, los sistemas de IA tienen un impacto en el mundo real, por lo que es esencial que funcionen según lo previsto para preservar la seguridad del usuario.

La libertad de utilizar algoritmos de IA disponibles públicamente crea inmensas posibilidades para aplicaciones positivas, pero también significa que la tecnología puede utilizarse para fines no previstos.

Para ayudar a mitigar los riesgos, NVIDIA NeMo Guardrails mantiene los modelos de lenguaje de IA en el buen camino al permitir que los desarrolladores empresariales establezcan límites para sus aplicaciones. Las barandillas temáticas garantizan que los chatbots se ciñan a temas específicos. Las barreras de seguridad establecen límites en el idioma y las fuentes de datos que las aplicaciones usan en sus respuestas. Las barreras de seguridad buscan evitar el uso malintencionado de un grande modelo de lenguaje que está conectado a aplicaciones de terceros o interfaces de programación de aplicaciones.

NVIDIA Research está trabajando con el programa SemaFor, dirigido por DARPA, para ayudar a los expertos en análisis forense digital a identificar imágenes generadas por IA. El año pasado, los investigadores publicaron un método novedoso para abordar el sesgo social utilizando ChatGPT. También están creando métodos para la toma de huellas dactilares de avatar, una forma de detectar si alguien está usando una imagen animada por IA de otro individuo sin su consentimiento.

Para proteger los datos y las aplicaciones de IA de las amenazas de seguridad, las GPU NVIDIA H100 y H200 Tensor Core están diseñadas con computación confidencial, lo que garantiza que los datos confidenciales estén protegidos mientras están en uso, ya sea que se implementen en las instalaciones, en la nube o en el edge. La Computación Confidencial de NVIDIA utiliza métodos de seguridad basados en hardware para garantizar que las entidades no autorizadas no puedan ver ni modificar datos o aplicaciones mientras se ejecutan, tradicionalmente un momento en el que los datos quedan vulnerables.

Transparencia: Hacer que la IA Sea Explicable

Para crear un modelo de IA confiable, el algoritmo no puede ser una caja negra: sus creadores, usuarios y partes interesadas deben ser capaces de entender cómo funciona la IA para confiar en sus resultados.

La transparencia en IA es un conjunto de mejores prácticas, herramientas y principios de diseño que ayudan a los usuarios y otras partes interesadas a comprender cómo se entrenó un modelo de IA y cómo funciona. La IA explicable, o XAI, es un subconjunto de la transparencia que abarca las herramientas que informan a las partes interesadas sobre cómo un modelo de IA realiza determinadas predicciones y decisiones.

La transparencia y la XAI son cruciales para establecer la confianza en los sistemas de IA, pero no existe una solución universal que se adapte a todos los tipos de modelos de IA y partes interesadas. Encontrar la solución adecuada implica un enfoque sistemático para identificar a quién afecta la IA, analizar los riesgos asociados e implementar mecanismos efectivos para proporcionar información sobre el sistema de IA.

La generación aumentada de recuperación, o RAG, es una técnica que promueve la transparencia de la IA al conectar los servicios de IA generativa con bases de datos externas autorizadas, lo que permite a los modelos citar sus fuentes y proporcionar respuestas más precisas. NVIDIA está ayudando a los desarrolladores a comenzar con un workflow de RAG que utiliza el framework NVIDIA NeMo para desarrollar y personalizar modelos de IA generativa.

NVIDIA también forma parte del Consorcio del Instituto de Seguridad de Inteligencia Artificial de EE. UU. (AISIC, por sus siglas en inglés) del Instituto Nacional de Estándares y Tecnología para ayudar a crear herramientas y estándares para el desarrollo y la implementación responsables de la IA. Como miembro del consorcio, NVIDIA promoverá una IA confiable aprovechando las mejores prácticas para implementar la transparencia de los modelos de IA.

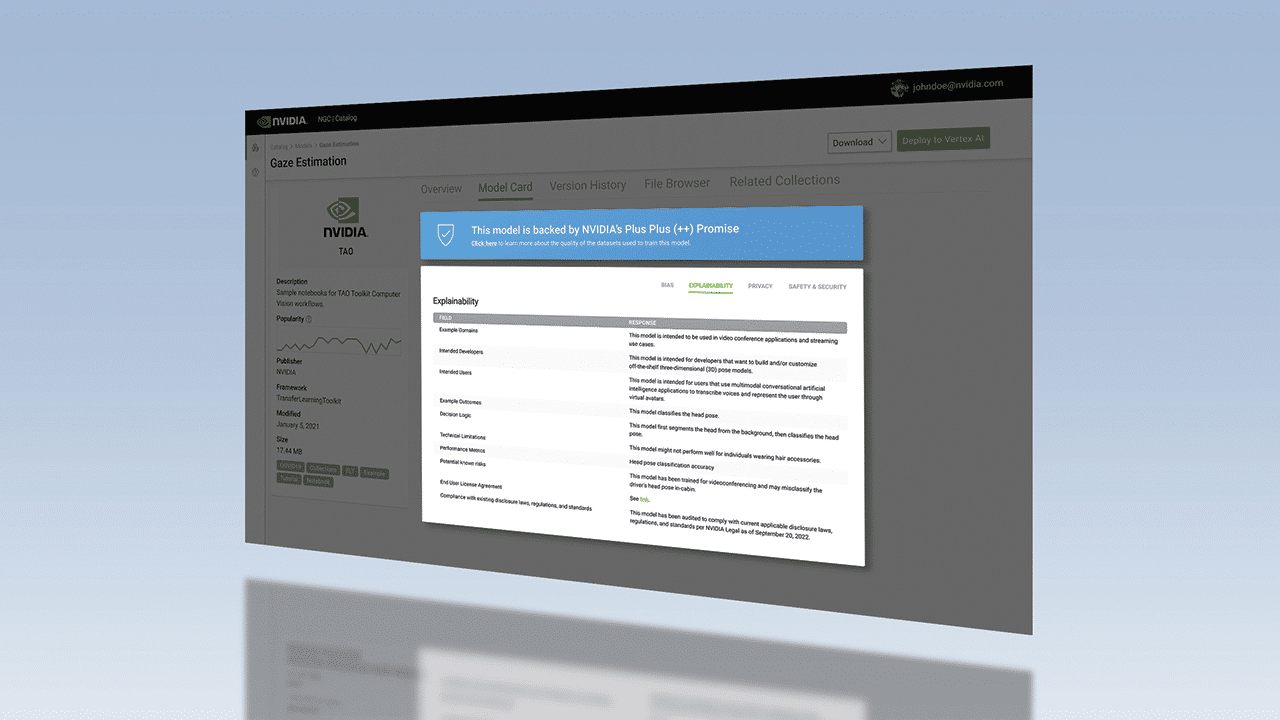

Y en el centro de software acelerado de NVIDIA, NGC, las tarjetas de modelo ofrecen información detallada sobre cómo funciona y se construyó cada modelo de IA. El formato Model Card ++ de NVIDIA describe los conjuntos de datos, los métodos de entrenamiento y las medidas de rendimiento utilizadas, la información sobre licencias, así como consideraciones éticas específicas.

No Discriminación: Minimizar los Prejuicios

Los modelos de IA son entrenados por humanos, a menudo utilizando datos limitados por el tamaño, el alcance y la diversidad. Para garantizar que todas las personas y comunidades tengan la oportunidad de beneficiarse de esta tecnología, es importante reducir los sesgos no deseados en los sistemas de IA.

Más allá de seguir las directrices gubernamentales y las leyes contra la discriminación, los desarrolladores de IA confiable mitigan los posibles sesgos no deseados buscando pistas y patrones que sugieran que un algoritmo es discriminatorio o implica el uso inapropiado de ciertas características. Los sesgos raciales y de género en los datos son bien conocidos, pero otras consideraciones incluyen el sesgo cultural y el sesgo introducido durante el etiquetado de los datos. Para reducir el sesgo no deseado, los desarrolladores pueden incorporar diferentes variables en sus modelos.

Los conjuntos de datos sintéticos ofrecen una solución para reducir el sesgo no deseado en los datos de entrenamiento utilizados para desarrollar IA para vehículos autónomos y robótica. Si los datos utilizados para entrenar coches autónomos no representan escenas poco comunes, como condiciones meteorológicas extremas o accidentes de tráfico, los datos sintéticos pueden ayudar a aumentar la diversidad de estos conjuntos de datos para representar mejor el mundo real, lo que ayuda a mejorar la precisión de la IA.

NVIDIA Omniverse Replicator, un framework basado en la plataforma NVIDIA Omniverse para crear y operar pipelines 3D y mundos virtuales, ayuda a los desarrolladores a configurar pipelines personalizados para la generación de datos sintéticos. Y al integrar el Kit de Herramientas NVIDIA TAO para el aprendizaje por transferencia con Innotescus, una plataforma web para seleccionar conjuntos de datos imparciales para la visión artificial, los desarrolladores pueden comprender mejor los patrones y sesgos de los conjuntos de datos para ayudar a abordar los desequilibrios estadísticos.

Obtén más información sobre la IA confiable en NVIDIA.com y en el Blog de NVIDIA. Para obtener más información sobre cómo abordar el sesgo no deseado en la IA, vea esta charla de NVIDIA GTC.