La IA generativa es el último giro en el cambiante panorama digital. Una de las innovaciones revolucionarias que lo hacen posible es un término relativamente nuevo: SuperNIC.

¿Qué Es Una SuperNIC?

SuperNIC es una nueva clase de aceleradores de red diseñados para potenciar las cargas de trabajo de IA a hiperescala en nubes basadas en Ethernet. Proporciona conectividad de red ultrarrápida para la comunicación de GPU a GPU, alcanzando velocidades que alcanzan los 400Gb/s mediante el acceso directo a memoria remota (RDMA) a través de la tecnología Ethernet convergente (RoCE).

Las SuperNIC combinan los siguientes atributos únicos:

- Reordenamiento de paquetes de alta velocidad para garantizar que los paquetes de datos se reciban y procesen en el mismo orden en que se transmitieron originalmente. Esto mantiene la integridad secuencial del flujo de datos.

- Control avanzado de la congestión mediante datos de telemetría en tiempo real y algoritmos de reconocimiento de la red para gestionar y prevenir la congestión en las redes de IA.

- Computación programable en la ruta de entrada/salida (E/S) para permitir la personalización y la extensibilidad de la infraestructura de red en los data center en la nube de IA.

- Diseño de bajo perfil y eficiencia energética para adaptarse de manera eficiente a las cargas de trabajo de IA dentro de presupuestos de energía limitados.

- Optimización de IA de pila completa, que incluye computación, redes, almacenamiento, software de sistema, bibliotecas de comunicación y frameworks de aplicaciones.

NVIDIA ha presentado recientemente la primera SuperNIC del mundo adaptada a la computación de IA, basada en la plataforma de red BlueField-3. Forma parte de la plataforma NVIDIA Spectrum-X, donde se integra a la perfección con el sistema de switch Ethernet Spectrum-4.

Juntos, la NVIDIA BlueField-3 SuperNIC y el sistema de switches Spectrum-4 forman la base de una estructura de computación acelerada diseñada específicamente para optimizar las cargas de trabajo de IA. Spectrum-X ofrece constantemente altos niveles de eficiencia de red, superando a los entornos Ethernet tradicionales.

«En un mundo en el que la IA está impulsando la próxima ola de innovación tecnológica, la BlueField-3 SuperNIC es un engranaje vital en la maquinaria», dijo Yael Shenhav, vicepresidente de productos DPU y NIC de NVIDIA. «Las SuperNIC garantizan que sus cargas de trabajo de IA se ejecuten con eficiencia y velocidad, lo que los convierte en componentes fundamentales para permitir el futuro de la computación de IA».

El Panorama Cambiante de la IA y las Redes

El campo de la IA está experimentando un cambio sísmico, gracias a la llegada de la IA generativa y los grandes modelos de lenguaje. Estas poderosas tecnologías han desbloqueado nuevas posibilidades, permitiendo que las computadoras manejen nuevas tareas.

El éxito de la IA depende en gran medida de la computación acelerada por GPU para procesar montañas de datos, entrenar grandes modelos de IA y permitir la inferencia en tiempo real. Esta nueva potencia de cómputo ha abierto nuevas posibilidades, pero también ha desafiado a las redes Ethernet en la nube.

Ethernet tradicional, la tecnología que sustenta la infraestructura de Internet, fue concebida para ofrecer una amplia compatibilidad y conectar aplicaciones de acoplamiento flexible. No fue diseñado para manejar las exigentes necesidades computacionales de las cargas de trabajo de IA modernas, que implican un procesamiento paralelo estrechamente acoplado, transferencias de datos rápidas y patrones de comunicación únicos, todo lo cual exige una conectividad de red optimizada.

Las tarjetas de interfaz de red (NIC) fundamentales se diseñaron para la computación de propósito general, la transmisión universal de datos y la interoperabilidad. Nunca se diseñaron para hacer frente a los desafíos únicos que plantea la intensidad computacional de las cargas de trabajo de IA.

Las NIC estándar carecen de las características y capacidades necesarias para una transferencia de datos eficiente, baja latencia y el rendimiento determinista crucial para las tareas de IA. Las SuperNIC, por otro lado, están diseñadas específicamente para cargas de trabajo de IA modernas.

Ventajas de SuperNIC en Entornos de Computación de IA

Las unidades de procesamiento de datos (DPU) ofrecen una gran cantidad de funciones avanzadas, ofreciendo un alto rendimiento, conectividad de red de baja latencia y más. Desde su introducción en 2020, las DPU han ganado popularidad en el ámbito de la computación en la nube, principalmente debido a su capacidad para descargar, acelerar y aislar el procesamiento de la infraestructura del data center.

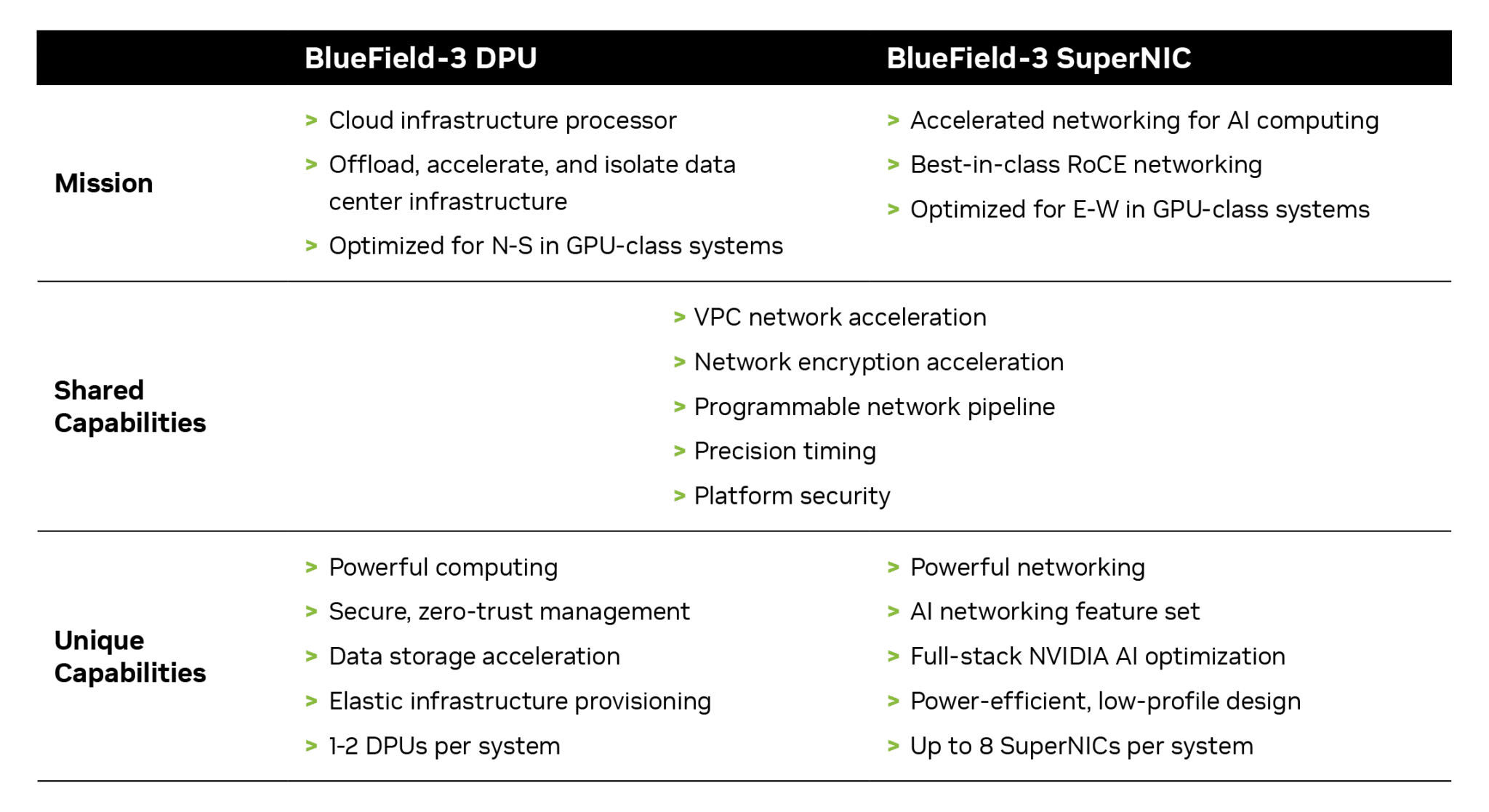

Aunque las DPU y las SuperNIC comparten una serie de características y capacidades, las SuperNIC están optimizadas de forma única para acelerar las redes para la IA. El siguiente gráfico muestra cómo se comparan:

El entrenamiento distribuido de IA y los flujos de comunicación de inferencia dependen en gran medida de la disponibilidad de ancho de banda de red para tener éxito. Las SuperNIC, que se distinguen por su diseño elegante, se escalan de forma más eficaz que las DPU, ya que ofrecen un impresionante ancho de banda de red de 400Gb/s por GPU.

La relación 1:1 entre las GPU y las SuperNIC dentro de un sistema puede mejorar significativamente la eficiencia de la carga de trabajo de la IA, lo que conduce a una mayor productividad y resultados superiores para las empresas.

El único propósito de los SuperNIC es acelerar las redes para la computación en la nube de IA. En consecuencia, logra este objetivo utilizando menos potencia de cálculo que una DPU, que requiere recursos computacionales sustanciales para descargar aplicaciones de una CPU host.

La reducción de los requisitos informáticos también se traduce en un menor consumo de energía, lo que es especialmente crucial en los sistemas que contienen hasta ocho SuperNIC.

Otras características distintivas de la SuperNIC son sus capacidades de red de IA dedicadas. Cuando se integra estrechamente con un switcher NVIDIA Spectrum-4 optimizado para IA, ofrece enrutamiento adaptativo, manejo de paquetes fuera de servicio y control de congestión optimizado. Estas características avanzadas son fundamentales para acelerar los entornos de nube de IA Ethernet.

Revolucionando la Computación en la Nube con IA

La NVIDIA BlueField-3 SuperNIC ofrece varias ventajas que la convierten en clave para una infraestructura preparada para la IA:

- Máxima eficiencia de la carga de trabajo de IA: La BlueField-3 SuperNIC está diseñada específicamente para la computación masiva paralela que hace un uso intensivo de la red, lo que la hace ideal para las cargas de trabajo de IA. Garantiza que las tareas de IA se ejecuten de manera eficiente, sin cuellos de botella.

- Rendimiento consistente y predecible: En data centers de múltiples inquilinos donde se procesan numerosas tareas simultáneamente, BlueField-3 SuperNIC garantiza que el rendimiento de cada trabajo y inquilino esté aislado, sea predecible y no se vea afectado por otras actividades de la red.

- Infraestructura segura en la nube multiusuario: la seguridad es una prioridad absoluta, especialmente en los data centers que manejan información confidencial. La SuperNIC BlueField-3 mantiene altos niveles de seguridad, lo que permite que coexistan varios inquilinos mientras se mantienen aislados los datos y el procesamiento.

- Infraestructura de red extensible: BlueField-3 SuperNIC no tiene un alcance limitado, sino que es muy flexible y adaptable a una gran cantidad de otras necesidades de infraestructura de red.

- Amplia compatibilidad con el fabricante de servidores: la BlueField-3 SuperNIC se adapta perfectamente a la mayoría de los servidores de clase empresarial sin un consumo excesivo de energía en los data centers.

Obtén más información sobre las SuperNIC BlueField-3 de NVIDIA, incluida la forma en que se integran en las plataformas de data centers de NVIDIA, en el documento técnico: Next-Generation Networking for the Next Wave of AI.