La generación de contenido impulsada por IA ahora está integrada en herramientas cotidianas como Adobe y Canva, y numerosas agencias y estudios incorporan esta tecnología en sus flujos de trabajo. Los modelos de imagen ahora ofrecen resultados fotorrealistas de forma consistente, los modelos de video pueden generar clips largos y coherentes, y ambos pueden seguir directrices creativas.

Los creadores ejecutan cada vez más estos flujos de trabajo de forma local en PCs para mantener los activos bajo control directo, eliminar los costos de los servicios en la nube y eliminar la fricción de la iteración, lo que facilita el perfeccionamiento de los resultados al ritmo que exigen los proyectos creativos reales.

Desde su creación, las PCs con NVIDIA RTX han sido el sistema elegido para ejecutar la IA creativa debido a su alto rendimiento, que reduce el tiempo de iteración, y el hecho de que los usuarios pueden ejecutar modelos en ellas de forma gratuita, lo que elimina la ansiedad por los tokens.

Con las recientes optimizaciones de RTX y los nuevos modelos de open-weight presentados en CES a principios de este mes, los creativos pueden trabajar más rápido, de manera más eficiente y con un control creativo mucho mayor

Cómo empezar

Empezar a utilizar la IA generativa visual puede parecer complejo y limitante. Los generadores de IA en línea son fáciles de usar, pero ofrecen un control limitado.

Las herramientas de código abierto de la comunidad, como ComfyUI, simplifican la configuración de flujos de trabajo creativos avanzados y son fáciles de instalar. También proporcionan una forma sencilla de descargar los últimos y mejores modelos, como FLUX.2 y LTX-2, así como los mejores flujos de trabajo de la comunidad.

A continuación, se explica cómo empezar a utilizar la IA generativa visual de forma local en PCs con RTX utilizando ComfyUI y modelos populares:

- Visita comfy.org para descargar e instalar ComfyUI para Windows.

- Inicia ComfyUI.

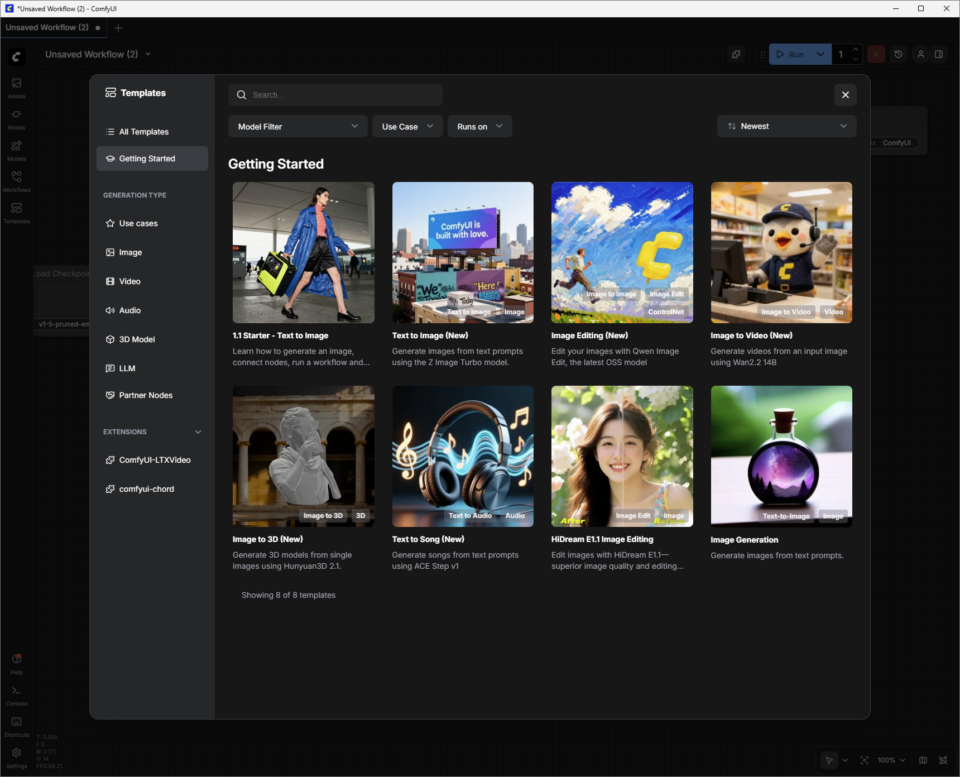

- Crea una imagen inicial utilizando la plantilla de inicio:

-

- Haz clic en el botón “Plantillas”, luego en “Introducción” y selecciona “1.1 Inicio: texto a imagen”.

- Conecta el modelo “Nodo” al “Nodo Guardar imagen”. Los nodos funcionan en una cadena para generar contenido utilizando IA.

- Presiona el botón azul “Ejecutar” y observa cómo se resalta el “Nodo” verde mientras la PC con tecnología RTX genera su primera imagen.

Cambia el mensaje y vuelve a ejecutarlo para adentrarse más profundamente en el mundo creativo de la IA generativa visual.

A continuación, encontrarás más información sobre cómo sumergirse en otras plantillas de ComfyUI que utilizan modelos de imagen y video más avanzados.

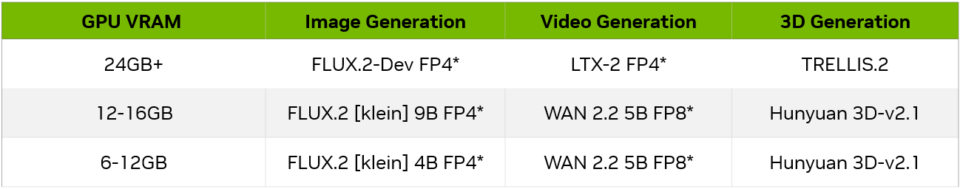

Tamaños de los modelos y GPUs

A medida que los usuarios se familiaricen con ComfyUI y los modelos que lo admiten, deberán tener en cuenta la capacidad de la VRAM de la GPU y si un modelo se ajustará a ella. A continuación, se muestran algunos ejemplos para empezar, en función de la VRAM de la GPU:

*Utiliza modelos FP4 con GPUs NVIDIA GeForce RTX Serie 50 y modelos FP8 con GPUs RTX Serie 40 para obtener los mejores resultados. Esto permite que los modelos utilicen menos VRAM y ofrezcan un mayor rendimiento.

Generación de imágenes

Para explorar cómo mejorar la calidad de la generación de imágenes con FLUX.2-Dev:

En la sección “Plantillas” de ComfyUI, haz clic en “Todas las plantillas” y buscar “FLUX.2 Dev Text to Image”. Selecciónalo y ComfyUI cargará la colección de nodos conectados, o “Flujo de trabajo”.

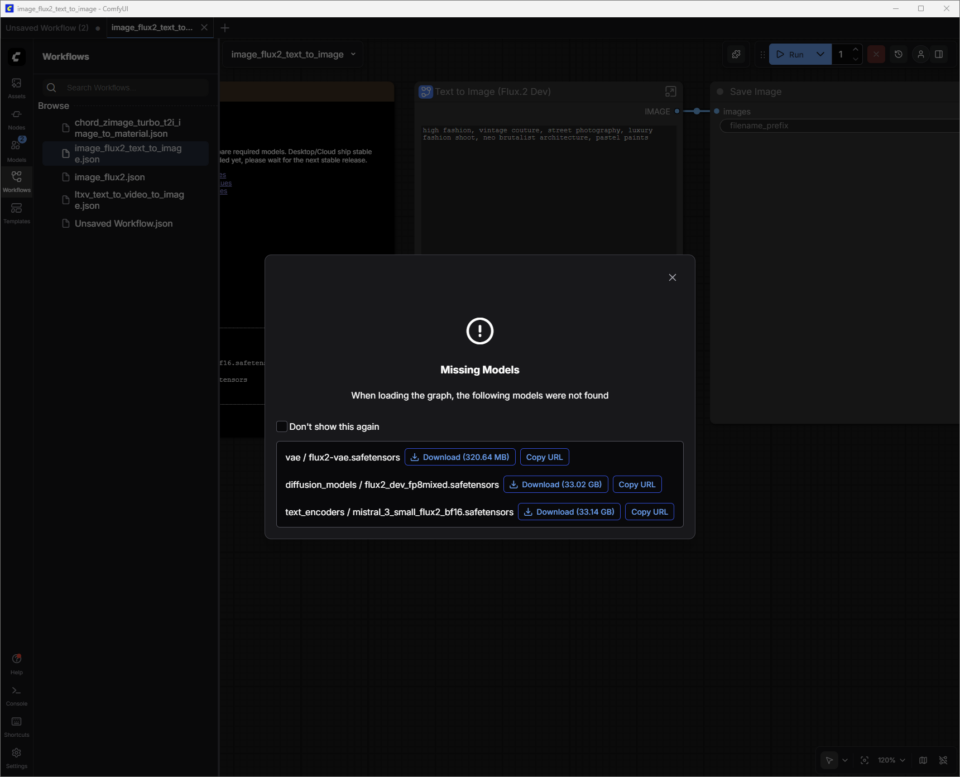

FLUX.2-Dev tiene weights de modelo que será necesario descargar.

Los weights del modelo son el “conocimiento” dentro de un modelo de IA; se pueden considerar como las sinapsis del cerebro. Cuando se entrenó un modelo de generación de imágenes como FLUX.2, aprendió patrones de millones de imágenes. Esos patrones se almacenan como miles de millones de valores numéricos llamados “weights”.

ComfyUI no viene con estos weights incorporados. En su lugar, los descarga bajo demanda desde repositorios como Hugging Face. Estos archivos son grandes (FLUX.2 puede superar los 30 GB, dependiendo de la versión), por lo que los sistemas necesitan suficiente almacenamiento y tiempo de descarga para obtenerlos.

Aparecerá un cuadro de diálogo para guiar a los usuarios a través de la descarga de los weights del modelo. Los archivos de weights (nombre de archivo.safetensors) se guardan automáticamente en la carpeta correcta de ComfyUI en la PC del usuario.

Guardar flujos de trabajo:

Ahora que se han descargado los weights del modelo, el siguiente paso es guardar esta plantilla recién descargada como un “flujo de trabajo”.

Los usuarios pueden hacer clic en el menú de hamburger de la parte superior izquierda (tres líneas) y seleccionar “Guardar”. El flujo de trabajo se guarda ahora en la lista de “Flujos de trabajo” del usuario (pulse W para mostrar u ocultar la ventana). Cierra la pestaña para salir del flujo de trabajo sin perder ningún trabajo.

Si el cuadro de diálogo de descarga se cerró accidentalmente antes de que terminara la descarga de los weights del modelo:

- Presione W para abrir rápidamente la ventana “Flujos de trabajo”.

- Seleccione el flujo de trabajo y ComfyUI lo cargará. Esto también le pedirá que descargue los weights del modelo que faltan.

- ComfyUI ya está listo para generar una imagen utilizando FLUX.2-Dev.

Consejos para FLUX.2-Dev:

- Comienza con descripciones claras y concretas del tema, el escenario, el estilo y el ambiente, por ejemplo: “Primer plano cinematográfico de un coche de carreras antiguo bajo la lluvia, reflejos de neón sobre el asfalto mojado, alto contraste, fotografía de 35 mm”. Las indicaciones cortas o medianas, de una o dos frases concisas, suelen ser más fáciles de controlar que las indicaciones largas, similares a una historia, especialmente al principio.

- Agrega restricciones para garantizar la coherencia y la calidad. Especifica aspectos como:

- Encuadre (“plano general” o “retrato”)

- Nivel de detalle (“alto nivel de detalle, enfoque nítido”)

- Realismo (“fotorrealista” o “ilustración estilizada”)

- Si los resultados son demasiado recargados, elimina adjetivos en lugar de agregar más.

- Evita las indicaciones negativas; limítate a indicar lo que deseas.

Obtén más información sobre las indicaciones de FLUX.2 en esta guía de Black Forest Labs.

Guardar ubicaciones en el disco:

Una vez que haya terminado de refinar la imagen, haz clic con el botón derecho en “Guardar nodo de imagen” para abrir la imagen en un navegador o guárdala en una nueva ubicación.

Las carpetas de salida predeterminadas de ComfyUI suelen ser las siguientes, según el tipo de aplicación y el sistema operativo:

- Windows (versión independiente/portátil): la carpeta suele encontrarse en C:\ComfyUI\output o en una ruta similar dentro de la carpeta donde se descomprimió el programa.

- Windows (aplicación de Desktop): la ruta suele encontrarse dentro del directorio AppData, por ejemplo: C:\Usuarios\%nombre de usuario%\AppData\Local\Programas\@comfyorgcomfyui-electron\recursos\ComfyUI\salida

- Linux: La ubicación de instalación predeterminada es ~/.config/ComfyUI.

Video de ayuda

Descubre cómo mejorar la calidad de la generación de video utilizando el nuevo modelo LTX-2 como ejemplo:

LTX-2 de Lightrick es un modelo avanzado de audio y video diseñado para la generación de video controlables, al estilo de un guion gráfico, en ComfyUI. Una vez descargadala plantilla LTX-2 Image to Video y los weights del modelo, comienza por tratar la sugerencia como una breve descripción de la toma, en lugar de como el guion completo de una película.

A diferencia de las dos primeras plantillas, LTX-2 Image to Video combina una imagen y un mensaje de texto para generar video.

Los usuarios pueden tomar una de las imágenes generadas en FLUX.2-Dev y agregar una indicación de texto para darle vida.

Consejos para las indicaciones de LTX-2:

Para obtener los mejores resultados en ComfyUI, escribe un único párrafo fluido en tiempo presente o utiliza un formato sencillo, similar al de un guion, con títulos de escena (sluglines), acción, nombres de personajes y diálogos. Intente escribir entre cuatro y seis frases descriptivas que cubran todos los aspectos clave:

- Establece la toma y la escena (plano general/medio/primer plano, iluminación, color, texturas, atmósfera).

- Describe la acción como una secuencia clara, define a los personajes con rasgos visibles y lenguaje corporal, y especifica los movimientos de cámara.

- Por último, agrega audio, como sonido ambiental, música y diálogos, utilizando comillas.

- Adapta el nivel de detalle a la escala de la toma. Por ejemplo, los primeros planos necesitan más detalles precisos sobre los personajes y las texturas que los planos generales. Sé claro sobre cómo se relaciona la cámara con el sujeto, no solo sobre dónde se mueve.

Detalles adicionales que se pueden agregar a las indicaciones:

- Lenguaje de movimiento de la cámara: especifica direcciones como “travelling lento”, “seguimiento con cámara en mano”, “toma por encima del hombro”, “panorámica”, “inclinación hacia arriba”, “acercamiento”, “alejamiento” o “fotograma estático”.

- Tipos de toma: especifica planos generales, medios o primeros planos con una iluminación cuidadosa, poca profundidad de campo y movimiento natural.

- Ritmo: Indica si deseas cámara lenta, time-lapses, tomas prolongadas, tomas continuas, fotogramas congelados o transiciones fluidas que den forma al ritmo y al tono.

- Atmósfera: agrega detalles como niebla, bruma, lluvia, luz dorada, reflejos y texturas ricas en la superficie que den solidez a la escena.

- Estilo: al principio de la indicación, especifica estilos como pictórico, cine negro, película analógica, stop-motion, bordes pixelados, editorial de moda o surrealista.

- Iluminación: Indica la iluminación de fondo, paletas de colores específicas, luz de contorno suave, destellos de lente u otros detalles de iluminación utilizando un lenguaje específico.

- Emociones: concéntrate en solicitar interpretaciones de un solo personaje con expresiones faciales claras y pequeños gestos.

- Voz y audio: pide a los personajes que hablen o canten en diferentes idiomas, con el apoyo de descripciones claras del sonido ambiental.

Optimización del uso de la VRAM y la calidad de imagen

Como modelo de vanguardia, LTX-2 utiliza una cantidad significativa de memoria de video (VRAM) para ofrecer resultados de calidad. El uso de la memoria aumenta a medida que aumentan la resolución, la velocidad de fotogramas, la duración o los pasos.

ComfyUI y NVIDIA han colaborado para optimizar una función de transmisión ponderada que permite a los usuarios descargar partes del flujo de trabajo a la memoria del sistema si tu GPU se queda sin VRAM, pero esto tiene un costo en términos de rendimiento.

Dependiendo de la GPU y del caso de uso, es posible que los usuarios deseen limitar estos factores para garantizar tiempos de generación razonables.

LTX-2 es un modelo increíblemente avanzado, pero, como ocurre con cualquier modelo, ajustar la configuración tiene un gran impacto en la calidad.

Obtén más información sobre cómo optimizar el uso de LTX-2 con GPUs RTX en la Guía de inicio rápido para LTX-2 en ComfyUI.

Creación de un flujo de trabajo personalizado con FLUX.2-Dev y LTX-2

Los usuarios pueden simplificar el proceso de saltar entre los flujos de trabajo de ComfyUI con FLUX.2-Dev para generar una imagen, buscarla en el disco y agregarla como una sugerencia de imagen al flujo de trabajo de imagen a video de LTX-2 combinando los modelos en un nuevo flujo de trabajo:

- Abre el flujo de trabajo guardado de texto a imagen de FLUX.2-Dev.

- Haz clic con el botón izquierdo del mouse y la tecla Ctrl pulsada en el nodo “Texto a imagen” de FLUX.2-Dev.

- En el flujo de trabajo LTX-2 de imagen a video, pega el nodo con Ctrl+V.

- Simplemente pase el cursor sobre el punto IMAGE del nodo Texto a imagen de FLUX.2-Dev, haz clic con el botón izquierdo y arrastre hasta el punto Cambiar tamaño de imagen/máscara de entrada. Aparecerá un conector azul.

Guarda con un nuevo nombre y solicita texto para imágenes y videos en un solo flujo de trabajo.

Generación 3D avanzada

Más allá de generar imágenes con FLUX.2 y videos con LTX-2, el siguiente paso es agregar orientación 3D. El proyecto NVIDIA Blueprint para IA generativa con orientación 3D muestra cómo utilizar escenas y recursos 3D para impulsar flujos de trabajo de imágenes y videos más controlables y de estilo profesional en PCs RTX, con flujos de trabajo listos para usar que los usuarios pueden inspeccionar, ajustar y ampliar.

Los creadores pueden mostrar su trabajo, conectarse con otros usuarios y encontrar ayuda en el subreddit de Stable Diffusion y enDiscord .

#ICYMI: los últimos avances en las PCs NVIDIA RTX AI

NVIDIA en CES 2026

Los anuncios de la CES incluyeron la aceleración de la generación de video 4K con IA en PC con LTX-2 y actualizaciones de ComfyUI. Además, las importantes aceleraciones de RTX en ComfyUI, LTX-2, Llama.cpp, Ollama, Hyperlink y más desbloquean casos de uso de generación de video, imágenes y texto en PCs con IA.

Variantes FLUX 2 de Black Forest Labs

FLUX.2 [klein] es un conjunto de modelos compactos y ultrarrápidos que admiten tanto la generación como la edición de imágenes ofreciendo una calidad de imagen de última generación. Los modelos están acelerados por NVFP4 y NVFP8, lo que aumenta la velocidad hasta 2.5 veces permitiendo funcionar con un alto rendimiento en una amplia gama de GPUs RTX.

Actualización del Proyecto G-Assist

Con un nuevo “modo de razonamiento” habilitado de forma predeterminada, el proyecto G-Assist gana en precisión e inteligencia, así como en la capacidad de ejecutar varios comandos a la vez. G-Assist ahora puede controlar la configuración de los monitores G-SYNC, los periféricos CORSAIR y los componentes de PC CORSAIR a través de iCUE, lo que abarca la iluminación, los perfiles, el rendimiento y la refrigeración.

Próximamente también se agregará compatibilidad con Elgato Stream Decks, lo que acercará a G-Assist a una interfaz de IA unificada para ajustar y controlar casi cualquier sistema. Para los desarrolladores de complementos de G-Assist, un nuevo generador de complementos basado en Cursor acelera el desarrollo utilizando el entorno de codificación agentica de Cursor.

Conéctate a NVIDIA AI PC en Facebook, Instagram, TikTok y X, y mantente informado suscribiéndote al boletín de RTX AI PC.

Sigue a NVIDIA Workstation en LinkedIn y X.

Consulta el aviso sobre la información del producto de software.