A raíz de ChatGPT, todas las empresas están tratando de descubrir su estrategia de IA, un trabajo que rápidamente plantea la pregunta: ¿Qué pasa con la seguridad?

Algunos pueden sentirse abrumados ante la perspectiva de asegurar una nueva tecnología. La buena noticia es que las políticas y prácticas vigentes hoy en día proporcionan excelentes puntos de partida.

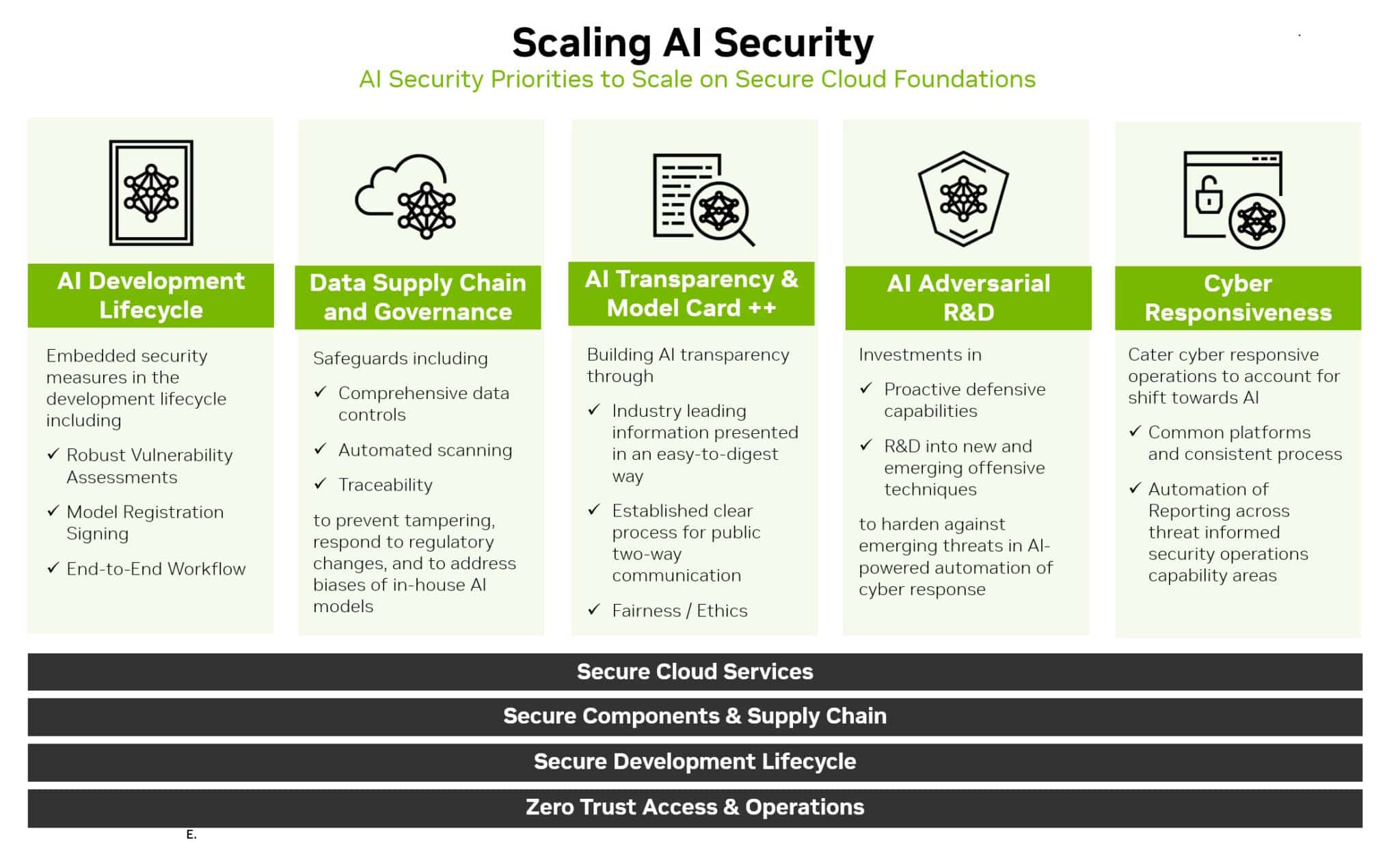

De hecho, el camino a seguir radica en ampliar los fundamentos existentes de la seguridad empresarial y en la nube. Es un viaje que se puede resumir en seis pasos:

- Ampliar el análisis de las amenazas

- Ampliar los mecanismos de respuesta

- Asegure la cadena de suministro de datos

- Utilice la IA para escalar los esfuerzos

- Sé transparente

- Crear mejoras continuas

Contempla el Horizonte Ampliado

El primer paso es familiarizarse con el nuevo paisaje.

La seguridad ahora debe cubrir el ciclo de vida de desarrollo de la IA. Esto incluye nuevas superficies de ataque como datos de entrenamiento, modelos y las personas y procesos que los utilizan.

Extrapolar los tipos conocidos de amenazas para identificar y anticipar las emergentes. Por ejemplo, un atacante podría intentar alterar el comportamiento de un modelo de IA accediendo a los datos mientras entrena el modelo en un servicio en la nube.

Los investigadores de seguridad y los equipos rojos que buscaron vulnerabilidades en el pasado volverán a ser grandes recursos. Necesitarán acceso a sistemas y datos de IA para identificar y actuar sobre nuevas amenazas, así como para ayudar a construir relaciones de trabajo sólidas con el personal de ciencia de datos.

Amplíe las Defensas

Una vez que una imagen de las amenazas sea clara, defina formas de defenderse contra ellas.

Supervise de cerca el rendimiento del modelo de IA. Supongamos que se desviará, abriendo nuevas superficies de ataque, al igual que se puede suponer que las defensas de seguridad tradicionales serán violadas.

También aproveche las prácticas PSIRT (Equipo de Respuesta a Incidentes de Seguridad del Producto) que ya deberían estar en su lugar.

Por ejemplo, NVIDIA lanzó políticas de seguridad de productos que abarcan su cartera de IA. Varias organizaciones, incluido el Open Worldwide Application Security Project, han lanzado implementaciones adaptadas a la IA de elementos clave de seguridad, como el método común de enumeración de vulnerabilidades utilizado para identificar las amenazas de TI tradicionales.

Adapte y aplique a los modelos y workflows de IA las defensas tradicionales como:

- Mantener separados el control de red y los planos de datos

- Eliminar cualquier dato de identificación personal o inseguro

- Uso de la seguridad y autenticación de confianza cero

- Definición de registros de eventos, alertas y pruebas adecuadas

- Configuración de controles de flujo cuando corresponda

- Ampliar las salvaguardias existentes

- Proteja los conjuntos de datos utilizados para entrenar modelos de IA. Son valiosos y vulnerables.

Una vez más, las empresas pueden aprovechar las prácticas existentes. Cree cadenas de suministro de datos seguras, similares a las creadas para asegurar canales para software. Es importante establecer un control de acceso para los datos de entrenamiento, al igual que otros datos internos están protegidos.

Es posible que sea necesario llenar algunas lagunas. Hoy en día, los especialistas en seguridad saben cómo usar los archivos hash de las aplicaciones para garantizar que nadie haya alterado su código. Ese proceso puede ser difícil de escalar para conjuntos de datos del tamaño de petabytes utilizados para el entrenamiento de IA.

La buena noticia es que los investigadores ven la necesidad y están trabajando en herramientas para abordarla.

Escale la Seguridad con IA

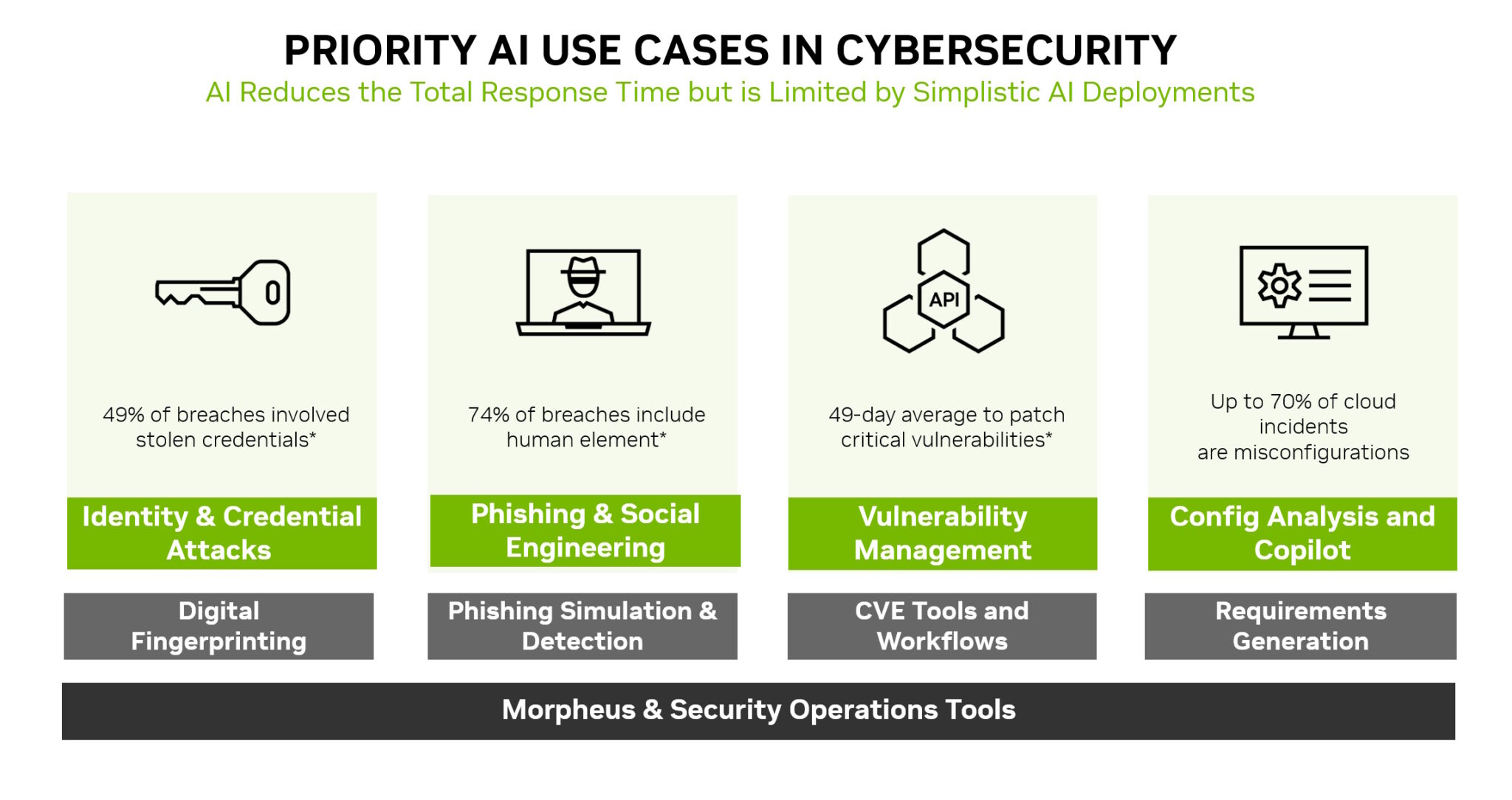

La IA no es solo una nueva área de ataque para defender, sino que también es una nueva y poderosa herramienta de seguridad.

Los modelos de machine learning pueden detectar cambios sutiles que ningún humano puede ver en montañas de tráfico de red. Eso hace que la IA sea una tecnología ideal para prevenir muchos de los ataques más utilizados, como el robo de identidad, el phishing, el malware y el ransomware.

NVIDIA Morpheus, un framework de ciberseguridad, puede crear aplicaciones de IA que crean, leen y actualizan huellas digitales que buscan muchos tipos de amenazas. Además, la IA generativa y Morpheus pueden permitir nuevas formas de detectar intentos de spear phishing.

La Seguridad Ama la Claridad

La transparencia es un componente clave de cualquier estrategia de seguridad. Informe a los clientes sobre las nuevas políticas y prácticas de seguridad de IA que se hayan implementado.

Por ejemplo, NVIDIA publica detalles sobre los modelos de IA en NGC, su centro de software acelerado. Llamadas tarjetas modelo, actúan como declaraciones de verdad en préstamos, describiendo IA, los datos en los que fueron entrenados y cualquier restricción para su uso.

NVIDIA utiliza un conjunto ampliado de campos en sus tarjetas modelo, por lo que los usuarios tienen claro el historial y los límites de una red neuronal antes de ponerla en producción. Eso ayuda a mejorar la seguridad, establecer confianza y garantizar que los modelos sean robustos.

Defina Viajes, No Destinos

Estos seis pasos son solo el comienzo de un viaje. Procesos y políticas como estos deben evolucionar.

La práctica emergente de la computación confidencial, por ejemplo, está extendiendo la seguridad a través de los servicios en la nube donde los modelos de IA a menudo se entrenan y ejecutan en producción.

La industria ya está empezando a ver versiones básicas de escáneres de código para modelos de IA. Son una señal de lo que está por venir. Los equipos deben estar atentos al horizonte para conocer las mejores prácticas y herramientas a medida que llegan.

En el camino, la comunidad necesita compartir lo que aprende. Un excelente ejemplo de ello ocurrió en el reciente Generative Red Team Challenge.

Al final, se trata de crear una defensa colectiva. Todos estamos haciendo este viaje hacia la seguridad de la IA juntos, paso a paso.