En el breve y deslumbrante discurso destacado de SIGGRAPH, los ejecutivos de NVIDIA describieron las fuerzas que impulsarán la próxima era de gráficos y la gama de herramientas en expansión de la compañía para acelerarlas.

«La combinación de IA y gráficos por computación impulsará el metaverso, la próxima evolución de Internet», dijo Jensen Huang, fundador y CEO de NVIDIA, en el inicio de la charla de 45 minutos.

Albergará mundos virtuales conectados y digital twins, un lugar para el trabajo real y los juegos. Además, dijo Huang, las posibilidades que ofrece una de las formas más populares de robots, los avatares humanos digitales, son muy emocionantes.

Con 45 demostraciones y diapositivas, cinco oradores de NVIDIA anunciaron lo siguiente:

- NVIDIA Omniverse Avatar Cloud Engine (ACE), una nueva plataforma para crear avatares.

- Planes para desarrollar Universal Scene Description (USD), el lenguaje del metaverso.

- Extensiones principales de NVIDIA Omniverse, la plataforma de computación para crear mundos virtuales y digital twins.

- Herramientas para potenciar los workflows gráficos con machine learning.

«Los anuncios que hicimos hoy permiten impulsar aún más el metaverso, una nueva plataforma de computación con nuevos modelos de programación, nuevas arquitecturas y nuevos estándares», dijo.

Las aplicaciones del metaverso ya están aquí.

Huang destacó los «productos 3D virtuales que puedes probar con realidad aumentada, las empresas de telecomunicaciones que crean digital twins de sus redes de radio para optimizar e implementar torres de radio [y] empresas que crean digital twins de almacenes y fábricas para optimizar su diseño y logística».

Aparición de los Avatares

El metaverso cobrará vida con los asistentes virtuales, avatares con los que interactuamos de forma tan natural como hablar con otra persona. Trabajarán en fábricas digitales, jugarán en juegos en línea y brindarán servicio al cliente para los vendedores por Internet.

«Habrá miles de millones de avatares», dijo Huang, y los llamó «uno de los tipos de robots más utilizados» que se diseñarán, entrenarán y operarán en Omniverse.

Los humanos y avatares digitales requieren el procesamiento de idiomas naturales, la visión de computación, las complejas animaciones faciales y corporales y más. Para moverse y hablar de maneras realistas, este conjunto de tecnologías complejas debe sincronizarse al milisegundo.

Es un trabajo duro que NVIDIA apunta a simplificar y acelerar con Omniverse Avatar Cloud Engine. ACE es una colección de modelos y servicios de IA que se basan en el trabajo de NVIDIA que abarca todo, desde la IA conversacional hasta las herramientas de animación como Audio2Face y Audio2Emotion.

MetaHuman en Unreal Engine imagen de cortesía de Epic Games

«Con Omniverse ACE, los desarrolladores pueden crear, configurar e implementar su aplicación de avatar en cualquier motor y en cualquier cloud público o privado», dijo Simon Yuen, director de gráficos e IA de NVIDIA. «Queremos democratizar la creación de avatares interactivos para cada plataforma».

ACE estará disponible a principios del próximo año, y se ejecutará en sistemas integrados y todos los servicios de cloud más importantes.

Yuen también mostró la última versión de Omniverse Audio2Face, un modelo de IA que puede crear animación facial directamente a partir de voces.

«Simplemente agregamos más funciones para analizar y transferir automáticamente tus emociones a tu avatar», dijo.

Las futuras versiones de Audio2Face crearán avatares a partir de una sola foto, aplicando texturas automáticamente y generando mallas 3D listas para la animación. Lograrán simulaciones de alta fidelidad de movimientos musculares que la IA puede aprender al ver un video; incluso pelos realistas que responden como se espera al aseo virtual.

USD, una Base para la Internet 3D

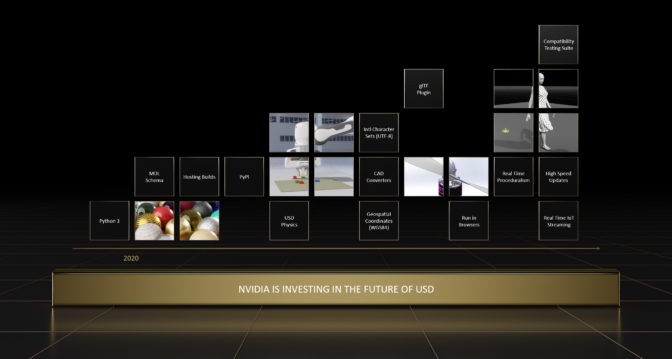

Muchas superpotencias del metaverso se basarán en USD, una base para la Internet 3D.

El metaverso «necesita una forma estándar de describir todas las cosas dentro de los mundos 3D», dijo Rev Lebaredian, vicepresidente de Tecnología de simulación de Omniverse en NVIDIA.

«Creemos que la Universal Scene Description, el estándar de código abierto inventado por Pixar, es la descripción de escenas estándar para la próxima era de Internet», agregó, comparando el formato USD con HTML en la web 2D.

Lebaredian describió la visión de NVIDIA para USD como una clave para abrir aún más oportunidades que las del mundo físico.

«Nuestros próximos hitos tienen como objetivo hacer que USD sea compatible con los mundos virtuales en tiempo real y a gran escala y los digital twins industriales», dijo, señalando los planes de NVIDIA para ayudar a desarrollar la compatibilidad en USD para conjuntos de personajes internacionales, coordenadas geoespaciales y transmisión en tiempo real de datos de IoT.

Para acelerar aún más la adopción de los USD, NVIDIA lanzará un conjunto de pruebas de compatibilidad y certificación para USD. Les permite a los desarrolladores saber que sus componentes USD personalizados producen el resultado esperado.

Además, NVIDIA anunció un conjunto de recursos de USD listos para la simulación, diseñados para usarse en digital twins industriales y workflows de entrenamiento de IA. Se unen a una gran cantidad de recursos de USD que están disponibles en línea de forma gratuita. Estos recursos incluyen escenas listas para USD, tutoriales bajo demanda, documentación y cursos dirigidos por instructores.

«Queremos que todo el mundo ayude a construir y evolucionar USD», dijo Lebaredian.

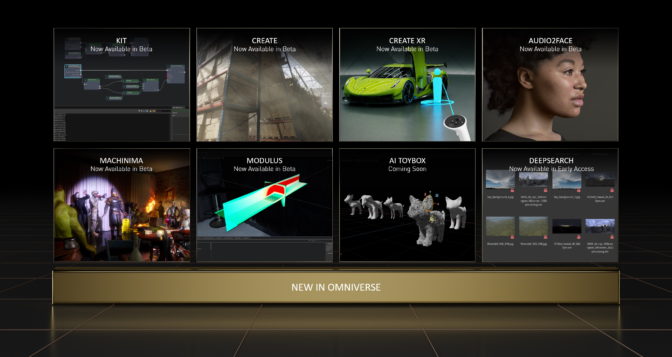

Omniverse Expande su Paleta

Uno de los mayores anuncios del discurso destacado fue un nuevo lanzamiento importante de NVIDIA Omniverse, una plataforma que se ha descargado 184,000 veces.

Huang llamó a Omniverse «una plataforma USD, un kit de herramientas para crear aplicaciones del metaverso y un motor de computación para ejecutar mundos virtuales».

La última versión incluye varias tecnologías básicas actualizadas y más conexiones a herramientas populares.

Los vínculos, llamados Conectores de Omniverse, ahora están en desarrollo para Unity, Blender, Autodesk Alias, Siemens JT, SimScale, el Open Geospatial Consortium y más. Las versiones beta de Conectores ahora están disponibles para PTC Creo, Visual Components y SideFX Houdini. Estos nuevos desarrollos se unen a Siemens Xcelerator, que ahora forma parte de la red Omniverse, para dar la bienvenida a más clientes industriales en la era de los digital twins.

Al igual que la internet en sí, Omniverse es «una red de redes», que conecta a los usuarios de todas las industrias y disciplinas, dijo Steve Parker, vicepresidente de gráficos profesionales de NVIDIA.

Casi una docena de socios mostrarán las capacidades de Omniverse en SIGGRAPH, incluidos proveedores de hardware, software y servicios de cloud, que van desde AWS y Adobe hasta Dell, Epic y Microsoft. Media docena de socios llevarán a cabo sesiones impulsadas por NVIDIA sobre temas como la IA y los mundos virtuales.

Acelerar la Física, Animar a los Animales

Parker detalló varias actualizaciones de tecnología en Omniverse. Abarcan mejoras para simular materiales físicamente precisos con el Lenguaje de Definición de Materiales (MDL), la física en tiempo real con PhysX y el sistema de renderización híbrido e IA, RTX.

«Estos pilares tecnológicos centrales son impulsados por la computación de alto rendimiento de NVIDIA desde el edge hasta el cloud», dijo Parker.

Por ejemplo, PhysX ahora admite la simulación de telas y cuerpos suaves, lo que brinda más precisión física a los mundos virtuales en tiempo real. Además, NVIDIA modificó MDL para que sea de código abierto, por lo que es compatible con los estándares de API de gráficos como OpenGL o Vulkan. Esto amplía la disponibilidad del estándar de materiales para los desarrolladores.

Omniverse también incluirá capacidades gráficas neuronales desarrolladas por NVIDIA Research que combinan los gráficos RTX y la IA. Por ejemplo:

- Animal Modelers permiten a los artistas iterar en la forma de un animal con nubes de puntos y luego generan automáticamente una malla 3D.

- GauGAN360, la próxima evolución de NVIDIA GauGAN, genera panoramas de 8K y 360 grados que se pueden cargar fácilmente en una escena de Omniverse.

- Instant NeRF crea objetos y escenas 3D a partir de imágenes 2D.

Una Extensión de Omniverse para NVIDIA Modulus, un framework de machine learning, permitirá a los desarrolladores usar la IA para acelerar las simulaciones de física del mundo real hasta 100,000 veces, para que el metaverso se vea y se sienta como el mundo físico.

Además, Omniverse Machinima, el tema de un animado concurso en SIGGRAPH, ahora incluye contenido de Post Scriptum, Beyond the Wire y Shadow Warrior 3, además de nuevas herramientas de animación de IA como Audio2Gesture.

Una demostración de Industrial Light & Magic mostró otra función nueva. Omniverse DeepSearch utiliza la IA para ayudar a los equipos a realizar búsquedas intuitivas en enormes bases de datos de recursos sin etiquetar, a fin de ofrecer resultados precisos para términos, incluso cuando no se enumeran específicamente en los metadatos.

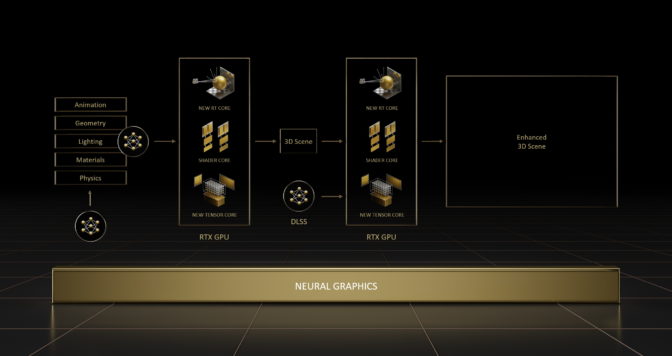

Gráficos Inteligentes

Uno de los pilares esenciales del metaverso emergente son los gráficos neuronales. Es una disciplina híbrida que aprovecha los modelos de redes neuronales para acelerar y mejorar los gráficos por computación.

«Los gráficos neuronales entrelazan la IA y los gráficos, para permitir un pipeline de gráficos futuro que puede aprender de los datos», dijo Sanja Fidler, vicepresidenta de IA en NVIDIA. «Los gráficos neuronales redefinen la forma en que los usuarios crean, simulan y experimentan mundos virtuales», agregó.

La IA ayudará a los artistas a generar la enorme cantidad de contenido 3D necesaria para crear el metaverso. Por ejemplo, pueden usar gráficos neuronales para capturar objetos y comportamientos en el mundo físico rápidamente.

Fidler describió el software de NVIDIA para hacer exactamente eso, Instant NeRF, una herramienta para crear un objeto o escena 3D a partir de imágenes 2D. Es el tema de uno de los dos premios a la mejor investigación de NVIDIA en SIGGRAPH.

En el otro premio a la mejor investigación, las tarjetas gráficas neuronales potencian un modelo que puede predecir y reducir las latencias de reacción en los eSports y las aplicaciones de AR/VR. Las dos mejores investigaciones se encuentran entre las 16 en total que los investigadores de NVIDIA presentarán esta semana en SIGGRAPH.

Los diseñadores e investigadores pueden aplicar gráficos neuronales y otras técnicas para crear su propio trabajo galardonado utilizando los nuevos conjuntos de desarrollo de software que NVIDIA presentó en el evento.

Fidler describió a uno de ellos, Kaolin Wisp, un conjunto de herramientas para crear campos neuronales, modelos de IA que representan una escena u objeto 3D, con solo unas pocas líneas de código.

Por separado, NVIDIA presentó NeuralVDB, la próxima evolución del estándar de código abierto OpenVDB que se usa en diferentes industrias, desde los efectos visuales hasta la computación científica, para simular y renderizar el agua, el fuego, el humo y las nubes.

NeuralVDB utiliza modelos neuronales y optimización de GPU para reducir enormemente los requisitos de memoria, a fin de que los usuarios puedan interactuar con conjuntos de datos extremadamente grandes y complejos en tiempo real y compartirlos de manera más eficiente.

«La IA, la fuerza tecnológica más poderosa de nuestro tiempo, revolucionará todos los campos de la ciencia de la computación, incluidos los gráficos por computación. Además, NVIDIA RTX es el motor de los gráficos neuronales», dijo Huang.

Mira el discurso destacado de NVIDIA en el sitio del evento SIGGRAPH, que también incluye detalles de laboratorios, presentaciones y un estreno de una película documental.