Las GPU han sido llamadas los metales de tierras raras, incluso el oro, de la inteligencia artificial, porque son fundamentales para la era actual de la IA generativa.

Tres razones técnicas, y muchas historias, explican por qué esto es así. Cada razón tiene múltiples facetas que vale la pena explorar, pero en un nivel general:

- Las GPU emplean procesamiento paralelo.

- Los sistemas de GPU se amplían hasta alcanzar alturas de supercomputación.

- La pila de software de GPU para IA es amplia y profunda.

El resultado neto es que las GPU realizan cálculos técnicos más rápido y con mayor eficiencia energética que las CPU. Esto significa que ofrecen un rendimiento líder para el entrenamiento y la inferencia de IA, así como ganancias en una amplia gama de aplicaciones que utilizan la computación acelerada.

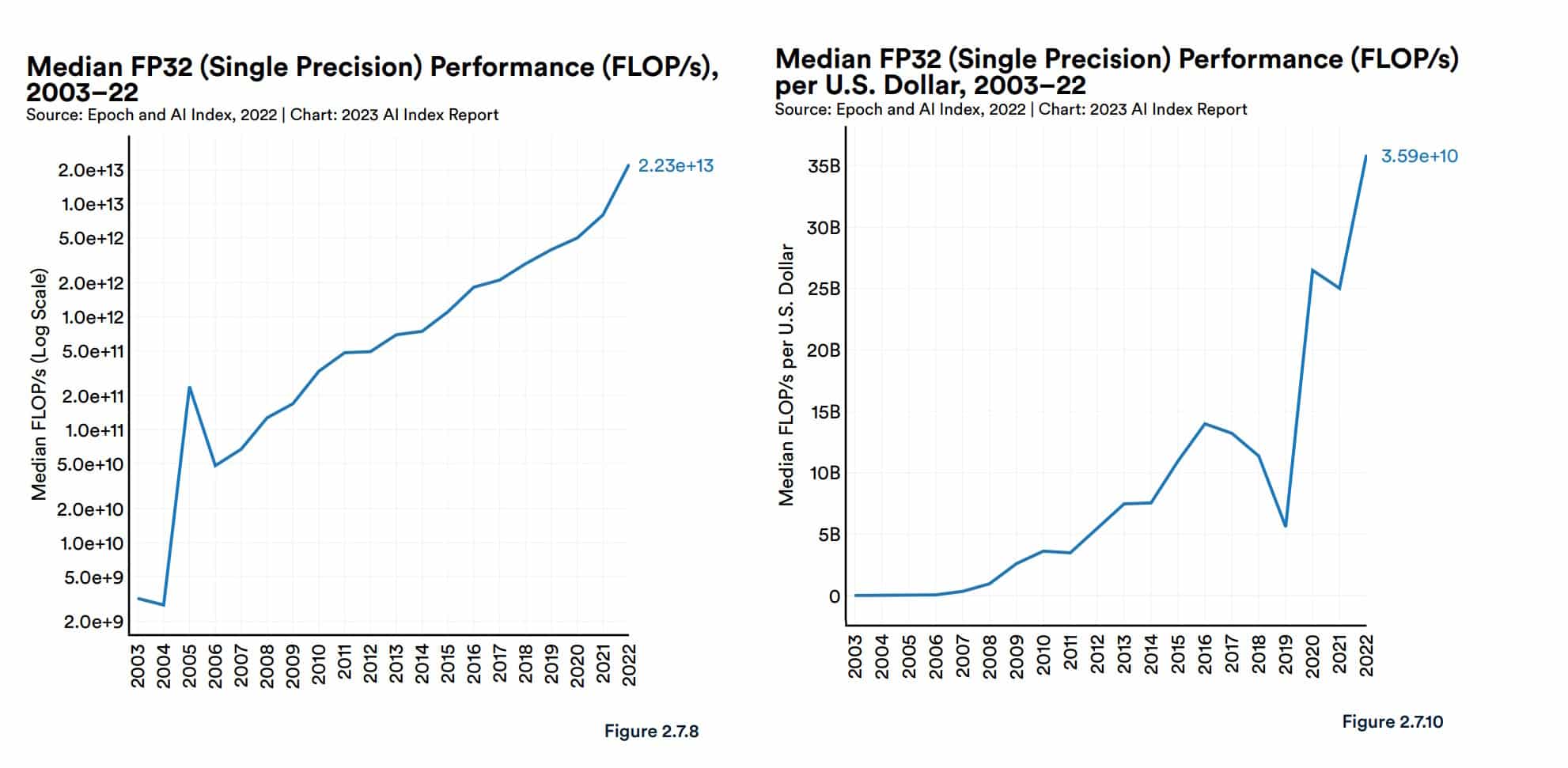

En su reciente informe sobre IA, el grupo de IA centrada en el ser humano de Stanford proporcionó algo de contexto. El rendimiento de la GPU «ha aumentado aproximadamente 7.000 veces» desde 2003 y el precio por rendimiento es «5.600 veces mayor», informó.

El informe también citó un análisis de Epoch, un grupo de investigación independiente que mide y pronostica los avances de la IA.

«Las GPU son la plataforma de computación dominante para acelerar las cargas de trabajo de machine learning, y la mayoría (si no todos) de los modelos más grandes de los últimos cinco años se han entrenado en GPU… [por lo tanto] han contribuido de manera central al progreso reciente en IA», dijo Epoch en su sitio.

Un estudio de 2020 que evaluó la tecnología de IA para el gobierno de EE. UU. llegó a conclusiones similares.

«Esperamos que los chips de IA [de vanguardia] sean de uno a tres órdenes de magnitud más rentables que las CPU de nodo líder al contar los costos de producción y operación», dijo.

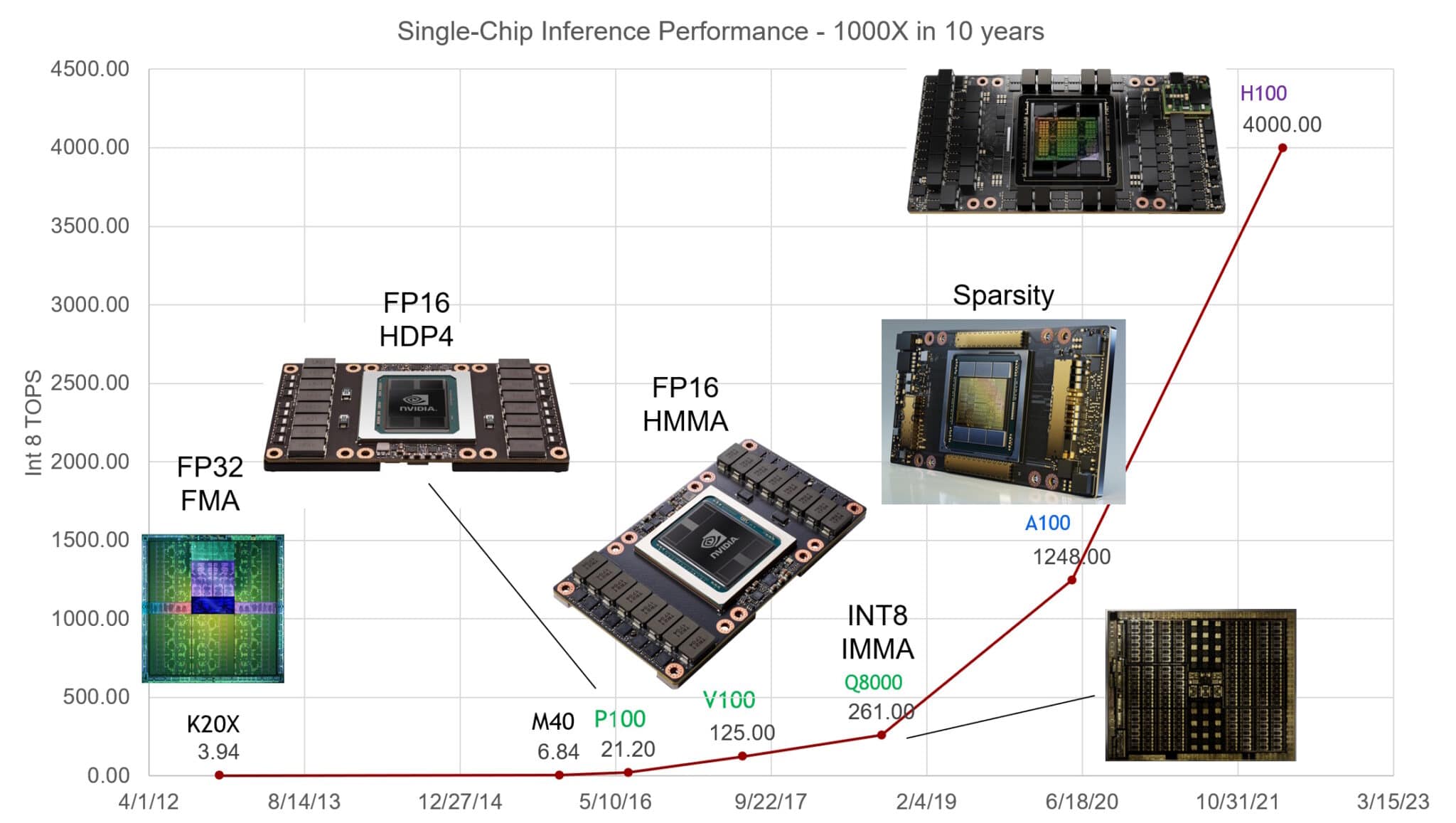

Las GPU de NVIDIA han aumentado 1.000 veces el rendimiento en la inferencia de IA en los últimos diez años, dijo Bill Dally, científico jefe de la compañía, en un discurso de apertura en Hot Chips, una reunión anual de ingenieros de semiconductores y sistemas.

ChatGPT Difundió la Noticia

ChatGPT proporcionó un poderoso ejemplo de cómo las GPU son excelentes para la IA. El grande modelo de lenguaje (LLM), entrenado y ejecutado en miles de GPU NVIDIA, ejecuta servicios de IA generativa utilizados por más de 100 millones de personas.

Desde su lanzamiento en 2018, MLPerf, el punto de referencia estándar de la industria para IA, ha proporcionado números que detallan el rendimiento líder de las GPU NVIDIA tanto en el entrenamiento como en la inferencia de IA.

Por ejemplo, los Superchips Grace Hopper de NVIDIA arrasaron en la última ronda de pruebas de inferencia. NVIDIA TensorRT-LLM, el software de inferencia lanzado desde esa prueba, ofrece un aumento de hasta 8 veces en el rendimiento y una reducción de más de 5 veces en el uso de energía y el costo total de propiedad. De hecho, las GPU de NVIDIA han ganado todas las rondas de entrenamiento de MLPerf y pruebas de inferencia desde que se lanzó el punto de referencia en 2019.

En febrero, las GPU de NVIDIA ofrecieron resultados líderes para la inferencia, ofreciendo miles de inferencias por segundo en los modelos más exigentes en el punto de referencia STAC-ML Markets, un indicador de rendimiento tecnológico clave para la industria de servicios financieros.

Un equipo de ingeniería de software de RedHat lo expresó sucintamente en un blog: «Las GPU se han convertido en la base de la inteligencia artificial».

IA Bajo el Capó

Un breve vistazo bajo el capó muestra por qué las GPU y la IA forman una poderosa pareja.

Un modelo de IA, también llamado red neuronal, es esencialmente una lasaña matemática, hecha de capa sobre capa de ecuaciones de álgebra lineal. Cada ecuación representa la probabilidad de que un dato esté relacionado con otro.

Por su parte, las GPU contienen miles de núcleos, pequeñas calculadoras que trabajan en paralelo para analizar las matemáticas que componen un modelo de IA. Esto, a grandes rasgos, es como funciona la computación de IA.

Núcleos Tensor Altamente Ajustados

Con el tiempo, los ingenieros de NVIDIA han ajustado los núcleos de GPU a las necesidades cambiantes de los modelos de IA. Las GPU más recientes incluyen Núcleos Tensor que son 60 veces más potentes que los diseños de primera generación para procesar las matrices matemáticas que utilizan las redes neuronales.

Además, las GPU Hopper Tensor Core de NVIDIA incluyen un Motor Transformer que puede ajustarse automáticamente a la precisión óptima necesaria para procesar modelos transformer, la clase de redes neuronales que generó IA generativa.

A lo largo del camino, cada generación de GPU ha incluido más memoria y ha optimizado técnicas para almacenar un modelo de IA completo en una sola GPU o conjunto de GPU.

Los Modelos Crecen, Los Sistemas Se Expanden

La complejidad de los modelos de IA se está expandiendo la friolera de 10 veces al año.

El LLM de última generación actual, GPT4, contiene más de un billón de parámetros, una métrica de su densidad matemática. Eso es un aumento de menos de 100 millones de parámetros para un LLM popular en 2018.

Los sistemas de GPU han mantenido el ritmo uniéndose al desafío. Se convierten en superordenadores, gracias a sus rápidas interconexiones NVLink y a las redes NVIDIA Quantum InfiniBand.

Por ejemplo, la DGX GH200, una supercomputadora de IA de gran memoria, combina hasta 256 superchips NVIDIA GH200 Grace Hopper en una sola GPU del tamaño de un data center con 144 terabytes de memoria compartida.

Cada superchip GH200 es un único servidor con 72 núcleos de CPU Arm Neoverse y cuatro petaflops de rendimiento de IA. Una nueva configuración de sistemas Grace Hopper de cuatro vías coloca en un solo nodo de cómputo la friolera de 288 núcleos Arm y 16 petaflops de rendimiento de IA con hasta 2,3 terabytes de memoria de alta velocidad.

Y las GPU NVIDIA H200 Tensor Core anunciadas en noviembre incluyen hasta 288 gigabytes de la última tecnología de memoria HBM3e.

El Software Cubre el Paseo Marítimo

Desde 2007 ha evolucionado un océano en expansión de software de GPU para habilitar todas las facetas de la IA, desde funciones de tecnología profunda hasta aplicaciones de alto nivel.

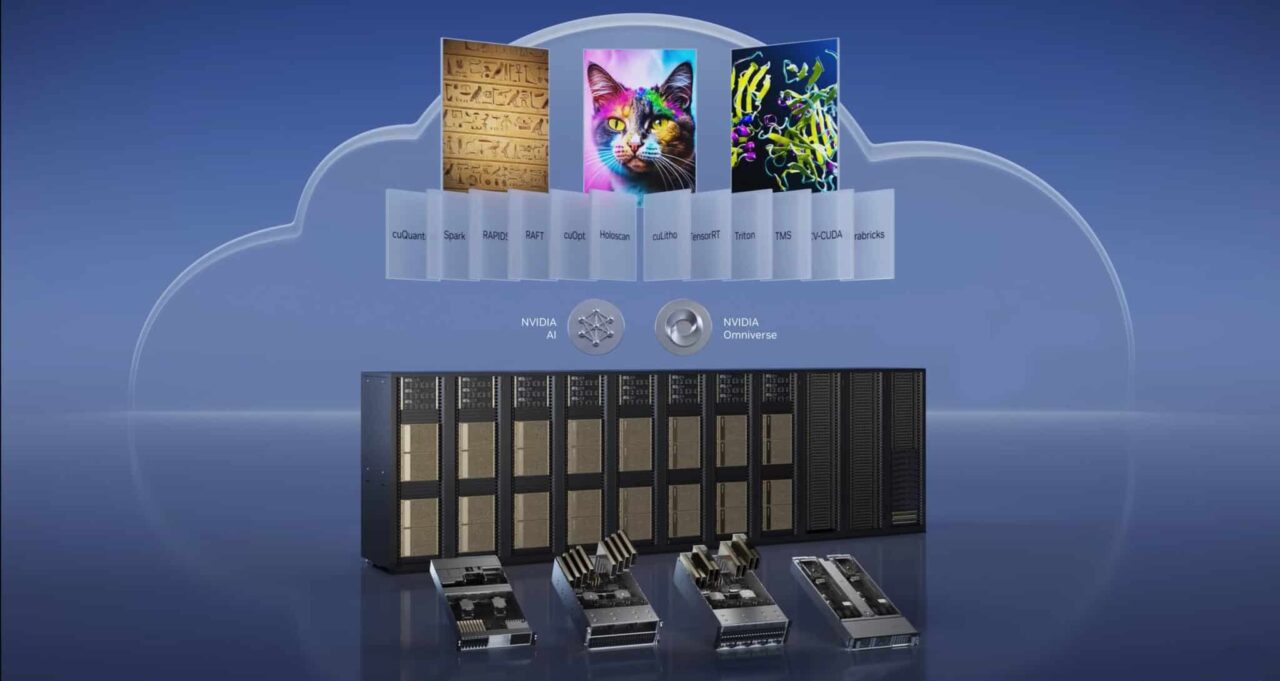

La plataforma de IA de NVIDIA incluye cientos de bibliotecas de software y aplicaciones. El lenguaje de programación CUDA y la biblioteca cuDNN-X para el deep learning proporcionan una base sobre la que los desarrolladores han creado software como NVIDIA NeMo, un framework para permitir a los usuarios crear, personalizar y ejecutar inferencias en sus propios modelos de IA generativa.

Muchos de estos elementos están disponibles como software de código abierto, el elemento básico de los desarrolladores de software. Más de un centenar de ellos están empaquetados en la plataforma NVIDIA AI Enterprise para empresas que requieren seguridad y soporte completos. Cada vez más, también están disponibles en los principales proveedores de servicios en la nube como API y servicios en NVIDIA DGX Cloud.

SteerLM, una de las últimas actualizaciones de software de IA para las GPU NVIDIA, permite a los usuarios ajustar los modelos durante la inferencia.

Una Aceleración de 70 Veces en 2008

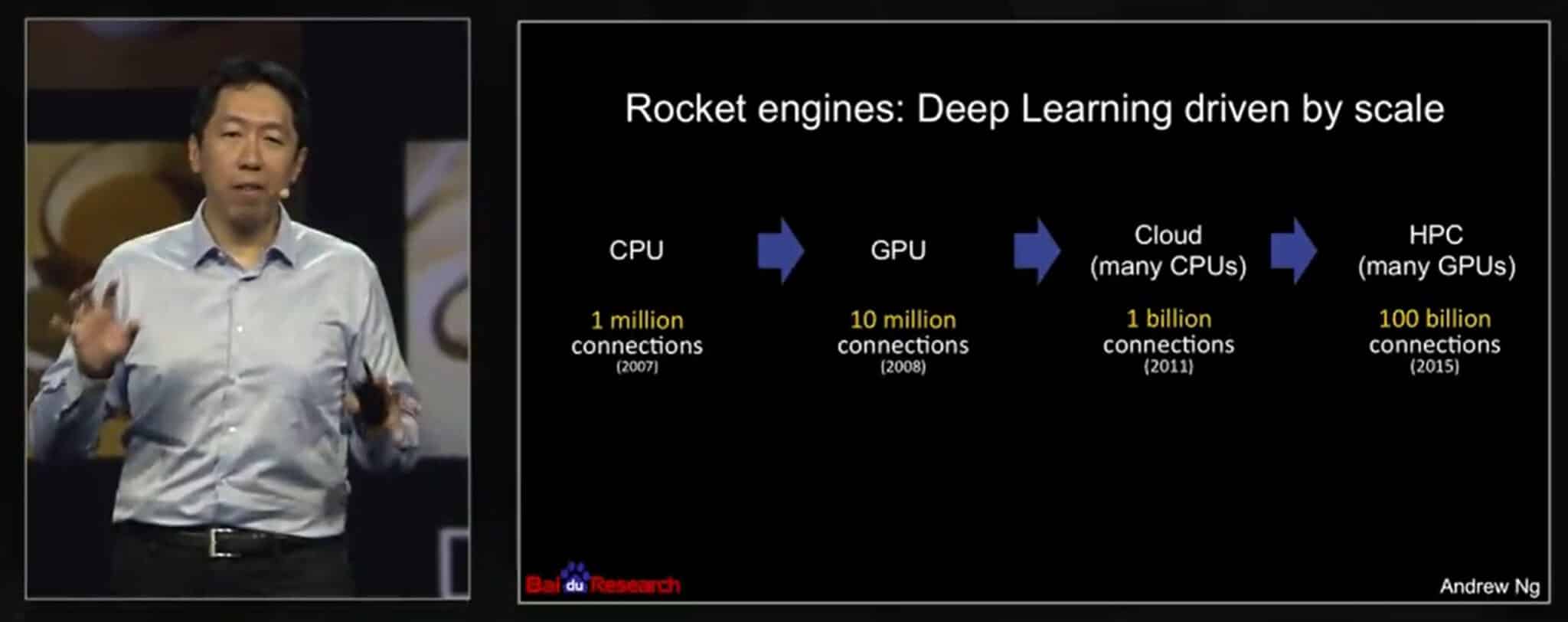

Las historias de éxito se remontan a un artículo de 2008 del pionero de la IA Andrew Ng, entonces investigador de Stanford. Con dos GPU NVIDIA GeForce GTX 280, su equipo de tres personas logró una aceleración de 70 veces en comparación con las CPU que procesan un modelo de IA con 100 millones de parámetros, terminando el trabajo que solía requerir varias semanas en un solo día.

«Los procesadores gráficos modernos superan con creces las capacidades computacionales de las CPU multinúcleo y tienen el potencial de revolucionar la aplicabilidad de los métodos de deep learning no supervisado», informaron.

En una charla de 2015 en NVIDIA GTC, Ng describió cómo continuó usando más GPU para ampliar su trabajo, ejecutando modelos más grandes en Google Brain y Baidu. Más tarde, ayudó a fundar Coursera, una plataforma de educación en línea donde enseñó a cientos de miles de estudiantes de IA.

Ng cuenta con Geoff Hinton, uno de los padrinos de la IA moderna, entre las personas a las que influyó. «Recuerdo que le dije a Geoff Hinton que echara un vistazo a CUDA, creo que puede ayudar a construir redes neuronales más grandes», dijo en la charla de GTC.

El profesor de la Universidad de Toronto corrió la voz. «En 2009, recuerdo haber dado una charla en NIPS [ahora NeurIPS], donde le dije a unos 1.000 investigadores que todos deberían comprar GPU porque las GPU van a ser el futuro del machine learning», dijo Hinton en un informe de prensa.

Avance Rápido con las GPU

Se espera que las ganancias de la IA se propaguen por toda la economía mundial.

Un informe de McKinsey de junio estimó que la IA generativa podría añadir el equivalente a entre 2,6 y 4,4 billones de dólares anuales en los 63 casos de uso que analizó en sectores como la banca, el area de la salud y el comercio minorista. Por lo tanto, no es de extrañar que el informe de IA 2023 de Stanford dijera que la mayoría de los líderes empresariales esperan aumentar sus inversiones en IA.

En la actualidad, más de 40.000 empresas utilizan las GPU NVIDIA para la IA y la computación acelerada, lo que atrae a una comunidad global de 4 millones de desarrolladores. Juntos están haciendo avanzar la ciencia, el area de la salud, las finanzas y prácticamente todas las industrias.

Entre los últimos logros, NVIDIA describió una enorme aceleración de 700.000 veces utilizando la IA para aliviar el cambio climático al mantener el dióxido de carbono fuera de la atmósfera (ver video a continuación). Es una de las muchas formas en que NVIDIA está aplicando el rendimiento de las GPU a la IA y más allá.

Descubra cómo las GPU ponen la IA en producción.